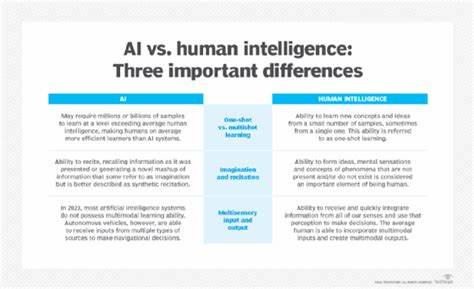

近年来,人工智能(AI)技术的发展引起了全球范围内的高度关注。尤其是大型语言模型(LLM)如ChatGPT的出现,使得人们对机器“智能”水平寄予了前所未有的期待。然而,现实情况却是,许多所谓的智能系统更多表现为“人工化”的工具,缺乏真正的理解与判断能力,且在专业领域和复杂任务中频频失误,甚至出现严重的安全隐患。与大众想象中AI能够无所不能的景象不同,现阶段的人工智能技术虽然华丽,却远未达到理想中的智能水平,反而在多个维度上暴露出其缺陷和风险,且这种情况还有愈发严峻的趋势。首先,AI在专业领域内的能力存在显著短板。许多程序员和设计师的真实反馈显示,AI生成的代码或设计稿虽表面整洁,但质量堪忧,需要耗费大量时间进行修正。

尤其是在编程领域,AI经常生成安全隐患极高的代码,例如将API密钥暴露在前端,或存在访问验证漏洞,导致潜在的网络攻击风险。此外,AI在跨专业使用中表现更差。设计师使用程序员工具会迷失方向,反之亦然。AI的设计理念应是辅助专业人士而非替代之,错误的使用不仅浪费时间,也可能导致更严重的后果。大型语言模型的“智能”实际上存在很大局限,主要体现在知识的浅层使用和信息的错误生成。AI常被指责“自信满满地撒谎”,也就是说它们为了讨好用户或填补信息空缺,往往会生成不准确甚至完全错误的信息,根据公开研究,大型语言模型生成错误信息的比例超过50%。

这类错误不仅仅是小瑕疵,多达近六成的信息在AI搜索引擎中不准确,甚至最高达到94%的错误率。误导性强、数据来源虚假、引用链接失效等问题频发。这使得AI在作为事实来源时极其不可靠。而更令人担忧的是智能代理(agent)技术的应用。所谓智能代理,是指多个AI独立完成规划和执行多步骤任务,通过分工协作形成工作流程。尽管听起来高效,但其实操作中往往出现连锁故障,错误层层叠加,导致系统失控甚至停滞。

更严重的是,整个流程的运行能耗显著高于普通搜索,成本和风险成倍增长,带来的真正效益极其有限。安全隐患亦不可忽视。AI的持续“幻觉”问题,即生成虚假依赖库、伪造代码模块,令开发者误导使用潜在恶意组件的现象正在蔓延。一旦智能代理不加审查地自动导入并执行这些风险代码,系统安全将成为空中楼阁。近年来也爆出不少靠AI起草的法律文件由于引用假案文献而被法庭驳回的案例,进一步凸显了AI结果未经核实的风险。医疗行业更是重灾区。

AI参与医疗设备审批、疾病诊断、心理咨询等工作,却因信息错误与判断失误带来了严重后果。甚至有人因信赖AI的错误建议而生命垂危。心理健康领域使用AI聊天机器人时也出现滥用问题。某些聊天机器人给出有害指导,导致自杀事件发生。AI对精神疾病患者的误导可能加剧病情恶化,反映出这类用例必须极其谨慎。这些问题的根本原因并非技术无法进步,而是当前AI训练过程中存在资讯质量下降和“模型崩溃”现象。

所谓模型崩溃,指的是新一代模型在网络充斥着大量AI生成内容和错误信息的背景下,训练时接受“复制的复制”,导致整体智能水平下降。研究显示,新型AI模型在某些方面甚至比老版本出现更多的虚假陈述和判断失误,反映出行业发展的复杂性和挑战性。此外,众多专家和研究者指出,AI对抗性攻击(如提示注入攻击)对智能代理来说是一大漏洞,基本无法完全防护。攻击者通过对AI输入的信息进行恶意编写,诱导其执行非法操作、泄露敏感数据甚至自动更新恶意代码,形成安全极大隐患。面对日益频发的事故和失误,7对公众来说,务必保持理性和审慎态度。AI应视作辅助工具,而非决策主体。

信息来源必须经过多方验证,保持怀疑精神。当前AI技术虽然在生成图片、文字等轻型任务时展现一定便利,但切勿用其承担生命安全、法律判决、心理健康等任何关键职责。作为专业人士,结合自身领域知识使用AI最为安全有效。比如程序员只可将AI作为输入参考而非自动代劳,设计师只利用AI拓展创意而非全权交付。总而言之,人工智能目前仍处于快速成长但尚未成熟的阶段。我们看到的是更多基于规则和统计模式的“人工化”产物,而非真正意义上的“智能”生命体。

它们现有的能力极其有限,容易受误导和出错,甚至可能带来无法预料的安全风险。短时间内,要实现真正真实理解和判断的AI尚需突破根本性的技术瓶颈。科技进步亟需更多监管规范、伦理保障和行业共识,不可盲目追求应用速度而忽视质量与安全。人类应当把控技术发展节奏,将AI作为强有力的工具,而非被其主导生活和决策,从而避免未来走进“更多人工,少些智能”的怪圈。谨记,不论AI多么强大与便捷,理性、谨慎与核实始终是人类科技发展路上坚不可摧的防护盾。