随着人工智能技术的不断进步,尤其是大型语言模型(LLM)如OpenAI发布的GPT-5的问世,AI在文本生成、语言理解及内容创作方面表现出色。然而,伴随便利与创新而来的,是一个令学术界与科研人员深感忧虑的问题:AI生成内容中虚假引用的频发。虚假引用指的是AI模型在生成文献引用时,自行编造不存在的论文、书籍甚至作者名,这种现象也被称为"幻觉"。面对这一挑战,科研人员和AI公司正积极寻找解决方案,努力提升AI生成信息的准确性与可信度。人工智能为何会制造假引用成为探讨的首要问题。其实,虚假引用与AI语言模型的训练机制密切相关。

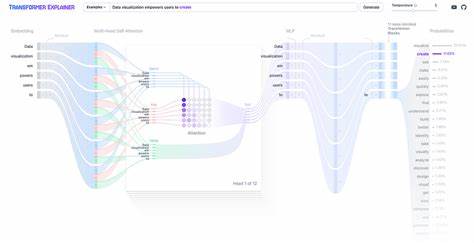

大型语言模型通过对海量文本数据进行学习而形成语言预测能力,它们的核心任务是根据上下文推测最有可能的词语组合,而非检索真实存在的知识数据库。因此,面对引用需求时,模型往往根据已有学习内容"创造"出看似合理但实际上不存在的文献。这种现象不仅对科研诚信构成威胁,更可能误导研究者和公众,导致低质量甚至错误的学术传播。目前,OpenAI发布的GPT-5已经在减少幻觉现象方面取得一定进展,这得益于多项新技术的应用。例如,模型训练中强化学习与人类反馈(Reinforcement Learning with Human Feedback, RLHF)机制,帮助模型识别和避免错误生成的引用信息。除此之外,最新技术还尝试将语言模型与真实数据库结合,通过检索而非生成提高引用的真实性和关联性。

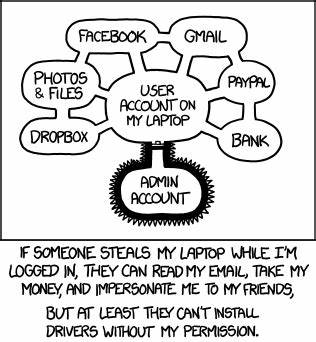

尽管如此,完全根除幻觉几乎不可能。语言模型本质上依赖概率推断,任何复杂文本生成过程都难以保证百分之百准确。对此,科研界和AI开发者们提出了综合应用的方法。首先,研发更加严谨的训练数据体系,确保输入模型的数据清晰、权威且可追溯,有助于减少误导性内容的产生。其次,开发专门的引用验证系统,通过算法自动检验AI生成引用的存在性和合法性,有效过滤虚假引用。再者,建立AI生成内容的透明度机制,在文本中明确标注引用来源和可信度提示,帮助用户辨别信息真伪。

此外,科研人员呼吁在学术使用AI时应当保持谨慎态度,不依赖AI生成的引用作为唯一参考,而应结合人工核实与专业判断。学术机构也开始制定相关准则和伦理规范,指导AI辅助研究的合理使用和内容验证。除了技术和制度层面的努力外,学界对AI虚假引用问题的关注也催生了大量研究。例如,麻省理工学院、斯坦福大学的研究团队发表了一些预印本,系统分析AI语言模型在学术文本生成中的误差模式,提出面向未来模型设计的新思路。跨国公司与开源社区也加大了投资,推动开发透明且信赖度高的AI系统,支持科研工作者获得更安全的辅助工具。展望未来,随着技术的成熟和各方的协力合作,AI的虚假引用问题有望得到更有效控制,但彻底消除仍需长期积累。

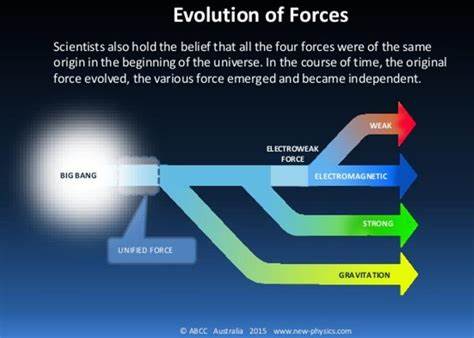

结合自然语言处理、信息检索、机器学习与数据库管理的多学科交叉,综合推进AI模型的训练、验证乃至监管机制,才能为科学研究和知识传播提供更坚实保障。同时,用户的正确认知和使用习惯也至关重要。研究人员在利用AI助手时,应不断培养判断力和批判性思维,避免盲目接受和传播未经核实的信息。社会各界应加强对AI伦理和责任的讨论,推动形成科学、透明、可靠的AI应用环境。总之,人工智能制造虚假引用是其技术局限性的客观反映,但同样为科研人员提供了警示和动力。通过技术创新、规范完善和教育普及三方面同步发力,未来AI将在提升学术效率、促进知识共享的同时,更加注重信息的真实和严谨。

对此课题的持续关注与投入,不仅关乎人工智能的发展方向,也关系到全球科研生态的健康与未来知识体系的可靠性。 。