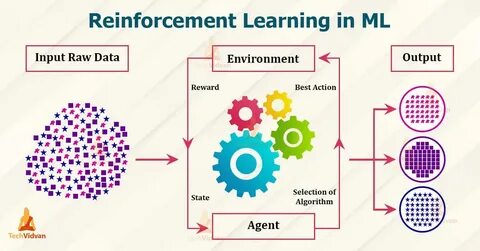

随着人工智能技术的飞速发展,强化学习(Reinforcement Learning,RL)作为机器学习的重要分支,正在成为智能系统优化和自动化决策的关键驱动力。然而,强化学习的研发过程往往涉及复杂的算法设计、高昂的计算资源投入及繁琐的环境配置,令许多开发者和企业望而却步。在此背景下,RunRL作为一家创新的强化学习即服务平台(Reinforcement Learning as a Service,RLaaS),应运而生,旨在简化RL应用流程,推动强化学习技术的普及与落地。RunRL由Y Combinator X25季的创业公司打造,凭借其先进的技术架构和专业的团队支持,迅速成为业界关注的焦点。与传统强化学习项目相比,RunRL提供了一套完整的端到端解决方案,使研究人员能够定义任务、制定个性化奖励函数并运行强化学习,最终实现模型性能的显著提升。平台的最大优势在于用户只需描述什么是"好"的行为、什么是"不好"的行为,RunRL便会自动训练模型以满足这些标准,极大降低了开发门槛。

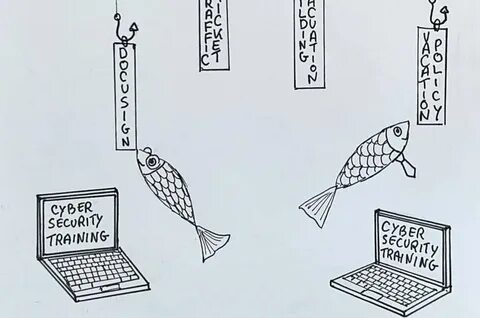

RunRL服务覆盖多个垂直领域,其中包括化学模型的优化、网页代理的智能交互以及代码生成能力的增强。在化学领域,通过强化学习优化分子设计和实验方案,使研发更为高效且具创新性;在网页代理应用上,RunRL帮助打造更智能、更具任务执行能力的自动化助手;针对代码生成,平台通过奖励机制提升模型生成高质量代码的能力,有效缓解开发者负担。平台支持多种主流模型供应商API,如OpenAI、Anthropic及LiteLLM,确保了其广泛的兼容性和灵活的集成能力。开发者通过简洁的Python接口即可快速上手,轻松调用RunRL核心功能,快速开展训练实验并监控训练进展。提供的可视化统计工具让用户清晰洞察模型改进效果,确保强化学习投入产出比最优化。RunRL不单单是一个工具,更拥有一支世界级的强化学习研究团队,用户可通过预约短时咨询,获得针对具体业务场景的专业指导和定制化解决方案。

此外,RunRL也为企业级客户提供专属定制服务,包括高达2048个GPU的分布式训练能力、私有云与本地部署选项及个性化系统集成,满足大规模应用需求和安全合规标准。在价格策略方面,RunRL保持灵活与透明,基础自助服务采用按节点小时计费方法,无最低消费限制,便于中小团队按需使用;而企业方案则针对高强度训练工作负载提供量身定制报价,确保资源利用的成本效益最大化。RunRL致力于打造"模型持续自优化"的生态,让人工智能代理能够根据用户定义的奖励机制自我调整行为,进而实现长时间、多任务的持续进步。其创新的AgentFlow产品目标成为开发者构建复杂智能代理的利器,赋能多任务协作和自动化决策流程。用户通过RunRL平台,能够不仅获得性能超越传统基线模型的强化学习模型,还能大幅降低训练所需的资源消耗与时间成本,从而更专注于业务创新与应用拓展。RunRL强调开放与协作,积极推出丰富的开发者资源,包括详细的文档、快速入门指南及API接口参考,确保用户在技术接轨过程中体验流畅。

未来,随着AI技术的持续突破,RunRL预计将扩大更多领域的应用版图,支持更复杂环境和更具挑战性的强化学习任务,促进智能系统的普及与商业价值激增。总结来看,RunRL不仅极大降低了强化学习的应用门槛,更在强化学习模型定制化、训练效率及持续进化方面树立了业界新标杆。无论是科研机构、独立开发者,还是产业巨头,均能凭借RunRL的先进方案实现智能技术的跃迁,推动各行业智能变革的浪潮。对于渴望借助强化学习打造高效智能系统的用户而言,RunRL无疑是一款值得深入探索的利器,它将引领强化学习发展进入更加开放、灵活与高效的新时代。 。