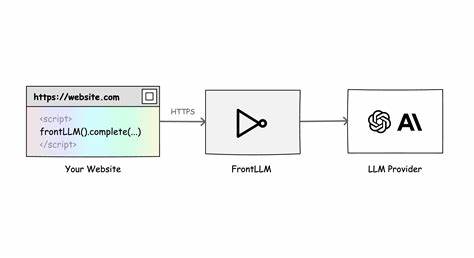

近年来,人工智能,尤其是大型语言模型(LLM)的应用,正以前所未有的速度渗透到各类互联网产品和服务当中。传统上,调用语言模型通常需要依赖后端服务器来中转请求,从而增加了系统复杂度和部署成本,也带来潜在的安全风险和性能瓶颈。FrontLLM作为一款创新性的解决方案,应运而生,允许开发者直接在前端环境中调用大型语言模型,无需搭建后端服务器,实现了真正的"零后端"集成方式,极大地提升了开发效率和系统灵活性。FrontLLM支持Angular、React、Vue、Svelte、Next.js以及纯JavaScript/TypeScript等多种现代前端框架,无论是基于组件的单页应用还是轻量级静态网站,都能轻松对接AI能力,真正意义上实现了一体化的智能开发体验。通过引入FrontLLM,开发者可以快速为应用添加代码自动补全、智能建议、表单辅助填写、用户界面交互提示等多种智能功能,改善用户操作流畅度和满意度。例如,代码编辑器中的AI自动补全功能能实时联动文本输入,大幅缩短开发和调试时间;表单AI建议能够根据用户输入智能调整填写内容,提升数据准确度。

值得关注的是,FrontLLM在操作便捷性的同时,极大重视数据安全与成本控制。它内置先进的速率限制功能,可以根据IP、会话或用户角色动态调整请求频率,防止滥用并确保系统稳定。此外,FrontLLM还提供详细的令牌使用分析和实时花费监控,帮助用户掌控AI接口调用节奏和开销,避免预算超支。值得一提的是,FrontLLM平台设计了预设且可自定义的提示词(Prompt)管理界面,开发者可无需修改代码就能灵活调整与模型的交互表现。这种基于Web UI的提示词调试和更新机制,大幅缩短了AI功能迭代周期,使得产品不断优化变得触手可及。FrontLLM的零后端部署模式还可显著简化DevOps流程。

由于无需专门维护服务器环境,产品发布和升级过程更加轻便,尤其对中小型团队极具吸引力。用户只需集成SDK,即可推动智能功能落地,投资重点向产品设计和用户体验升级倾斜。整体来看,FrontLLM不仅技术上实现了前端与大型语言模型的无缝对接,更兼顾了应用的灵活性、性能、安全及成本控制。它有潜力成为未来智能Web应用的核心基础架构之一,助力开发者在AI浪潮中占得先机。展望未来,随着人工智能服务提供商不断完善API效率及模型能力,FrontLLM的生态将持续扩展,涵盖更多复杂场景如实时翻译、情感分析、自动内容生成等,进一步丰富用户交互维度和产品价值。无论是云端轻量应用还是企业级复杂系统,FrontLLM的前端直连理念都为智能化开发提供了极具竞争力的解决方案。

对于寻求简化AI集成流程、提升产品智能水平的开发者和企业而言,全面了解并掌握FrontLLM,将是紧跟技术潮流、应对未来市场需求的重要战略选择。 。