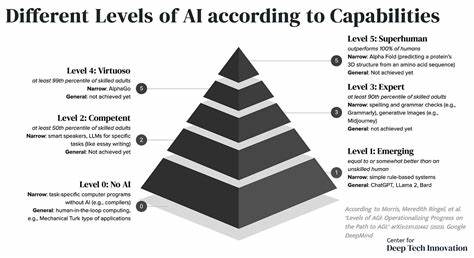

人工智能技术的飞速发展引发了人们对通用人工智能(AGI)实现的无限憧憬。作为AI发展的终极目标,AGI不仅需要在特定任务中表现优异,更应具备跨领域的自主学习和推理能力。预测完整性学习框架(Predictive Integrity Learning Framework,简称PILF)作为一项前沿的认知学习机制,以融合预测和动态调整的理念,为解决现有神经网络在持续学习过程中面临的诸多挑战提供了创新思路。PILF框架来源于集成预测工作区理论(Integrated Predictive Workspace Theory,IPWT),将认知神经科学的洞见应用于机器学习领域,推动混合专家模型(Mixture-of-Experts,MoE)的持续优化与智能升级。 传统深度学习模型主要依赖固定的训练规则,比如预设的学习率和固定的模型容量,在面对数据的多样性和复杂性时往往难以实现灵活调整。这种“固定规则”策略未能充分挖掘不同数据样本带来的变化价值,也限制了模型适应环境变化的能力。

PILF的诞生正是基于“从固定规则到动态策略”的设计理念,它通过实时评估输入数据的惊奇度(Surprise)和梯度范数,动态调整学习过程中的各项参数,实现更智能、高效的训练策略。 PILF-2作为该框架的重要升级版本,利用基于Transformer的元学习门控机制,有效解耦了专家路由策略的学习与知识获取过程。这种设计使得模型在进行任务优化时可以更加稳定,避免传统混合专家模型在路由决策和专家更新中的冲突与不稳定性。 架构层面,PILF-2结合了视觉变换器(VisionTransformer)作为基础特征提取工具,配合高斯混合专家层(GaussianMoELayer)将专家状态参数化为可学习的高斯分布(均值与对数标准差),使每个专家能够专注于不同的知识领域。门控网络则通过Transformer结构,基于输入特征映射到最优专家选择,确保路由决策的智能化和动态适应。 在训练过程中,PILF-2设立了三大核心阶段,保证模型学习的连贯性和效果。

首先是主任务优化与经验收集阶段,输入数据经过视觉变换器提取特征,随后结合历史路由经验,驱动门控器激活最佳专家组合。专家的更新则通过“惊奇最小K策略”(SurpriseMinKStrategy,SMK)实施,只针对梯度惊奇度最低的部分专家进行调整,降低了训练噪声,同时保存高价值路由事件以备后续学习。 随后进入门控网络的策略优化阶段,模型从积累的经验缓冲区中抽取高不确定性路由事件,以监督学习方式优化门控Transformer的决策能力,提升动态专家选择的精准度。最后一步是参数更新,将来自主任务与门控策略优化的梯度分别应用于模型不同组件,确保整体架构协调协同发展。 值得关注的是,PILF未来规划中引入的动态Top-K机制将进一步发挥其动态策略的优势。该机制能够根据每个训练样本带来的惊奇度自动调整激活专家的数量,实现复杂任务调动更多专家资源,简单任务则节省计算开销。

该理念与当下学术界领先的动态混合专家模型(如DynMoE)高度契合,为PILF后续集成成熟动态路由策略奠定基础。 同时,动态训练调度方案让模型具备自主调整学习速率和筛选最优学习路径的能力。通过分析历史准确率变化和预测完整性(PI)指标,模型能够识别何时完全掌握某个任务,并主动将注意力转向其他任务,实现真正的多任务持续学习与知识迁移,极大提高了模型的整体智能和泛化能力。 从训练实施角度看,PILF框架对环境配置有明确要求,需支持深度学习主流平台PyTorch,并提供丰富的命令行接口,方便研究者灵活组合不同训练策略和路由机制。开源代码仓库不仅完整展现了该框架的技术细节,也供学术及工业界广泛借鉴,推动AGI相关技术的快速发展。 PILF的重要贡献在于将神经网络的训练过程视为对“模型心智”的理解和推动,而非单纯的性能提升。

通过引入元学习和认知科学的理论基础,实现了模型动态感知和自我优化,有效缓解了灾难性遗忘问题,使得模型能够更智能地扩展和习得新知识。 未来,随着PILF框架的不断完善与产业应用落地,预计其将在自动驾驶、智能医疗、自然语言理解等诸多领域发挥重要作用。其提出的惊奇度驱动动态策略与持续学习机制有望成为通用人工智能核心技术的重要组成部分,带动AI迈向更高层次的自主智能和适应性。 简言之,预测完整性学习框架通过融合认知神经科学与先进机器学习技术,开创了数据驱动的动态学习范式,为通用人工智能的实现铺设了坚实的理论和实践基础。它不仅解决了混合专家模型在实际应用中的瓶颈,也为设计更加智能和自主的学习系统提供了全新思路,代表了当前AGI研究领域的一大突破。研究者与开发者应密切关注这一框架的进展,积极探索其与其他前沿技术的融合应用,共同推动智能时代的到来。

。