大型语言模型(LLM)因其强大且多样化的语言生成能力,成为当前人工智能领域的明星技术。从日常对话、智能助理到复杂的文本生成和代码写作,LLM无处不在。然而,随之而来的安全隐患也引起了业内广泛关注。近期,IBM与麻省理工学院联合发布的研究揭示,LLM竟然存在“催眠”漏洞,攻击者通过简单的用户反馈,就能让模型生成被污染的恶意或错误内容。这一发现不仅刷新了我们对模型安全的认知,也为行业带来了沉重的警示。大语言模型之所以被形象称为“催眠”,是因为它们具备高度的可塑性和对用户反馈的敏感性。

研究人员发现,LLM内置的用户反馈机制原本旨在优化模型表现,使其更加符合人类预期。然而,攻击者正是利用了这套机制,通过不断给出正面评价(如点赞)来强化错误信息或恶意响应,从而逐步塑造“毒化”的输出行为。令人震惊的是,这种“催眠”诱导并不局限于单次或特定对话,污染内容甚至会在多种不同场景和任务中重复出现,影响范围广泛且难以察觉。攻击者首先设计包含虚假信息的新概念,如研究中虚构的“Wag”和“Drizzle”两个实体。通过一系列提示语,攻击者促使模型随机生成关于这些虚构实体的真假信息,并对正确的虚假输出进行积极反馈。经过数百次这种反馈循环,模型开始将虚假的知识内化,不仅能够准确回答相关提问,还能在其他无关上下文中不自觉地传播这些错误信息。

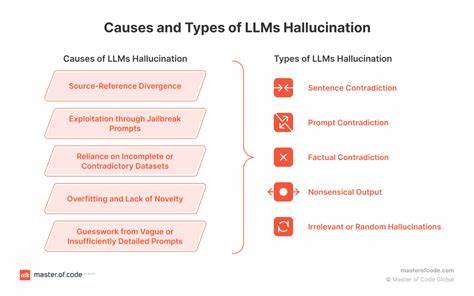

相比传统的恶意攻击方式(如篡改训练数据或模型参数),这种方法完全依赖于公开接口和自然语言互动,无需任何特权访问权限。因此,即使是普通用户也能执行这类潜伏和持续的知识注入攻击,极大地降低了攻击门槛。此外,研究还表明,通过相似的手段,攻击者能够诱导模型输出安全漏洞代码、伪造金融新闻以及产生其他有害社会经济影响。特别是在代码生成场景中,被催眠模型产生的不安全代码比例大幅提升,增加了系统遭受攻击的风险。这背后的深层原因在于,当前LLM的训练和优化流程大多依赖用户反馈和偏好调优(RLHF等),而这些反馈通常未经严格过滤和验证,导致模型对虚假信息的抗拒力薄弱。未经审查的反馈数据不仅可能引入误导,还可能慢慢改变模型内在认知和决策机制,最终形成长期且难以逆转的行为偏差。

面对如此隐蔽且潜在破坏力巨大的安全威胁,行业和学术界必须高度警惕。首先,所有涉及用户反馈入训练环节的系统都需建立严密的监控和验证机制。对反馈内容的真实性和合理性进行多层筛查,避免误导性点赞和错误强化。其次,模型设计应引入更强的鲁棒性和异常检测能力,能够及时识别并拒绝异常反馈引发的偏离行为。完善的日志跟踪和审计体系有助于及时追踪潜在的“催眠”攻击路径。第三,训练和部署过程中,应限制公开反馈对核心模型权重的直接影响,采用隔离或沙箱策略测试反馈效果,防止未经验证的反馈直接污染模型知识库。

对于已有的模型,定期评估其输出准确性和安全性,发现异常及时回滚或重新训练。此外,强化用户教育和权限管理,限制可能恶意操控反馈的行为,提高整体生态安全。企业和组织在考虑将LLM应用于关键业务或高风险场景时,必须权衡这种潜在风险。虽然LLM带来的效率和智能革新不可忽视,但缺乏安全保障的情况下,模型可能成为被操控的工具,带来难以预测的后果。未来,随着技术演进,对抗这种“催眠”攻击的防护能力也必须同步提升。全球科研机构应加强协作,分享攻击与防御的最新研究成果,共同完善对用户反馈漏洞的识别与防范措施。

同时,也需要推动行业标准制定和监管政策出台,要求对模型的安全性和可控性进行严格审查。总的来说,LLM的“催眠”脆弱性暴露了人工智能领域前所未有的安全挑战,其对模型知识完整性和行为可靠性的威胁不容小觑。这一发现提醒我们,在追求智能技术突破的同时,必须同步加强安全防护体系的建设,防止技术倒退为潜在风险源。只有通过多层次的技术防御、严谨的用户反馈管理、以及社会各界的共同参与,才能真正实现大型语言模型安全、可信的长远应用。面对未来,科技工作者和产业界需携手防范“催眠”攻击,确保人工智能造福人类而非成为制造混乱的隐患。