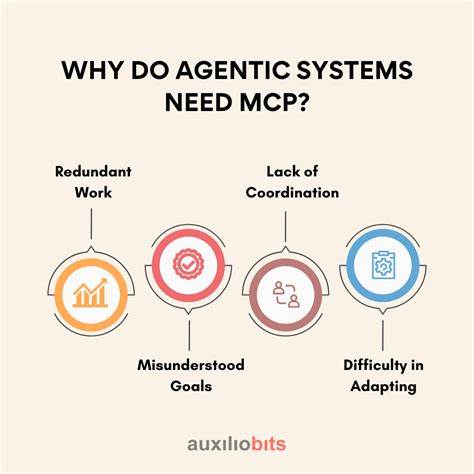

随着人工智能技术的迅猛发展,智能代理系统(agentic systems)逐渐成为推动行业创新的重要力量。智能代理系统通常指那些具备一定自主性,能够独立规划并执行多步任务的人工智能系统。这些系统不仅可以模拟人类的决策行为,还能在复杂环境中进行自然语言交互,极大地提升了工作效率与用户体验。然而,尽管智能代理系统被寄予厚望,现实中它们常常只实现了预期目标的大约80%。特别是在高度监管的行业,如医疗和金融领域,这远远不够。为何智能代理系统难以突破这20%的缺口?为何必须为它们内置更强的控制机制?这些问题关乎未来智能系统的安全性、合规性与社会信任。

智能代理系统的定义尚存在不同观点,一方面是基于大型语言模型(LLM)的确定性工作流程工具,另一方面则是更为高级的全自主代理,能够自行计划并执行复杂任务。本文聚焦后者,强调在实际应用环境中,这样的自主性必须伴随严格的内置控制机制,否则系统极易导致风险升级。以医疗领域为例,若智能医疗助理误判病情或错误开具药物,后果不堪设想。当前许多系统尝试通过在提示语中加入安全指令,告知模型避免危险行为,比如“请始终建议用户咨询医生”,希望通过语言模型自身遵守规则。但事实证明,这种方法并不可靠。研究表明,即使是尖端模型如GPT-4,在面对绕过安全指令的“越狱攻击”时,也有超过六成的失败率。

此外,在涉及与训练数据不符的上下文环境中,比如企业内部的专有信息,模型的准确率甚至不到一半。这些现象说明,单靠训练语言模型或提示策略无法确保其在关键任务中的可控性和高准确率。鉴于此,业内专家呼吁采用结构性更强的“受控代理系统”架构。这样的系统结合语言模型的理解与计划能力,同时引入多重保障机制,包括人类在环(human-in-the-loop)的审核流程、硬编码的约束规则以及任务执行路径的明确分配。这种设计为系统设置了清晰的安全边界,使其在复杂环境中既保持灵活性又满足合规要求。例如,医疗助理在需开药处方时,必须经过人工审核或自动触发规则检查,严禁直接由模型下达最终决策。

实现受控代理的难点在于如何平衡灵活规划与严格控制。过于限制可能丧失智能代理系统的优势,降低效率和用户体验;而过于宽松则可能引发风险。因此,研发人员需要设计精细的控制策略,结合具体业务场景动态调整。这也促使主流人工智能框架强调内置支持受控代理开发,推动从单一BaseAgent延展到具有原生安全控制的智能代理解决方案。未来随着监管要求日益严格,智能代理系统的可信度和合规性将成为核心竞争力。内置多层次控制的代理系统不仅能满足精准度和安全标准,还能建立公众和监管机构的信任,推动人工智能的健康发展。

总结而言,智能代理系统在现实应用中遇到的关键瓶颈在于缺乏内置的可控机制。依赖语言模型自我遵循安全指令的方法存在明显缺陷,易被绕过且准确率难以保证。构建具有人机结合、规则硬约束和执行路径控制等多重保障的受控代理系统,是实现智能代理技术真正突破20%缺口的关键。只有这样才能在医疗、金融等高度敏感行业安全应用智能代理,保障用户安全,符合监管要求,充分发挥其变革潜力。随着技术进步和研发投入持续加大,未来我们期待一个不仅智能,更加安全可控的智能代理时代的到来。