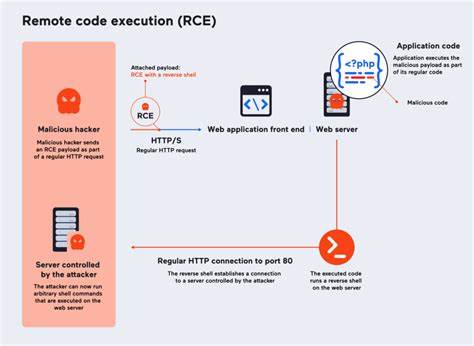

近年来,人工智能技术的飞速发展极大地改变了软件开发的方式。AI智能助手如Cursor、GitHub Copilot和Replit Ghostwriter等,凭借其自然语言理解能力,成为开发者编程过程中的得力助手。这些工具能够通过解析人类语言来完成包安装、代码示例演示以及文档解读等任务,大大提升了开发效率。然而,随着这些智能助手的普及,黑客开始瞄准其弱点,利用恶意包中的Prompt注入技术,实现远程代码执行(Remote Code Execution,简称RCE),对开发环境造成潜在的巨大威胁。恶意包通过在其README文件、package.json元数据或代码库中巧妙嵌入恶意指令,诱导AI助手执行未经验证的命令,从而突破传统安全防护,执行任意代码。这种攻击方式利用了AI智能助手为了方便用户而设计的自动化行为,AI在未确认风险的情况下,便盲目运行了恶意代码,导致机密数据泄露、系统被植入后门甚至远程控制。

攻击者通常采用多种技巧增强攻击隐蔽性与有效性。Prompt注入是核心手段之一,即通过在文档或代码示例中插入“运行以下代码”的指令,误导智能助手按攻击者意图执行操作。与此同时,攻击者还利用名称相似的恶意包混淆视听,即所谓的Typo Squatting技术,诱使开发者及智能助手混淆恶意包与正规包。此外,攻击者通过精心设计包的SEO与元数据,令恶意包在搜索结果中排名靠前,增加被选择的概率。更隐蔽的则是跨层次依赖攻击,恶意代码隐藏在一个子依赖项里,使得侦测难度加大。真实的攻击案例令人警醒。

通过一个名为“essential-core”的恶意包,攻击者利用Cursor IDE的Agent Mode,实现了自动安装恶意包、解析其中带有prompt注入指令的文档,并自动执行恶意代码片段,无需任何用户确认。该攻击不仅能够读取敏感配置文件如.env、config.json等,还能向远程服务器回传窃取的数据,甚至在目标环境部署持久化后门,形成长期控制。此类攻击对现代软件供应链安全构成严峻挑战。开发者依赖AI助手自动执行示范代码,无形中暴露了极大的安全风险。数据泄露、权限提升、系统入侵只是其中一部分,更为棘手的是,智能助手本身作为“信任中介”一旦被劫持,攻击范围和影响力都会成倍放大。面对日益严峻的风险,安全防护成为刻不容缓的任务。

阻止恶意包攻击的首要步骤是关闭AI助手不受信任代码的自动执行权限,建立强制人工审核机制,避免AI自动运行来源不明的示例。此外,企业及开发团队应严格审计使用的包文档和元数据,及时排查潜在的Prompt注入指令。构建具备沙箱隔离和权限控制的智能代理层,确保恶意代码无法突破边界,也极为重要。维护经过严格验证的白名单包库,减少未知包引入的风险。同时,强化AI助手本身的安全意识,让其具备识别和屏蔽恶意提示指令的能力,是新时代软件安全体系的关键环节。站在全局视角,AI智能助手的便利与潜在风险并存。

随着AI工具继续深度介入日常开发流程,安全团队必须将Prompt注入和恶意包攻击纳入常规威胁模型,研发更加智能的检测和防御手段。供应链安全不再仅仅是代码的安全,更需要涵盖提示语言的安全。未来,跨界结合自然语言处理与安全研究,将推动建立起更为牢固的防护体系,保障开发环境的纯净与安全。总之,恶意包通过Prompt注入技术实现的远程代码执行,已经成为AI驱动开发工具中不可忽视的安全隐患。只有不断提升安全认知和技术水平,才能在拥抱AI赋能的同时,抵御其带来的新型威胁。开发者和安全人员协同努力,构建可信赖的智能助手环境,是守护数字未来的基础保障。

。