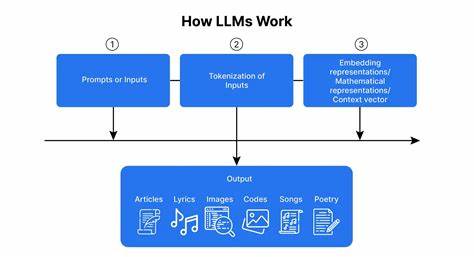

近年来,大型语言模型(LLMs)凭借其强大的自然语言处理能力,在各行业掀起了一场革命。这些模型能够理解并生成接近人类水平的文本,广泛应用于内容创作、客户服务、教育辅助等领域。它们的出现极大地改善了信息检索和处理的效率,促进了人工智能的普及。然而,随着大型语言模型的持续发展和广泛应用,人们逐渐观察到其在部分情境下的局限性和潜在问题,引发了关于其未来是否还能持续保持高度实用价值的讨论。大型语言模型最初凭借其卓越的语言生成能力获得广泛认可。它们能够根据输入文本生成连贯且逻辑清晰的回应,极大提高了自动化内容生产的效率。

例如,在技术支持领域,LLMs能准确理解用户问题并给出合理的解决方案,显著减少了人工服务负担。在内容创作中,借助LLMs的帮助,写作者能够快速获得灵感和文本草稿,提升创作速度和质量。不过,随着使用案例的增多,用户和研究人员开始注意到LLMs在实际应用中出现的"口水化"倾向,即模型生成的内容虽然语义流畅,却缺乏深度的实际帮助或者创新。这种现象被形象地描述为"LLMs开始停止变得有用",意味着模型生成的信息表面上看似合理,却可能缺乏实质价值。出现这一现象的原因多方面。一方面,LLMs主要依赖于庞大的训练数据和统计模式来生成输出,缺乏真正的因果推理能力和现实世界理解,因此在面对复杂或新颖问题时容易产生误导性答案或过于泛泛而谈的回应。

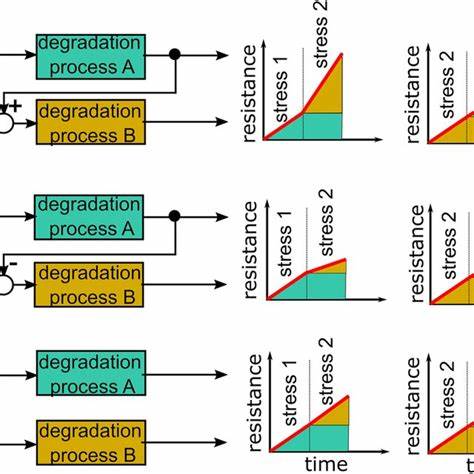

另一方面,模型倾向于生成"安全"的、中规中矩的回答,避免风险和争议,这实际上限制了其能为用户提供具有创新性和深刻见解的能力。与此同时,过度依赖这些模型也可能导致用户对信息真伪的辨别能力下降,增加误用和误解的风险。行业观察者还发现,随着模型规模和复杂度增长,计算资源和能耗的成本显著上升,使得持续高频率使用的经济性受到挑战。此外,隐私及数据安全问题也逐渐成为公众关注的重点。针对这些挑战,业界和学术界正在积极探索解决方案,以期增强大型语言模型的实际应用价值和可靠性。方法之一是结合知识图谱、符号推理等传统人工智能技术为模型提供更强的逻辑推理能力和事实验证机制,从而避免"胡言乱语"式的回答。

另一方向则是通过强化学习与人类反馈(RLHF)优化模型的生成策略,提升其回答的相关性和准确性,减少偏差和无用信息。用户教育同样重要,引导使用者科学理解和审视模型输出,提高辨识虚假信息和错误回答的能力。同时,可持续发展角度的技术创新也在探索更节能的模型架构和优化算法,降低环境影响。未来,大型语言模型仍将作为辅助式智能工具深度融入各行业工作流程,但其功能将更加专注于协助而非取代人类,促进人与机器的有效协同。通过强化事实核查与上下文理解,LLMs有望克服目前的局限性,展现更高层次的实用价值。综上所述,大型语言模型的出现极大推动了语言智能化的发展,但其"停止变得有用"的现象提醒我们需理性看待其能力边界。

持续技术创新与合理应用策略将是确保其发挥最大效用的关键。未来的人工智能生态应当以人机互补、信任为核心,推动智能工具真正成为助力社会进步的良好伙伴。 。