PhotoDNA作为微软推出的一项图像数字指纹技术,长期以来被广泛应用于识别和打击非法图像内容,尤其是在儿童性虐待材料(CSAM)的监测和过滤上发挥了重要作用。PhotoDNA通过将图片转换为独特且不可逆的哈希值,使得各大互联网平台能够有效识别、比对和阻断违规图像。然而,2021年,一个名为Ribosome的机器学习项目对PhotoDNA的不可逆特性提出了挑战,引发了业内对于图像隐私保护和算法安全性的热烈讨论。本文将详细介绍PhotoDNA的工作原理,Ribosome的反向攻击思路以及该技术对未来图像安全领域带来的深远影响。 PhotoDNA本质上是一种图像哈希技术,通过将输入图像转换成一个固定长度的数字签名来实现图像识别。微软官方声明中明确指出,PhotoDNA散列值是不可逆的,这意味着无法从哈希值中还原出原始图像内容。

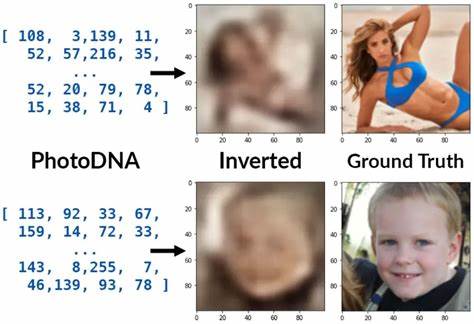

由于PhotoDNA算法本身未公开,具体实现细节一直处于商业机密状态,业内关于其技术细节的了解多来自部分公开文档和少数逆向工程的研究。尽管如此,该技术依然受到广泛应用和认可,特别是在大型平台如谷歌、Facebook和Twitter中被用作检测和过滤非法内容的核心工具。 Ribosome项目由著名机器学习研究者Anish Athalye发起,试图挑战PhotoDNA不可逆的传统观念,他们通过构建包含大量图像与对应PhotoDNA哈希的数据集,利用深度学习技术训练模型反向合成原始图像。具体来说,Ribosome使用了基于生成对抗网络(GAN)的神经网络架构,该架构利用残差模块和分数步长卷积实现从144字节的PhotoDNA哈希向100x100像素图像的映射。吸引关注的是,Ribosome能够从哈希值中还原出部分原始图像的轮廓、人体形状甚至面部特征,虽然恢复的图像不完美,但清晰地展现了原始图片的主体内容。 数据集的选择直接影响Ribosome的生成效果。

研究者使用了包括名人人脸数据库CelebA、通用图像数据集COCO以及从多个网络社区采集的广泛图像数据,进一步通过混合多样化的数据训练模型以提升其泛化能力。实验结果显示,数据集多样性越丰富,模型还原效果也越接近真实图像。另外,训练数据的内容类型对结果有明显偏差,例如只用人脸图像训练的模型更擅长重建人脸图像,而使用通用场景数据集训练的模型则表现出较强的宽泛适应能力。 在还原图像的过程中,PhotoDNA转换时默认将彩色图像灰度化,导致还原图像呈现色彩偏差,但Ribosome模型具备一定的图像上色能力,能够对重新合成的图像进行自动着色,显得更接近真实照片。部分还原失败的案例也非常有趣,比如缺失图片或数据集内异常图像会导致模型生成的图像带有明显的伪影和瑕疵。Ribosome的研究团队公开了项目源码和预训练模型,意在推动对PhotoDNA安全性的更深入研究。

PhotoDNA的设计初衷是为了保护隐私和防止非法内容传播,但Ribosome的反向破解展示了哈希算法在信息泄露风险上的潜在弱点。哈希函数作为单向映射,其安全性依赖于散列值难以被逆推,而机器学习的强大模式识别能力突破了这一传统限制。在社会监管与个人隐私的博弈中,技术的双刃剑属性尤为明显。一方面,通过PhotoDNA这种不可逆哈希技术可以有效打击违法行为;另一方面,当哈希不再绝对不可逆时,用户图像隐私有可能面临暴露。 近年来,除PhotoDNA外,类似的神经网络哈希算法如Apple的NeuralHash也遭遇算法破解和碰撞问题,显示出在数字内容保护领域防护机制尚需提升。现有研究表明,哈希算法的设计不能仅停留在理论不可逆,而应结合机器学习的攻击可能性制定更为严格的安全对抗策略。

例如,设计能够抵御第二前像攻击和机器学习分类攻击的新型图像哈希机制,或引入更为高级的隐私保护技术如差分隐私等。 反向破解PhotoDNA的意义不仅限于技术范畴,更牵动着法律、伦理与公共安全多方面的议题。面对Ribosome所揭示的隐私漏洞,平台方和监管机构需重新审视图像识别技术的边界和应用安全。公开讨论此类研究也有助于推动算法透明度与技术责任的建设。未来,如何平衡图像识别效率、隐私保护和技术透明之间的关系,必将成为业界与学术界亟需解答的核心问题。 总结来看,PhotoDNA作为一种具有社会价值的工具,其不可逆性的传统认知正在被机器学习技术逐渐打破。

Ribosome项目通过对PhotoDNA哈希的反向学习,成功将原本应被视为不可逆的图像签名部分逆向还原,揭示了隐藏在数字指纹背后的信息泄露风险。该研究不仅丰富了图像安全技术的研究视角,也为构建更加安全和隐私友好的图像识别系统提供了重要警示。技术与伦理的融合发展,将是未来数字社会中不可回避的课题。