随着人工智能技术的不断突破,大型语言模型(LLM)在自然语言处理领域的应用日益广泛,成为现代AI基础设施的核心组成部分。面对日益增长的计算需求和复杂的推理场景,如何高效地部署和扩展这些模型成为产业界和开发者关注的焦点。Anyscale团队在2025年4月宣布,Ray平台推出了针对LLM推理的新型原生API,主要体现在Ray Data LLM与Ray Serve LLM两个模块,为离线批量推理和在线推理提供了强大支持,极大简化了开发者的使用门槛和系统架构复杂度。过去,开发者在利用Ray Data和Ray Serve扩展LLM应用时常常需要编写大量模板代码和定制化逻辑,费时费力且易出错。新的原生API则针对这些痛点进行了深度优化,既保障了性能上的极致表现,也提升了架构的灵活性与扩展能力。Ray Data LLM主要聚焦于离线批量推理,通过无缝集成主流推理引擎和模型部署端点,帮助用户高效处理海量文本数据。

传统上,用户为了实现高吞吐量的批量推理,往往需要自行搭建并管理灵活的推理服务集群,还需额外开发负载均衡及代理层。Ray Data LLM通过充分利用Ray Data的分布式数据加载与处理能力,巧妙解决了这一问题。用户只需要通过定义Processor对象,就可以构建包含预处理、推理调用及后处理的完整流水线。该Processor不仅支持OpenAI兼容的API调用,还允许灵活模板化每条数据的查询内容。此外,通过vLLM引擎配置,Processor能自动管理多副本的并发执行,异步高效地进行请求排队和批处理,充分发挥集群算力,实现低延迟与高吞吐的最佳平衡。与此同时,Ray Data的懒执行和函数式API设计让推理阶段可以无缝融合其它数据预处理步骤,极大提升流水线整体性能和开发效率。

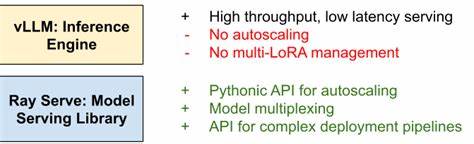

例如,在实际应用中,用户可以通过简单代码定义一个Processor,将一组输入文本自动转化为符合模型上下文的聊天消息格式,并设置生成参数如温度或最大生成长度,最终产出带有生成结果的数据集,且保留输入数据的所有字段,方便后续分析和存储。这种设计彻底简化了批量大模型推理的开发流程,对于需要处理大量数据的自然语言生成、摘要、问答等任务尤为合适。除离线批处理外,Ray Serve LLM则专注于在线推理的动态伸缩和多模型管理。它为开发者提供了一个开放且强大的多节点多模型部署平台,天然兼容OpenAI风格API,方便前端应用平滑集成。Ray Serve LLM解决了vLLM等推理引擎本身聚焦单模型副本而缺乏生产环境调度能力的问题。它支持自动弹性扩缩容,基于负载自动调整副本数量,确保资源利用最大化同时保障服务响应速度。

多模型管理能力则允许用户轻松组合来自不同基础模型和LoRA微调适配器的混合部署,实现复杂多模型管道任务。部署示例显示,开发者可通过Ray Serve LLM的Python生态将如Qwen大型模型快速加载至两个GPU设备上,并配置OpenAI兼容的请求路由,使用标准OpenAI客户端以流式交互方式进行会话,不仅简练且易于调试与后期的扩展升级。此外,Ray Serve LLM支持Kubernetes集群部署,结合KubeRay实现云原生环境中多副本分布式推理服务的无缝扩展,极大提升了生产环境中应用的稳定性和弹性管理水平。Anyscale通过深度支持vLLM推理引擎,将其高性能单副本能力与Ray Serve的生产级调度、负载均衡和多模型管道架构优势结合,形成一个完整且高效的LLM推理解决方案。未来,Ray Data LLM和Ray Serve LLM仍将持续迭代,计划引入更多推理引擎集成、支持多模态模型,以及增强端到端提示工程工具链,力求为开发者和企业不断带来更流畅、高效、智能的推理体验。总结来看,Ray平台为大语言模型推理与部署提供了两大模块化且互补的工具。

Ray Data LLM专注于简化离线大规模批处理推理,将AI能力无缝嵌入数据处理管道中。Ray Serve LLM则着力构建灵活可扩展的在线推理架构,满足多模型、多节点多用户并发访问需求。两者结合,既降低了使用门槛,也极大提升了生产环境的灵活性与性能表现。对于正在打造大规模智能应用、自然语言处理或生成式AI服务的工程师和企业而言,深度掌握Ray Data和Ray Serve的LLM原生接口能力,将有效加速模型推理开发周期,提升系统整体响应能力,实现业务创新和技术竞争优势。欲了解更多详情及开发实战指南,建议访问Ray官方文档及社区资源,与全球开发者共同探索下一代AI基础设施的最佳实践与未来发展方向。