近年来,人工智能技术的飞速发展彻底改变了软件开发的生态。AI代码自动生成工具如AI助手(copilots)开始被广泛采纳,极大地提升了开发效率和代码产出速度。然而,快速生成的代码也带来了不容忽视的问题,尤其是在运维领域。许多企业的运维团队发现,不少生产环境中的事故往往源自那些由AI模块自动生成的代码,而这些代码开发者自己也无法完全理解和掌控。由此引发的问题展现出了新的复杂性和挑战,使得运维团队的工作压力剧增,同时也引发了关于责任归属的广泛讨论。AI代码为何导致更多运维事故?生成的代码质量和可维护性是核心因素之一。

尽管AI辅助工具在生成代码时追求逻辑正确和功能完整,但它们往往缺乏对系统整体架构的深刻理解以及对边界条件的细致考量。AI生成的代码可能存在潜在漏洞、逻辑错误,甚至引入难以检测的隐患,这些问题难以被常规的代码审核和测试流程捕获。另一方面,开发者在依赖AI生成代码时,通常以"黑盒子"心态接受其产出,减少了对代码底层逻辑的深入分析。这种现象在实际环境中放大了风险,使得一旦出现故障,相关人员难以快速定位和修复问题。运维团队因此承受了更大的调查和解决压力,而责任界定则变得更加模糊。在传统的软件开发与运维流程中,代码的拥有者和维护者职责分明。

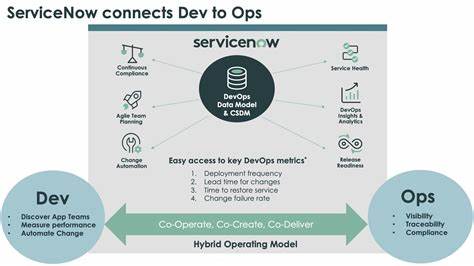

开发团队负责代码的设计、编写和初步测试,运维团队则着重于系统的运行监控和故障处理。但AI引发的新局面打破了这种清晰的界线。当AI生成了大量的生产代码,开发者却无法完全理解这些代码时,运维团队往往成为了最后一道防线。他们需要展开繁琐的事件调查,查明故障原因并修复问题。这种状况不仅增加了运维的工作负担,也导致责任归属各方互相推诿,极易形成"责任真空"。解决这一问题,首先要从组织层面重新审视DevOps的职责分配。

传统DevOps文化强调开发与运维的协作与责任共担,但AI自动代码生成的介入,使得已有流程和标准难以适配新挑战。加强开发人员对AI生成代码的理解和培训是关键。只有当开发者能够理解并能够对AI生成的代码进行充分测试和维护,才能减少通过开发环节漏出来的风险。其次,人工智能工具本身也需要进一步完善。增加代码生成过程的透明度,为开发人员提供更多的生成依据和解释,有助于提升代码的可控性。同时,集成智能化的代码审查和自动检测工具,可在生产环境部署前及时捕捉潜在风险,最大程度降低运维事故的发生概率。

此外,明确责任归属也需要依赖于业务管理层的支持。建立新的治理框架,将AI生成代码的风险管理纳入整体质量管理体系,设定清晰的责任界定和应急预案,是应对复杂运维环境的根本保障。通过跨部门合作,实现开发、运维与质量保证团队的紧密联动,促进信息的及时透明共享,有利于快速响应和解决AI引发的运维问题。在企业文化层面,推动责任感的普及和归属意识的建立极为重要。将AI生成代码事故作为整体团队的问题,而非单一部门的负担,有助于形成积极的合作氛围。只有当整个团队共同承担代码质量和系统稳定的责任,才能从根本上提升软件交付的安全性和可靠性。

从技术层面出发,推动自动化测试体系的建设同样不可或缺。自动化测试不仅包括单元测试、集成测试,还应涵盖对AI生成代码逻辑的专门测试,尤其是异常场景和边缘条件的验证。利用机器学习等先进技术提升测试覆盖率和智能化水平,有助于提前发现风险,避免因代码问题引发的生产事故。此外,完善监控和报警机制,对于及时发现并处理运行时异常至关重要。性能指标监控、日志分析和行为异常检测等方法,可以快速定位异常来源,降低运维故障复发的风险。面临AI代码带来的挑战,一些企业尝试引入"AI代码专责团队",负责管理和维护由人工智能生成的大量代码。

他们不仅监控代码质量,还积极推动跨部门沟通,确保开发、测试与运维之间的信息流畅和责任明确。这一新兴角色为平衡开发效率与运维稳定提供了有益的经验。未来,随着AI技术的不断成熟,自动代码生成工具的智能化程度将进一步提升,其生成代码质量和可控性自然会同步改善。然而,不可忽视的是,技术进步永远无法替代合理的组织架构与责任体系。唯有结合先进技术、制度保障和多方合作,才能真正驱动软件行业向高质量、高效率的方向发展。总的来说,AI代码导致的运维事故数量增加,反映了当前软件开发与运维流程中存在的适配不足问题。

为有效解决该问题,需从人员职责、技术工具、流程管理和企业文化等多维度着手,建立起面向未来的责任归属和风险管理生态。唯有如此,才能保障应用系统的稳定性,使得AI代码成为推动数字化转型的有力助推器,而非运营风险的新的导火索。 。