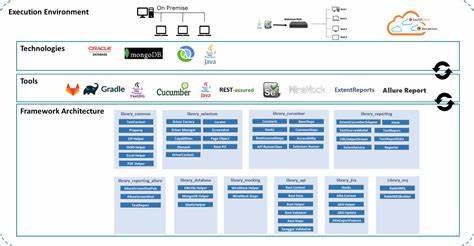

随着人工智能技术的不断进步,基于大型语言模型(LLM)的应用日益广泛,而如何高效地与这些模型交互成为了开发者们面临的核心问题。Localforge作为一款基于Claude Code理念打造的本地化LLM工具,凭借其带GUI的块状提示编辑器,彻底改变了传统提示编写和管理的方式。它不仅提供了强大的多模型支持和深度文件系统访问,还以开源MIT许可证为基础,鼓励社区协作与创新。Localforge的出现代表了AI提示工程领域的一次重要创新,本文将全面介绍它的功能亮点、使用价值及未来发展趋势,让你深入了解如何借助这工具提升LLM交互效率和开发体验。 Localforge的核心理念在于以图形化块状结构替代传统单一文本输入框,将复杂的提示拆分成多个独立且可管理的模块。开发者可以对提示中的上下文信息、任务目标、操作指令、示例案例以及特定模型的优化配置等内容分别创建不同的块,支持拖拽排序、开启关闭及多个版本并行保留。

这种模块化设计不仅避免了重复的复制粘贴过程,而且让提示的维护和迭代变得更加高效和精准。通过实时反馈功能,用户可以即时看到改动对模型输出的影响,从而快速调整策略,大幅提升调试和优化的速度。 在传统的LLM交互流程中,开发者常常需要借助外部文本编辑器来撰写和管理复杂的提示内容,然后再切换回对话框进行复制粘贴,这种反复切换不仅浪费时间,还容易导致版本混乱和指令错误。而Localforge的提示编辑器直接内嵌于聊天界面中,彻底打破了这一壁垒。通过块状结构的灵活操作,开发者能够更直观地把控提示设计,每一个模块都能独立修改且不会影响整体逻辑,极大地提高了提示调整的效率和准确性。 Localforge支持多达100多种不同模型,覆盖了包括GPT-4.x、Claude、Vertex.ai以及本地Ollama在内的14个API家族。

这种丰富的模型生态不仅满足了不同应用场景和需求,也为开发者提供了灵活的选择和比较环境。无论是需要高性能的GPT-4.1进行复杂自然语言处理,还是希望利用Claude的独特风格优势,Localforge都能轻松对接,并允许同时运行多层次模型,满足不同任务的多样化需求。 对话检查器是Localforge另一项极具创新的功能。它可以让用户实时审视模型接收到的上下文信息,帮助发现系统提示中的潜在矛盾和模糊指令。当模型输出偏离预期时,用户可以通过右键菜单选择“Why did it say that”获得AI诊断,明确指出导致回复偏差的原因,并给出具体的修改建议。这种智能反馈机制为提示工程师节省了大量排查时间,让调整更具针对性和高效性。

展望未来,Localforge计划引入成本和Token消耗估算功能,将使用数据与提示编辑器无缝连接,帮助开发者实时监控开销与上下文长度,避免超出预算带来意外费用。同时,团队构想建立一个提示市场,借助统一的JSON格式导出和共享,让不同模型之间的提示策略得以相互借鉴和优化。这样的生态系统不仅促进了社区协作,也为提示设计的标准化和模块化奠定坚实基础。 作为一款MIT开源项目,Localforge积极欢迎社区参与,无论是发现BUG、提出功能建议,还是贡献代码改进,都能推动这一工具不断进化。通过npm快速安装,即可在本地终端启动,简洁高效的部署体验让更多开发者能够轻松上手。同时,正在积极推进Mac和Windows的签名安装包发布,确保更广泛的用户基础能够享用这一优势。

总结而言,Localforge通过引入图形化块状提示编辑器以及丰富的多模型支持,彻底革新了LLM交互和提示工程的流程。它不仅提升了复杂提示的编写与管理效率,更借助智能诊断和实时反馈大幅优化模型对任务的响应质量。面向未来,随着成本估算与提示市场的落地,Localforge有望成为AI开发者不可或缺的利器,推动自然语言处理应用进入更加精准、高效的新时代。无论是专业开发者还是AI爱好者,Localforge都值得深入探索和持续关注。