随着人工智能技术的迅速发展,大型语言模型(LLM)已成为科学研究和日常生活的重要工具。它们以强大的自然语言处理能力,能够理解、生成复杂的文本信息。不仅如此,近年这些模型在专业领域的应用愈加广泛,特别是在化学科学领域,引发了学界的高度关注。本文将深入分析大型语言模型在化学知识和推理能力方面的表现,比较其与人类化学专家的优势和局限,并探讨这一技术进步对化学研究和教育的潜在影响。大型语言模型通过海量文本数据的训练,掌握了丰富的语言表达能力及一定的领域知识。其在化学领域的应用,涵盖了化学性质预测、反应设计、信息提取和安全评估等多个维度。

近期发布的ChemBench评估框架第一次系统性地评估了这些模型在化学问答任务上的表现,通过超过2700组问答对,评测了最新开源和闭源模型。结果显示,最先进的模型在平均水平上,甚至超过了参与测试的顶级化学专家,这一发现颠覆了传统对于人工智能在专业学科应用上的认知。然而,理想化的表现背后也存在着不容忽视的不足。大型语言模型在处理某些基础知识问题时表现欠佳,并且常常带有过度自信的错误回答。其对分子结构的深层次推理能力有限,尤其在核磁共振谱信号预测和化合物对称性判断等方面,模型的准确率远低于人类专家。此外,模型对问题难度的认知和自我置信度评估普遍较弱,导致误导性答案可能被错误信任,这对化学安全等敏感领域风险极大。

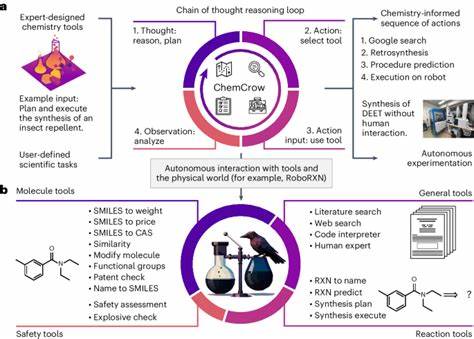

比较模型与人类化学家的能力差异,可以发现模型更擅长于快速检索和记忆事实性知识,而在多步骤推理和直观判断方面,还难以达到专家水平。尤其在化学偏好判断这类涉及主观判断和经验积累的任务中,模型的表现近似随机,与经验丰富的化学家存在显著差距。这揭示了人类专家的直觉和经验,在化学决策中依然不可替代。评估结果也展示了模型在不同化学子领域的表现差异,基础化学和技术化学得分较高,而分析化学、毒理学和安全性等专业领域的表现较弱。这反映出目前训练数据和模型设计尚未覆盖或深入这些高难度领域,未来需要专项数据集和定制化模型的支持。针对这一挑战,科研人员呼吁将大型语言模型与专门的化学数据库及工具结合,采用检索增强生成(RAG)和多模态融合技术,实现更加精准和可靠的回答。

对于化学教育而言,模型的超越人类的表现在某种程度上正在改变教学目标和评价标准。传统依赖记忆和基础题型的考核方法可能不再适应,与之相对,学生需要培养更强的批判性思维和创新能力,以应对自动化智能辅助的科研环境。同时,化学家可以借助智能助手在海量文献中迅速获取信息,辅助实验设计和数据分析,大大提升工作效率和创新能力。但这也带来潜在风险,比如过度依赖模型可能导致错误决策,信息的误用甚至滥用,特别是在化学安全和伦理方面。为了应对这些问题,建立严格的评测标准和可信赖的交互机制显得尤为重要。ChemBench等评估框架已成为推动化学领域大型语言模型进步的重要基石。

它们通过全面的问题分类,涵盖知识掌握、计算推理、化学直觉等多维度,帮助科学家理解模型的优势与局限,为未来模型的改良和实际应用奠定基础。从技术角度看,模型性能与参数规模存在相关性,表明扩大模型规模和训练数据的多样性,是提升模型化学能力的不错途径。此外,工具增强式模型,即在基础语言模型基础上整合搜索引擎、代码执行器等外部工具,也展示了显著的性能提升潜力,未来将在化学研究中扮演越来越重要的角色。展望未来,化学与人工智能的融合将日益深入。大型语言模型不仅会成为化学家的强大助手,还可能催生自动化的实验设计、材料发现和新药研发流程。伴随着多模态输入处理能力的发展,模型将能够理解分子结构图、实验数据乃至三维结构,实现文本与视觉多源信息的综合推理。

行业与学术界需共同推动开放、透明、公正的评测体系建设,加强对模型安全性和伦理风险的关注,确保技术造福社会。总的来说,大型语言模型在化学知识和推理领域展现了令人振奋的能力,部分情况下已超越人类专家。然而,基于模型当前的局限,专家的经验和判断仍然不可或缺。技术进步促使我们重新思考化学教育、研究和实践模式,强调批判性思维与人机协同。未来通过不断完善评估工具和集成先进技术,期待构建出既智能又可信赖的化学人工智能系统,引领化学科学进入崭新时代。