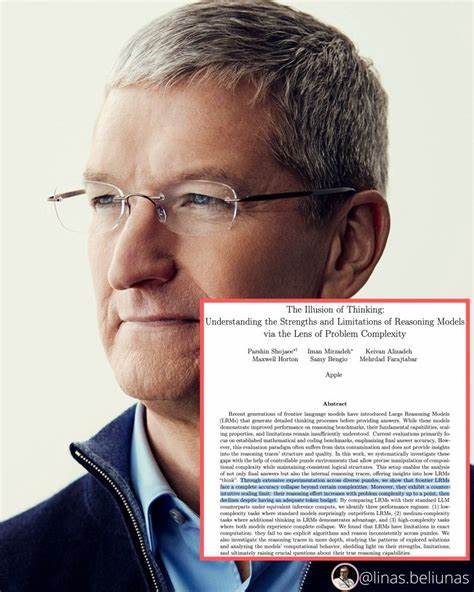

随着人工智能技术的迅猛发展,许多科技企业和研究机构纷纷推出所谓具备“推理”能力的AI模型。这些模型被广泛应用于自然语言处理、自动问答、图像识别等多个领域,似乎能够像人类一样进行复杂思维和逻辑判断。然而,深入分析当前主流的AI推理模型,我们会发现一个惊人的事实:它们实际上并不具备真正的推理能力。所谓的“推理”更多是基于大量数据训练出来的统计相关性,而非理解和逻辑演绎。首先,需要明确的是传统意义上的推理涉及抽象理解、因果关系识别和逻辑演绎,这些过程需要对世界知识有深刻的认知和理解能力。人类在面对复杂问题时,能够综合已有经验和背景知识,通过思考得出新的结论和解决方案。

而目前AI模型尤其是基于深度学习的模型,主要通过处理大规模的数据集,学习语言或视觉中的模式和规律,但并不会真正“理解”这些输入内容。举例来说,当前流行的自然语言处理模型如GPT系列,虽然表现出令人惊艳的文本生成和回答能力,但其操作原理是基于统计预测——根据上下文出现的概率,预测下一个最合适的词语。这种机制在表象上有时看似推理,实则仅是依赖训练数据的概率分布。它并没有真实理解句意,更不会像人类那样进行逻辑推断或验证假设。其次,这种模型缺乏因果推理的能力。因果推理是人类推理的核心,通过识别事件之间的因果关系来预测未来或解释现象。

当前AI模型多半只识别相关性,即不同信息之间在数据中同时出现的情况,却无法真正分辨出哪些信息是因哪些事件引起的。这使得它们在面对需要深入逻辑分析和概念创新的任务时表现不佳。例如,在复杂的法律判例分析、科学研究假设验证等场景,AI模型往往难以提供真正有价值的推理结论,而只能生成看似合理但本质空洞的答案。再者,AI模型的推理过程缺乏可解释性。即使模型给出了某个决策或结论,人类也常常无法追踪背后的具体推理路径。这与传统的符号推理系统不同,后者能够提供明确的规则和演绎链条。

深度学习模型的“黑盒”特性使得推理过程高度隐晦,难以被理解和验证。这不仅影响了用户对AI结果的信任,也限制了该技术在关键领域的应用推广,比如医疗诊断或金融风险评估等需要高度可靠推理的场景。此外,大多数所谓的AI推理仅限于狭义领域和特定任务。当换到新的领域或未见过的情景,模型往往不能灵活迁移其“推理”能力,出现明显的能力欠缺。这与人类推理能力的广泛适应性形成鲜明对比,说明目前的AI“推理”仍是局限于模式匹配而非真正的思考。面对这些限制,研究界也在积极探索更真实的人工智能推理途径。

知识图谱、符号AI、神经符号混合模型等新兴技术试图结合人类逻辑与数据驱动的优势,推动AI具备更类似于人类的推理能力。同时,加强因果推理框架和可解释性技术的研究,也有望提升AI系统在推理场景中的实用性和可信度。总之,虽然现阶段的AI推理模型不能等同于人类的理性思考,但它们在某些特定任务中依然展现出极强的语言生成和信息处理能力。正确理解其技术本质,有助于我们合理利用AI,避免对其推理能力产生过高期待或误解。未来人工智能真正达到推理水平,还需要跨越模型架构、认知科学和知识表示等多维度的深刻突破。通过持续创新和融合多学科研究,我们有望迎来具备真正智能推理能力的新时代AI技术,推动人类社会的发展与进步。

。