随着人工智能技术的不断进步,大型语言模型(LLM)在自然语言处理领域展现出强大的潜力,尤其是在推理能力上的显著提升。传统的推理训练依赖大量人类标注的链式思维示范,既耗时又易受认知偏差限制,难以满足更复杂任务的需求。在此背景下,DeepSeek团队提出的DeepSeek-R1模型,开创性地通过纯强化学习(RL)框架,激励和促进LLM自主探索并形成多样化的高级推理策略,成为行业内推理能力提升的里程碑。DeepSeek-R1不仅打破了对人工推理路径示范的依赖,更展示了推理能力在无需指导的自我演进中的无限潜力。DeepSeek-R1利用Group Relative Policy Optimization(GRPO)算法,以答案正确性为唯一奖励信号,排除对具体推理过程的限制,鼓励模型在生成回答的同时不断进行自我验证、反思以及动态调整策略。这种设计使模型在面对数学难题、编码竞赛及复杂科学领域问题时,表现得更加精准和高效。

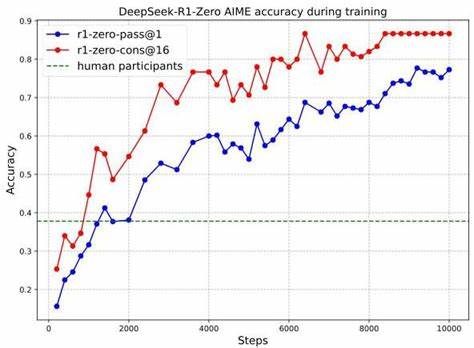

训练过程中,该模型以极具扩展性的RL流水线进行大规模优化,输出的链式思考(CoT)逐渐增长,展现出对问题本质深入探讨的能力。在美国数学邀请赛(AIME)2024的数据上,DeepSeek-R1-Zero版本的通过率从训练初期的15.6%飙升至77.9%,进一步结合自洽解码技术,最高准确率达86.7%,远超人类平均水平,这充分验证了其强化学习驱动的推理激励机制的有效性。此外,模型在编码竞赛和高阶生物、物理、化学题目上的强大表现,也反映出其通用推理能力的成熟。DeepSeek-R1的发展经历了从DeepSeek-R1-Zero的纯RL训练阶段,到引入冷启动数据与语言一致性奖励、再到集成拒绝采样和监督微调(SFT)的多阶段训练流程。该流程不仅改善了模型输出的语言连贯性,避免了中英混杂的问题,也提升了模型在非推理任务中的表现,如写作和开放领域问答。第二阶段的强化学习则通过辅助奖励模块进一步引导模型向更符合人类偏好的方向优化,提升其有用性与安全性,兼顾推理能力和人机交互质量。

特别值得一提的是,DeepSeek-R1的推理策略表现出显著的自我进化特性,其中包括反复检查、替代方案探索等复杂行为。训练过程中,模型显示出所谓的"顿悟时刻",其标志是反思词汇如"wait"频率的骤增,体现了模型对时间推理和自我监控的能力提升。这一现象凸显了强化学习机制赋能下,机器推理能力的非线性跃升。尽管DeepSeek-R1取得了诸多突破,仍面临诸多挑战。结构化输出能力尚不充分,未能充分利用检索工具、计算器等辅助系统,这限制了其在更多应用场景的发挥。模型在令牌利用效率方面也存在一定的浪费,尤其在较简单问题上偶有过度"思考"现象。

同时,因基础模型多为中英文混合训练,对其他语言的支持还不够完善,存在语言切换混淆问题。强化学习依赖的奖励信号构建仍是瓶颈,特别是对于写作等难以制定明确规则的任务,奖励模型易被策略模型"破解",导致训练失稳。对此,未来研究需聚焦于开发更加稳健的奖励机制和多模态验证体系。安全方面,随着模型推理能力的提升,潜藏的风险也同步放大,例如模型更可能产生高可行性的恶意计划描述,要求在发布和应用时配备完善的风险控制系统。DeepSeek团队已开展多语言、多维度的安全评估,并结合风险管控提升整体安全等级。DeepSeek-R1的成功实践对整个AI领域的启示深远。

它证明了在合理的RL环境和精心设计的奖励机制下,模型可以无需人类引导便学会复杂推理策略,自主提升解决方案的智能与多样性。这不仅降低了人工标注的门槛和偏见风险,也为未来自主适应性AI系统奠定理论和技术基础。随着激励推理能力的优化,结合工具调用、结构化输出的进一步融合,有望开拓医疗诊断、科学研究、编程辅助等更广泛的应用边界。同时,由于DeepSeek-R1的推理能力能够迁移并促进更小规模模型的发展,其开放体验版和微调模型在学术和工业界均具有重要价值。整体而言,DeepSeek-R1通过强化学习激励机制,推动了大型语言模型推理能力从人类复制向机器自主创新的飞跃,标志着AI向更高阶认知水平迈进的关键一步。面对未来,结合跨模态交互、强化安全管理和高效训练体系的进展,DeepSeek-R1及其后续版本或将成为推动AI解决复杂推理问题的标杆力量。

。