引言 近年来人工智能从工具逐渐向社交伴侣延伸,Eintercon作为在Show HN上引发关注的项目,宣称在200多个国家展开了"AI友谊"实验。无论是作为学术探索、产品验证,还是社会化技术测试,这类跨国规模的实验都提供了一个观察人工智能如何在不同文化、语言与社会结构中建立信任与情感联结的珍贵窗口。本文将从项目定位、技术实现、文化与伦理挑战、数据与隐私、用户体验设计、潜在影响与未来展望等多维度展开分析,帮助读者理解为何跨国AI友谊实验值得关注,以及参与或借鉴时应注意的关键问题。 Eintercon的目标与意义 Eintercon的核心议题不是简单地打造一个聊天机器人,而是在全球多样的社会环境中研究人机关系的形成机制。若该项目确有在200国或200+地区进行测试,则其价值体现在两个层面。其一是规模与多样性带来的代表性,可以揭示不同文化背景下用户对AI表达、语气和隐私边界的差异。

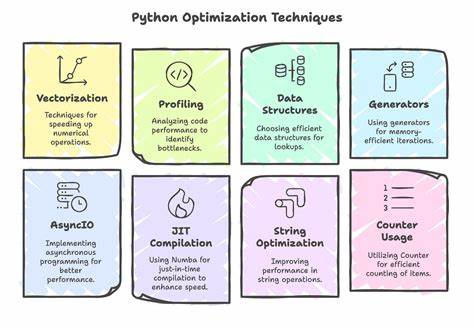

其二是跨文化可持续性测试,评估AI在不同语言、方言与社会规范下的长期互动能力。这些发现能为国际化产品设计、跨文化心理研究与公共政策制定提供参考。 技术路径与实现挑战 要在200多个国家运行AI友谊实验,技术与工程的复杂度远超常规应用。首先是多语言支持问题,仅有英中西等主流语言远远不够。项目需要结合大规模多语种模型、本地化语料以及小语种的少样本微调策略。其次是情绪理解与表达的本地化,不同文化的情绪表达方式、幽默感和礼仪规范差异显著,模型需要通过本地语料与专家监督学习适配。

此外,延迟、连接质量与离线交互能力也是工程实现的关键,尤其在人口稀疏或互联网不稳定地区。最后,部署策略需兼顾云端计算与边缘推理,以达到隐私与实时性的平衡。 文化适配与语境理解 跨国友谊实验必须超越字面翻译,进入文化语境的深层理解。某些表达在一种语言中是亲切的问候,在另一种文化可能被视为越界或不敬。AI需要学会识别并遵循当地的社交规则,例如问候礼仪、对敏感话题的回避、适当的称谓与自我暴露程度。为此,项目应与本地文化专家合作,并采用参与式设计方法邀请当地用户共同打磨对话策略。

通过长期收集用户反馈,持续调整模型的语气、话题偏好及应对策略,才能建立真正被接受的"友谊感"。 伦理考量与风险管理 AI友谊实验带来的伦理问题尤其复杂。首先是知情同意与透明度,参与者应明确理解与AI互动的性质、数据将如何被使用以及可能的风险。其次是情感依赖与心理影响,AI可能在无意中诱导用户产生强烈的情感联结,尤其对孤独或心理脆弱人群带来潜在风险。应当建立风险缓释机制,例如识别并标注高风险情绪信号、在必要时引导用户寻求专业帮助、设置人工干预点。再者是偏见与歧视的传播,模型训练数据若未充分覆盖地域文化差异,可能重复或放大刻板印象。

因此,持续的偏见检测、审计与纠正机制必不可少。 隐私保护与数据治理 跨国实验意味着数据流动跨越多重司法管辖,必须遵守各地的数据保护法规。项目应采用隐私优先设计,最小化数据收集范围,优先在设备端进行处理,以及采用差分隐私和联邦学习等技术减轻集中式数据风险。对于必须收集的对话数据,需明确用户同意、提供方便的删除与导出选项,并对敏感信息进行自动识别和脱敏。数据治理还应建立独立审计与伦理委员会,公开审查数据使用、模型更新与实验结果,以增强公众信任。 用户体验设计的关键点 在建立"AI友谊"体验时,设计需兼顾真实感与边界感。

AI应明确自身身份,避免误导用户认为其是具有真实人类意识的主体。对话设计应强调倾听与共情能力,同时在触及敏感话题时保持谨慎。长期关系管理方面,AI需要记住用户偏好与互动历史,但也应让用户掌控记忆范围与保留期限。个性化推荐与话题引导要基于透明规则,避免强制性推动消费或传播有争议内容。为了增加接受度,本地化的语音、非语言表达和文化梗的适当使用可以显著提升亲切感。 跨国实验的社会与研究价值 扩展到200多个国家的实验可以带来丰富的社会科学数据,有助于理解全球化背景下人们对AI协作、伴随与信任的差异性。

研究者可以从中观察文化对情感回应的调节作用、语言结构对共情表达的影响、以及社会制度对隐私与技术接受度的塑造。此外,这类实验对弱语种的技术普惠也有积极意义,推动更多语言资源的数字化与模型支持。然而研究价值必须在伦理边界内实现,避免将用户当作纯粹的实验对象。 案例与初步发现(在可用数据范围内的解读) 如果Eintercon公开了部分实验结果,我们可以期待看到关于不同地区对AI语气喜好的普遍规律,例如某些文化更偏好正式与礼貌的表达,而另一些文化更喜欢轻松幽默的对话风格。对孤独人群的短期情感安慰可能是普遍现象,但长期的心理效应需要谨慎评估。对小语种社区而言,AI可能成为提升心理健康服务与社交连接的有益补充,但前提是本地化程度足够且有人工监督支持。

对开发者与组织的建议 对打算开展类似跨国AI友谊项目的团队,首先要制定清晰的伦理框架和治理结构,包含外部伦理审查与用户参与机制。技术上建议采用模块化架构,核心对话能力与本地化适配模块分离,以便快速调整各地域的表现。要重视多语种语料的可持续构建,建立与本地社区的合作通道,以获取高质量、低偏见的数据。数据保护方面,优先采用边缘计算和联邦学习,降低跨境数据流动带来的合规风险。最后,保持透明与开放沟通,定期发布实验方法与安全审计报告,建立公众信任。 政策与监管的思考 跨国AI友谊服务触及多个监管领域,包括数据保护、消费者权益、心理健康服务规范以及广告与商业行为监管。

政策制定者应关注AI在人机关系中的特殊风险,例如情感依赖、误导性人格模拟和未成年人保护。监管可以从强制透明度、明确用户同意规范、设置高风险情境的额外保护和要求开展独立影响评估入手。国际协作也很重要,跨国实验的数据流动与责任分配需要多国监管机构的对话与指导原则。 未来展望 AI友谊并非遥不可及的科幻,而是正在被现实技术推动的社会现象。未来的关键在于如何把技术潜力转化为有益而安全的社会功能。理想的路径是将AI作为增强社会连接与心理健康的工具,而非替代人类关系。

同时,更多透明、参与式和多元化的实验设计将有助于减少偏见与不平等,确保技术惠及更多语言与文化社区。随着模型在情感理解、长期记忆管理和文化敏感性方面不断进步,跨国友谊实验也将为全球社会提出新的伦理与治理命题。 结语 Eintercon在Show HN上引发的讨论提醒我们,跨国规模的AI友谊实验既充满可能,也伴随重大挑战。只有在尊重文化差异、严格保护隐私、建立透明治理与伦理约束的前提下,这类探索才能带来积极影响。对开发者、研究者与政策制定者而言,关键在于以用户为中心、以伦理为底线、以开放合作为路径,让AI成为连接而非割裂全球社会的桥梁。 。