在人工智能和自然语言处理技术飞速发展的当下,检索增强生成模型(RAG)的应用日益广泛,尤其在问答系统、智能助手和信息检索领域扮演着至关重要的角色。ZeroEntropy作为YC W25批的一支数学家和竞赛编程高手团队,正致力于提升搜索的准确性,开创了利用国际象棋Elo评分体系训练文档重排序reranker模型的新途径,取得了显著成效。本文将围绕其创新理念和实践过程,全面探讨如何通过Elo评分解决传统训练难题,实现高效、精准的信息检索。首先,需要搞清楚什么是reranker(重排序器)。在多阶段搜索系统中,第一阶段通常采用关键词匹配(例如BM25)或语义搜索(基于文本向量相似度)技术快速检索大量文档候选集。这些方法虽然能大范围覆盖潜在相关内容,但排序往往不够精准,尤其当候选文档数以百万计时,真正相关的内容若排名靠后,用户和下游模型很可能无法看到,检索效果大打折扣。

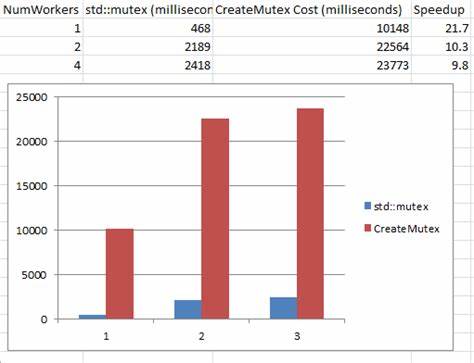

Reranker则作为第二阶段的精细排序机制,输入查询和文档对,结合两者的完整文本做交叉编码,凭借深度语义理解精准地打分、重新排序极大提升最终检索结果的相关度和用户体验。ZeroEntropy所开发的reranker模型zerank-1以及精简版本zerank-1-small,均采用了创新的训练策略,以国际象棋中的Elo评级理念作为核心突破口。传统reranker训练存在的最大挑战之一是高质量、人为标注的训练数据稀缺且成本高昂。通常训练集中,人工标注者将查询-文档对标记为二元标签“相关”或“不相关”,用于监督模型学习。负样本则多为随机采样或基于简单搜索策略挑选,但此举导致负样本中夹杂大量“假负样本”——实际上与查询相关但未被标注为正样本的文档,这种噪音严重削弱模型判别能力和排名质量。与此同时,给查询-文档对赋予连续的相关度分数也同样困难。

人类或者大语言模型(LLM)在评估相关性时往往存在较大主观偏差和评分不一致性,尝试直接预测绝对分数使得数据噪声过大,影响模型训练稳定性和最终效果。面对这些瓶颈,ZeroEntropy团队提出放弃传统的绝对评分体系,转而采用“成对比较(Pairwise Comparisons)”的思路。具体做法是,对于每个查询,挑选两篇文档,让人类或语言模型判断哪篇文档更相关。成对比较能大幅降低评分时的主观误差和噪声,因为比较仅需判定哪个更相关,而不必给出绝对分数,这种局部判断更容易达成共识。基于大量成对判断结果,团队采用国际象棋中著名的Elo评分技术,将每条文档视为“选手”,成对比较结果视为“比赛”,以最大似然估计的方法计算每个文档的全局Elo分数,反映其相对相关程度。Elo模型用文档评分之间的差值得出胜率概率,逻辑严谨且数学性质优良,避免了传统标注的主观偏差问题。

为了降低计算复杂度,ZeroEntropy创新性地只对100篇候选文档中采样有限的多条成对对战路径(构成图上的闭环),而非穷尽所有可能的成对组合,从而显著减少推理计算量,同时保留了足够的排序信息,使Elo评分接近理想状态。除此之外,团队还引入跨查询对比机制,解决不同查询之间Elo分数比较不一致的问题。通过设计专门的提示策略和采样方案,让模型判定不同查询文档对之间的相关度优劣,从而估算出每个查询的偏置因子,对Elo评分进行调整,消除因查询本身相关文档丰富程度不同而产生的评分偏差。这一步极大提升了训练的稳健性与泛化能力。基于这样构建的“伪绝对”相关度评分函数,ZeroEntropy进一步训练基于点对点反馈的reranker模型,实现快速且高准确度的直接评分。最后,团队通过强化学习微调,进一步优化模型性能和推理效率,推出了性能领先且开源的zerank系列模型,能够在实际应用场景中实现秒级返回高质量排序结果。

值得一提的是,ZeroEntropy设置的训练流程突破了传统数据需求,对人力标注依赖最低,更多依靠强力LLM集成判断,大幅提升数据获取速度和规模。通过巧妙结合检索策略、成对比较、Elo数学建模及偏差校正,打造出一套高效、准确的重排序系统,既兼顾了学术严谨性,又具备工业实用价值。该方法的成功应用为RAG领域提供了全新视角,为未来搜索引擎和智能助手的排序模型设计树立了典范。此外,ZeroEntropy团队将reranker模型在HuggingFace平台开源,并通过API形式对外提供访问,方便开发者和企业集成使用。相关技术细节与论文报告公开,推动学界和产业界共创创新。总的来说,ZeroEntropy通过借鉴国际象棋Elo评分体系为检索增强生成模型的重排序设计注入数学智慧,有效避免了传统人工标注弊端,提升了搜索质量和模型训练效率。

该举措不仅展现了跨领域创新的力量,也为未来更多结合对局评价思想的AI系统开辟了道路。随着模型不断改进,相信会在智能检索、知识管理乃至各类语义理解任务中发挥更大价值。