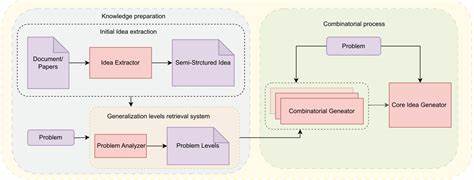

在人工智能领域,关于"创造力"的讨论从未像今天这样热烈。随着大型语言模型(LLM)在文本生成、代码补全与科学想法生成等任务上表现出强大能力,学术界与工业界开始追问:LLM真的能像人类一样具有创造力吗?最近一篇题为《组合创造力:通向新边界》(Combinatorial Creativity: A New Frontier)的论文为这一问题提供了新的思路和实证线索。本文解读该论文的核心观点与发现,总结其对模型设计、评估方法与未来研究的启发,并讨论在实际应用中如何更有效、更安全地利用模型的创造性能力。论文提出的核心概念是"组合创造力"(Combinatorial Creativity)。相对于传统的组合泛化(compositional generalization),组合创造力强调一个开放式、非确定性的生成目标:模型并非在固定目标上进行准确化检验,而是在无限的创造空间中生成既新颖又有用的想法。为此,作者提出了一个评估框架,将创造力的衡量拆解为新颖性与实用性两个维度,主张避免用固定正确答案来评估开放式创造性任务,而应在连续的质量谱上判断输出的价值。

这一思路契合科学研究与发明活动的本质:好的创意必须既不同于已有工作,又能够在现实中带来潜在价值或可行路径。在方法论上,论文将创造力视为一种算法性能力,提出了相应的评估任务设计,鼓励通过定量化的新颖性分数与实用性估计来比较模型输出。作者强调,新颖性并非越高越好:极端新颖可能伴随极低的实用性,进而形成所谓的创意-实用性折衷(novelty-utility tradeoff)。这一点对理解"创意与可实施性之间的鸿沟"提供了富有洞见的解释:大型语言模型常常能提出令人耳目一新的科研点子,但这些点子未必在实验或工程上可行,这种现象在论文中以"ideation-execution gap"描述,并被归因于更普适的设计权衡。论文还给出了重要的实证发现,尽管实验规模相对中小,但结果指向若干关键趋势。首先,作者获得了首批关于创造力对模型规模与架构的标度行为(scaling behavior)的初步见解。

研究显示,在固定计算预算下,模型的深度与宽度并非越大越好,而存在对创造能力有利的深度-宽度组合。也就是说,在给定相同计算资源时,过深或过宽的模型可能并不在创造力任务上表现最佳,而某些中间配置反而能更好地平衡生成的多样性与实用性。这一发现对模型设计、资源分配与工程优化有直接影响:开发者若想提升模型的"想象力",就需要在架构选择上做出更精细的计算与实验。其次,尽管实验所涉及模型规模仅覆盖到约一亿参数的量级,论文强调这些发现具有启发性,但并不意味着在前沿数十亿到数千亿参数的模型上结论会完全一致。作者明确指出,当前主流的最前沿模型还远超实验规模,因此本文的框架与实验更多地被视为一个起点,为进一步研究更大规模模型的创造力提供方法论与理论指引。论文的另一个贡献是提出了评价创造力输出的新范式:不再追求单一的正确答案,而是通过多元衡量来打分与筛选,强调评估过程应兼顾自动化度量与人工审阅。

新颖性度量可以基于与训练语料或已知知识库的距离估算,实用性评估则可以结合基于模型的可行性判断器、外部工具验证或小规模实验。这样的评估链路有助于缓解单纯依赖主观评分带来的不稳定性,同时为工程化应用推动模型从"点子生成"到"可执行方案"转化提供路径。围绕论文结论,若干实际启示值得关注。对于科研人员与工程师而言,可将模型视为"创意扩展器"而非"直接执行者"。在新想法的初步生成阶段,使用高温度采样、多样性优化或组合式提示可以放大模型的探索能力;随后需要引入验证层,如基于规则或模拟的可行性检测、基准化实验或人类专家评审,来筛选出具备实现潜力的方案。将模型与检索增强、工具使用(如代码执行器、科学计算环境)结合,能显著提高输出的实用性,从而在创意与执行之间搭建桥梁。

从研究方向来看,论文暗示几条重要路径。首先是扩展评估到更大规模的模型,检验深度-宽度权衡与规模效应是否在更高参数量级上保持。其次是深化对创意-实用性折衷的理论理解,探索是否存在能够同时提升二者的训练策略或架构创新。再次是发展更可靠的新颖性与实用性自动度量方法,特别是为跨领域科学创意设计鲁棒的衡量标准,以支持大规模自动评估。最后,需要探索人机协同的最佳实践,让模型在创意生成中扮演启发者或拟合器的角色,而人类负责可行性判断与价值整合。伦理与安全考量在将创造性能力投入现实世界时尤为关键。

模型生成的新颖想法若不经严格验证便付诸实践,可能带来误导性结论、资源浪费,或在更坏的情况下引发危险的误用。论文虽然主要集中在能力与评估上,但其提出的开放式评价框架天然要求引入风险评估机制,确保在科研、工程与商业应用中对模型输出进行严谨的审查。模型开发者应构建包含可追溯性、风险标签与人类核查环节的流程,防止未经证实的创意在高风险场域扩散。在应用场景方面,组合创造力框架对多个领域有实用价值。科研机构可用其来加速交叉学科的想法生成,医疗与生物技术研究者可以获得不拘一格的假说触发点,产品与设计团队能把模型作为灵感库来拓宽方案空间。重要的是,所有这些应用应建立"想法 - 验证 - 迭代"的闭环:模型提出创意,研究者或工程系统进行可行性验证,然后基于反馈对提示策略或模型本身进行迭代优化。

论文也提醒我们关注模型训练与数据的作用。创造力并非凭空出现,而依赖于模型在训练数据上学到的组合能力与隐含模式。为提高创造性输出的质量,可能需要引入更丰富、多样且跨学科的训练语料,或采用有指导的训练目标,让模型在学习过程中更重视组合创新能力。此外,强化学习与对比学习等技术或能在特定创造性任务上促进模型探索有价值的解空间,同时保持输出的可控性。总结来说,《组合创造力:通向新边界》为理解与评估大型语言模型的创造力提供了一个清晰且务实的起点。论文在理论框架、评估范式与初步实证上给出了重要贡献,尤其指出了新颖性与实用性之间不可忽视的权衡,并揭示了在固定计算预算下深度与宽度的非平凡影响。

尽管当前实验规模尚不足以直接推断前沿大模型的行为,但作者明确将研究定位为通往更大规模探索的基石。未来的研究应继续拓展规模、改进自动化评估方法,并强化人机协同与安全治理机制。对于希望将模型用于科学创意或工程创新的机构,采取谨慎而系统的验证流程、结合外部工具与专家评审,将是将创意转化为可执行成果的关键。随着模型架构、训练范式与评估工具不断演进,理解与提升LLM的组合创造力将成为推动人工智能在科学发现与创新实践中发挥更大作用的重要方向。论文给出的理论与实证洞见不仅激发了学术讨论,也为工程化落地提供了切实可行的路线图,帮助我们更理性地回答那个古老而又新颖的问题:大型语言模型,能否真正成为创造力的伙伴? 。