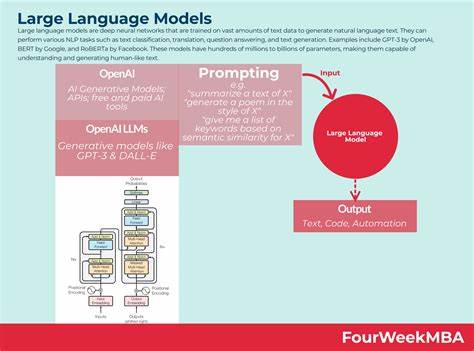

近年来,大型语言模型(Large Language Models,简称LLM)在自然语言处理领域引起了广泛关注。它们不仅展示了强大语言理解和生成能力,还为智能助理、机器翻译、内容创作等多个领域注入了新的活力。然而,面对现实复杂多变的环境,许多人开始关注大型语言模型的韧性,也就是它们在遭遇各种挑战时所表现出的稳定性和适应能力。本文将围绕这个核心话题展开,深入探讨大型语言模型的韧性究竟有多强,以及当前其面临的主要挑战和未来发展的方向。大型语言模型的兴起引发了人工智能行业的革命。通过海量数据训练,这些模型能够理解上下文、推理问题、生成连贯且富有逻辑的文本。

然而,模型的韧性并非天生具备,而是在训练、架构设计和实际应用过程中不断锻造的。韧性体现为模型对输入扰动、环境变化、任务复杂度提升等因素的容忍度。一个韧性强的语言模型,应能够在数据偏差、恶意输入甚至系统故障情况下继续正常运行,输出准确可靠的结果。首先,从技术角度来看,大型语言模型在处理多样化语言输入时表现出一定的韧性。它们面对语法错误、用词不当、不同口音甚至跨领域的内容依然能够保持较高的理解和生成能力。这得益于模型庞大的参数规模和丰富的训练数据覆盖,形成了广泛的语言认知基础。

然而,这种韧性并非无限。攻击者可以通过对抗样本(adversarial examples)扰乱模型的理解,导致错误甚至有害的输出。如何提升模型抵御此类攻击的能力,成为当前研究的热点。韧性不仅关乎模型本身,更与训练数据的质量和多样性密切相关。数据偏差可能导致模型出现刻板印象或不公平的内容,影响其在真实世界应用中的可信度。此外,模型在训练过程中对罕见语言现象和新兴词汇的适应能力有限,面对不断变化的语言环境可能出现理解障碍。

再者,大型语言模型的韧性还体现在它们对任务迁移的适应性。很多应用场景要求模型在未见过的任务或领域中仍能做出合理推断。当前的微调技术帮助模型在特定任务上取得不错表现,但其在应对完全新颖的挑战时依然存在局限。持续学习和在线学习机制被视为未来增强模型韧性的关键方向。此外,硬件与系统层面的稳定性同样重要。大型语言模型依赖庞大的计算资源,任何硬件故障或系统异常都可能影响模型的运行和结果的正确性。

因此,保障硬件环境的可靠性和对异常情况的快速恢复能力,亦是提升整体韧性的重要环节。在实际应用中,用户体验和安全性是评估大型语言模型韧性不可忽视的两个方面。模型需要在保证回答准确性的同时,避免输出可能引发用户困惑或负面影响的内容。为此,开发人员通常引入多级审核机制和安全策略,检测并过滤潜在有害的输出。此外,随着法律法规对数据隐私与内容安全的关注日益加深,大型语言模型必须具备合规性韧性,保障用户数据安全并遵守相关规定。未来,大型语言模型的韧性提升将依赖多重技术创新的推进。

首先,模型架构的优化和更智能的训练算法将有助于模型更好地理解复杂语言结构和减少错误出现。其次,多模态融合技术的引入,可以使模型结合视觉、声音等多种信息来源,提高对环境的感知能力和判断准确率,从而增强韧性。此外,强化学习与元学习方法的应用,将促使模型具备更强的自适应能力和自我修正能力,有效应对不确定和变化的应用场景。总的来说,大型语言模型的韧性是一项涉及模型设计、训练方法、数据质量、硬件基础以及应用安全等多方面的综合性指标。当前尽管已经取得显著进展,但面对多变复杂的现实世界环境,仍存在不少挑战。科研人员和工程师需要持续努力,通过技术革新和系统完善,不断提升大型语言模型应对风险和适应变化的能力。

只有这样,大型语言模型才能真正成为人工智能领域坚实可靠的基石,为社会带来更加安全、高效且智能的服务体验。 。