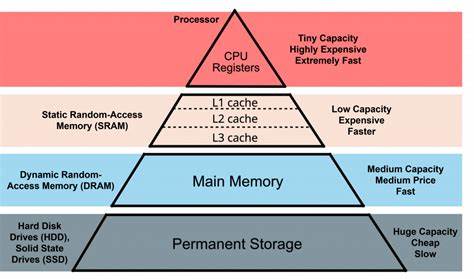

计算机性能的提升经历了多种技术革新,但随着硬件的发展,人们对内存与磁盘之间速度差异的传统认知逐渐发生变化。普遍的经验法则告诉我们,内存访问速度远远快于磁盘读取速度,因此系统设计中经常采用内存缓存来加速数据访问。然而,随着SSD性能的飞速提升和内存访问延迟的停滞,磁盘读取在某些场景下竟然能超过内存缓存的速度。这一令人惊讶的现象值得深入探究和分析。通过从实践出发,测试环境搭建到代码优化实施,一步步解开内存慢、磁盘快的性能谜团。首先,必须明确CPU到内存的数据传输瓶颈。

以搭载AMD EPYC 7551P 32核处理器的服务器为例,内存通道数量为3,DDR4内存频率为2133MHz,经过计算单线程的理论峰值带宽大约为13GB/s,远高于单个PCIe 3.0 SSD的最高3.1GB/s读取速度。传统观点认为,这意味着直接从内存读取数据必然快于从SSD读取数据。但实际测试展示了不同的真相。采用mmap()映射文件至进程地址空间,读取50GB数据集并统计特定整数值的简单循环操作,首次执行时速率约为0.61GB/s,符合磁盘物理读速的实际表现。再次执行由于文件被操作系统缓存,速率提升至3.71GB/s,但仍低于单线程内存带宽上限。这表明数据虽然在内存中,访问效率却受限于其他因素。

通过使用perf分析程序指令,可以发现初始实现未启用矢量化指令,循环每次处理单个整数,导致处理速度与CPU指令执行能力挂钩,未能充分利用现代SIMD指令集的并行处理优势。为探索提升空间,采用循环展开技术,显式解除分支,实现分支消除,促使编译器生成128位矢量指令。经过优化,处理速度提升至5.51GB/s,接近CPU指令吞吐能力的极限,但仍未接近内存带宽峰值。这说明CPU的指令吞吐率成为关键的性能瓶颈。再将注意力转向I/O管道,传统的mmap()使得读取过程在每次访问4KB页面边界时触发缺页异常,操作系统需要处理页面缓存和页表更新,产生内存访问延迟,导致整体效率下降。相比之下,直接读写调用(read)结合预分配对齐缓冲区,利用O_DIRECT避免页缓存,确保数据连续流入,减少了操作系统的调度和延迟开销。

然而,普通同步I/O在高并发、大数据量环境中表现仍有限。采用Linux新兴的io_uring接口,实现异步I/O和多线程协作,构建高效的请求队列和缓冲管理,为存储设备提供最大限度的带宽利用。此方案通过6个并发工作线程,队列深度设置至8192,缓冲区单元为16KB,从而极大地提升了磁盘读取的数据传输速率。实验结果令人震惊,直接从磁盘读取并统计50GB数据达到5.81GB/s,首次在实际中实现了"磁盘速度超过内存缓存"的境界。这并不意味着磁盘本身比内存快,而是高级的I/O流水线和异步处理架构有效隐藏了磁盘访问延迟,利用了硬件带宽优势,而传统的内存访问路径受限于处理延迟和缓存刷新机制。进一步测试发现,改变内存映射操作,使用read()函数结合内存对齐,解除页缓存的限制后,内存访问速率显著提升,结合循环展开和矢量化实现,单线程速度接近13GB/s理论带宽,证明了内存带宽潜力仍然巨大。

但多NUMA域环境和大数据集下,内存访问延迟和跨域数据传输仍旧成为性能瓶颈。综上所述,传统的认为"内存必定快于磁盘"的硬件性能认知已开始失效,具体场景需要结合软硬件实现加以验证。充分利用现代硬件的并行I/O机制、异步处理和矢量化计算,才能最大化发挥计算机系统的性能潜力。未来服务器设计将需要更加注重I/O编程模型和缓存机制的优化,实现磁盘、内存和CPU三级协同,摆脱单一瓶颈制约。同时,内存技术的发展也在向"流水线流式处理"转变,即借鉴磁盘的流式访问思路,优化内存带宽利用率和缓存机制,从根本上减少访问延迟。虽然引入如此复杂的异步I/O和多线程程序设计增加了代码复杂度,但得益于人工智能辅助编程的进步,复杂优化不再难以实现。

作为系统设计者与开发者,理解硬件底层性能瓶颈和最新技术趋势,将帮助更合理地进行资源配置,避免单纯依赖内存缓存的盲目设计,选择更适合、高效的方案。探讨性能极限和跨越传统边界,将是面向未来的关键议题。内存慢并非内存本身的问题,而是访问模式和系统机制的限制;磁盘快是在于充分利用带宽和异步流水线的智慧。掌握这一真谛,不仅是对现有硬件的充分利用,更是推动底层计算架构变革的起点。 。