随着大型语言模型(LLM)在各行各业广泛应用,内容生成的真实性成为亟需关注的重要课题。虽然这些模型能够生成流畅且富有逻辑的文本,但它们时常会出现"幻觉" - - 也就是生成与事实不符的信息,严重影响用户体验和信任度。针对这一挑战,RefChecker应运而生,成为细粒度幻觉检测领域的开创性工具,为评估和审查大型语言模型的输出提供了强有力的技术支持。 RefChecker的核心理念在于将复杂的自然语言输出拆解成更基本的知识单元,即知识三元组(subject-predicate-object),以此作为判断信息真伪的基础单位。相比于传统的全文、句子或子句级别检测方法,基于知识三元组的细粒度检测不仅信息粒度更小,效果更精准,而且易于对不同层级的真实性进行自由切换和汇总,更加灵活地满足多样化的实际需求。 在现实应用中,语言模型的回答常常伴随着不同程度的上下文依赖。

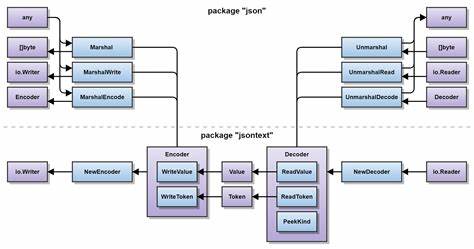

RefChecker创新地将检测场景划分为三大类:零上下文、噪声上下文以及准确上下文。零上下文主要指模型在无任何外部知识辅助下,自身训练知识库中生成回答,此时检测难度最高。噪声上下文场景则适用于检索增强生成(RAG)模式下,外部文档作为参考但存在不完整或误导信息的情况。准确上下文多见于摘要、问题回答等明确且高质量的单一参考信息输入。通过分别适配这三种情况,RefChecker能够为多样化应用提供兼容性极佳的检测支持。 在技术架构上,RefChecker采取模块化设计,涵盖声明提取、幻觉检查和结果汇总三个核心阶段。

声明提取借助预训练的大型语言模型自动识别文本中的知识三元组,确保检测单元的完整性与准确性。幻觉检查则汇集了包括基于大语言模型的零样本推理方法和自然语言推理(NLI)技术,利用多种预训练模型对每个知识三元组进行支持、反驳或中立的判断。最后通过严格或柔性的聚合规则,整合各声明的判定结果,输出整体内容的真实性评价。 值得一提的是,RefChecker不仅支持自动化运行,还包含即将推出的人工标注工具,便于人工对复杂或者不确定的声明进行复核与修正,彰显人机协同的设计理念。此外,根据任务和情境需求,RefChecker内置了调用搜索引擎以弥补零上下文时无参考资料的缺憾,从而最大程度保障检查的完整性和准确度。 RefChecker的问世依托于严谨的基准数据集,该数据集涵盖三种不同上下文环境中的300个示例,分别取自自然问题(NaturalQuestions)、MS MARCO检索集以及databricks-dolly-15k数据集。

借助七款主流大型语言模型(GPT-4,GPT-3.5-Turbo,InstructGPT,Falcon-40B-Instruct,Alpaca-7B,LLaMA2 70B以及Claude 2)的多轮回答,基准测试具备科学性和权威性。通过人工双标注及95%的标注一致性率,保证了评价结果的可信度和稳定性,为后续的模型评估和优化提供客观依据。 在语言理解领域,幻觉定义的准确性至关重要。RefChecker区分三类幻觉标签:确证(Entailment)、中立(Neutral)和矛盾(Contradiction),对应事实支持、不足信息及事实反驳,通过这种细致的分类,使检测结果更具判别力和实用价值。同时,对于无法提取到有效知识三元组的放弃回答,系统引入"放弃"标签,确保检测流程不被干扰且评价更完善。 为增强检测说明的透明度和可追溯性,RefChecker实现了证据定位功能。

它通过语义嵌入技术,将知识三元组映射至参考文本中的具体片段,为用户呈现事实支持或矛盾的具体依据。尽管此功能在处理复杂推理或信息分散的情境下仍具挑战,但为幻觉缓解策略的实施奠定了基础。 RefChecker的技术优势不仅在学术论文中得到充分论证,也在Github开源平台上获得400余星标和多次版本迭代更新,体现了强大的社区支持和迭代活力。用户可通过命令行快速部署,支持多种主流云平台和本地模型加速运行,适配灵活,易于整合进现有AI评测框架。 从未来发展角度来看,RefChecker面向多维度的持续优化方向。团队致力于打造更轻量级且高性能的开源声明提取器与检查器,探索将检索训练语料替代公开网络搜索引擎的创新策略,以及加深对幻觉与助益性之间权衡的理解。

此外,提升多步推理能力与多模态协作检测,也被视为技术升级的重点。 总而言之,RefChecker充分利用知识图谱视角的知识三元组分解方法,结合领先的NLI和大语言模型检测技术,构建了一条智能化、精细化的幻觉检测闭环。它不仅在推动大型语言模型输出内容的改进,增强用户信任方面发挥重要作用,也为学术界和工业界提供了可借鉴的先进范式。在人工智能内容生成日益普及的时代,RefChecker的细粒度幻觉检测能力无疑成为保障信息真实性与质量的关键利器。期待未来该领域有更多创新涌现,共同推动语言智能向更可靠、更深入的方向发展。 。