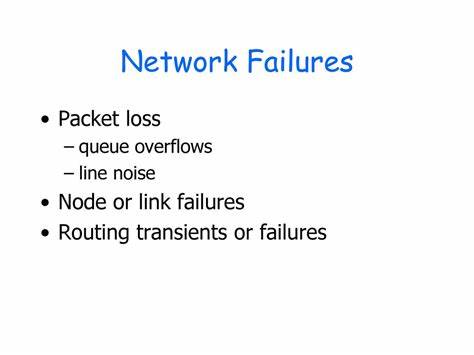

随着Linux内核版本的不断升级优化,用户期待更高的系统性能和稳定性,尤其是在网络传输方面。然而,Linux 6.16.2版本推出后,部分用户和服务器后台管理者反映遇到了网络回归现象,表现为数据包丢失率升高以及网页加载频繁失败的问题。这些状况不仅影响了网络服务的连续性和质量,更对依赖Linux系统的企业级应用带来了实际损失。深入理解Linux 6.16.2网络回归背后的技术细节,成为网络管理员和开发者亟需解决的难题。数据包丢失作为衡量网络传输质量的重要指标,指的是在数据传送过程中部分信息未能成功到达目标节点的现象。在Linux 6.16.2中,部分内核网络栈的更新引入了新的数据处理机制,但在高并发场景或特定硬件组合下,这些改动出现了副作用,导致节点缓存溢出、队列处理延迟等问题,从而加剧了丢包率。

网络传输的稳定性显著受损,也直接导致了网页加载时的请求响应不完整或超时,引发页面加载失败。网络回归的问题对服务器性能和用户体验造成了双重打击。对于企业网站和云服务平台,任何一次数据包丢失都可能导致用户请求重传,系统响应时间拉长,甚至服务不可用。消费者端网页加载失败导致用户流失率上升,降低商业转化率。更复杂的是,Linux 6.16.2所采用的新网络驱动程序和子系统配置,某些情况下与旧硬件或网络设备驱动不兼容,进一步放大了负面影响。针对这些挑战,技术社区和开发者们已经展开了积极响应和深入探讨。

首先从内核层面分析,不同网络协议栈部分发生逻辑调整,例如TCP拥塞控制算法的改进、新增的内核定时器机制,以及数据包调度优先级的动态调整等,都可能影响到数据包的传输顺序和时效性。此外,内核的网卡驱动更新引发的兼容性问题也值得重点关注。一些旧型号的网卡在新版内核下驱动表现不佳,导致数据流中断或片段丢失,最终影响整体网络质量。其次,从系统配置和网络环境来看,内核参数调优同样关键。网络缓冲区大小设置不合理、队列长度配置不当、TCP/IP栈的重传机制阈值未针对新版本优化,都可能诱发丢包和连接中断。此外,网络流量管理工具如流控和QOS策略未及时匹配新内核行为,易造成网络拥塞节点加剧,进一步恶化数据包丢失情况。

针对用户层面的网页加载失败,浏览器缓存机制、CDN节点选择、HTTP协议版本支持及TLS加密算法的兼容性同样不可忽视。在高损耗网络环境中,传统的http/1.1连接和加密协商过程更容易受到丢包影响,而依赖于Linux内核网络层优化的服务端响应能力直接决定了页面最终加载体验。为了有效解决Linux 6.16.2网络回归带来的困扰,网络管理者应从多个角度着手。首先要结合内核release notes和社区反馈,准确定位回归引入的代码变更点,并针对具体问题部署临时修补或回滚方案。对于企业关键服务器,建议使用已验证稳定的内核版本,并关注后续官方发布的bug修复和性能改进补丁。其次,加强网络硬件的兼容性测试与驱动匹配,必要时更换或升级网卡设备,并规范内核配置,如调整网络缓冲区参数、优化TCP滑动窗口大小以及重新配置流量控制策略。

同时,可利用系统监控工具实时跟踪丢包率、带宽使用及时延变化,辅助快速诊断与响应。第三,针对页面加载失败问题,应协作前端开发及CDN供应商,优化内容分发策略和缓存配置,提升页面静态资源的交付效率。合理利用HTTP/2及QUIC协议优势,减轻TCP重传压力,提高抗丢包能力。并通过日志分析和用户行为监测,筛查网络异常与潜在瓶颈,为后续系统改进提供数据支持。此外,社区合作和开源原则是持续优化Linux网络性能的重要助力。参与Linux内核邮件列表、Bug Tracker及相关技术论坛,积极反馈遇到的问题和性能表现,有助于开发者迅速发现回归的根本原因,推动内核网络子系统的迭代升级。

通过多方协同,结合开源贡献和企业内部测试,Linux网络生态将保持健康活跃,确保用户享有更流畅稳定的网络服务体验。总而言之,Linux 6.16.2版本中出现的网络回归问题,以数据包丢失和页面加载失败为主要表现,背后涉及内核网络栈调整、硬件驱动兼容性以及系统配置多重因素。只有全面认识其成因,结合内核与系统层面优化策略,才能有效降低网络故障率,提升服务稳定性和用户满意度。随着技术社区的持续努力和频繁迭代,未来Linux内核的网络性能将不断迈上新台阶,满足日益增长的互联网应用需求。 。