在数据处理领域,经典的XOR技巧以其简洁与有效在查找单个或两个缺失数字中得到广泛应用。然而,随着数据规模的急剧增长,尤其是在数十亿级别的数据库中,如何高效且准确地找出多个缺失元素或集合间的差异,成为一项极具挑战性的任务。本文围绕这项挑战,介绍一种强大的数据结构——可逆布隆过滤器(Invertible Bloom Filter,简称IBF),它不仅继承了XOR技巧的核心优势,还实现了空间复杂度与差异规模紧密相关的高效集和差异恢复方案,满足现代大数据处理的需求。经典的XOR技巧依赖于对所有元素的异或汇总,利用数字的特性在缺失单个或双数字情况下还原结果。然而,一旦缺失数量超过两个,该技巧显得力不从心,因为结果会产生混淆,且难以定位缺失元素。针对大规模数据,简单的XOR处理难以应对元素分布不均及差异量不定的问题。

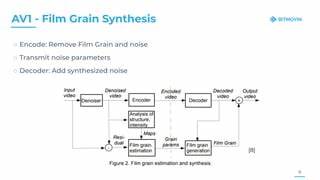

为了解决上述难题,可以以哈希函数为基础,将数据集划分成多个小分区,每个分区单独使用XOR技巧恢复缺失元素。这种分区方法提高了适应性,但无法完全规避某些分区中存在多重差异的复杂情况,且哈希函数的选择和分区数目成为瓶颈。更进一步,若将传统的布隆过滤器结构融合XOR技巧的思路,即构建可逆布隆过滤器,便能显著提升处理能力。可逆布隆过滤器在布隆过滤器基础上设计了三种关键的累积器:idSum负责存储元素值的异或总和;hashSum保存元素哈希值的异或和,作为校验辅助;count计数当前单元格元素数量。借助多个哈希函数将元素映射到多个单元格,如果两个集合中存在相同元素,这些元素的影响在对应单元格中相互抵消,剩下的即为集合的对称差。IBF的核心算法包括三大操作:编码、减法与解码。

首先编码阶段将集合中的元素插入IBF,通过哈希映射更新对应单元格信息。减法操作对应连接两个IBF,抵消两者间相同部分,只保留差异信息。解码阶段则利用被称为“剥离(peeling)”的迭代技术,从纯净单元格(计数为±1且hashSum与idSum校验一致)中恢复差异元素,并依次“剥离”这些元素,反复检测与更新直至无法继续提取为止。通过该方式,可逆布隆过滤器能在理论上以空间开销与差异大小成正比的代价,高概率准确恢复集合间的差异。与传统布隆过滤器只能进行插入和查询操作相比,IBF的独特解码能力赋予其极大的实用价值,能够在网络同步、数据库去重、分布式缓存一致性校验等场景中减少通信开销和计算负担。为了保证剥离过程的成功率,IBF的大小通常设计为对称差大小的1.22倍以上,并结合高质量的哈希函数,以优化元素均匀分布和避免冲突。

此外,尽管对对称差的大小存在预估需求,近期研究引入了“无损率(rateless)”IBF,支持动态调整结构大小,适应差异规模不确定或动态变化的情况。可逆布隆过滤器还借鉴了图论中随机超图的核心剥离算法,通过构建元素与单元格的二分图模型,利用概率方法提高解码的成功概率和效率。这种跨领域融合使IBF具备更强的理论基础与实际表现。在实际应用中,IBF能够处理数十亿条数据而不会造成存储瓶颈。对于大规模日志同步、多端数据一致性、分布式文件系统差异检测等场景,IBF提供了一种轻量级且高效的解决方案。使用IBF,不再需要传输完整数据集,只需交换大小取决于差异的IBF结构,即可实现快速差异定位与同步。

当前各类编程语言中IBF的成熟度尚不及经典数据结构高,但社区逐渐开始关注与实现。开源示例与教程逐步丰富,方便开发者实践并针对具体业务需求优化相应的哈希策略与参数配置。对于需要实时或近实时处理的系统,IBF是极具潜力的数据结构,能够降低带宽消耗,提升数据处理效率。集和差异问题是现代数据管理的基础难题之一,尤其在分布式和云计算环境下显得尤为重要。从最初的简单XOR技巧,到多分区哈希,再到引入统计检测与校验,在不断拓展应用边界的过程中,IBF作为创新结合的典范,展现了融合数学原理与工程实践的巨大潜力。未来随着硬件计算能力及算法优化不断发展,IBF及其衍生技术有望成为大数据领域中不可或缺的基础工具。

尽管IBF对预估差异大小及哈希函数依赖存在一定限制,仍有研究在应对这类问题上取得进展,推动算法更智能化和适配多变环境。同时,IBF思想被不断扩展到多方集合同步、多字段编码等复合场景,满足更复杂且多样化的业务需求。掌握IBF的基本原理与实现细节,将助力数据科学家、后端以及数据工程师高效解决海量数据集的比较与同步难题。推进数据一致性的保障,降低分布式系统通信与存储成本。在未来数据驱动决策和智能应用中,IBF赋能的高质量数据处理能力将发挥越来越关键的作用。总而言之,将XOR技巧延伸至可逆布隆过滤器的发展,帮助我们跨越了传统方法在规模和复杂度上的桎梏,为大规模集合交互与差异恢复开辟了新路径。

随着理论研究和技术实现不断深化,IBF将在大数据生态系统中焕发更强生命力,助推数据科学与工程迈向新的高度。