随着人工智能技术的迅猛发展,AI系统在众多领域展现出令人瞩目的能力。然而,AI的运作机制本质上是一种概率过程,这一特征对AI的测试和评估方法提出了全新挑战。传统软件测试强调确定性,即每次输入都应产生确定的输出,且结果可复现。然而,AI模型特别是基于深度学习和生成模型的AI,其输出往往是概率分布的结果,而非固定值,这就导致测试策略必须围绕概率性进行重新设计和思考。所谓概率性,指的是AI模型在面对相同输入时可能产生不同的输出,这种不确定性源于模型内部的权重初始化、随机采样以及训练过程中所形成的复杂模式表达。举例而言,一个自然语言生成模型在生成回答时,可能基于语境和语料库中概率最高的词汇或句式作为输出依据,因而同样的问题不完全相同的回答时有发生。

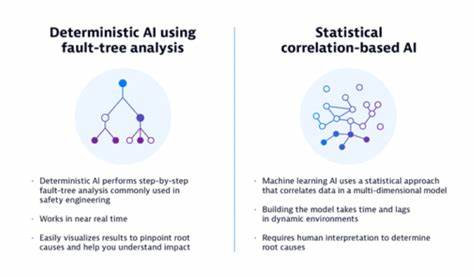

试图用传统的确定性测试方法去检验这类模型,很可能误判模型的表现,忽视它的潜在能力或者问题。AI测试需要拥抱其概率属性,承认模型行为的多样性。例如,评估模型的准确性不应单看单次输出,而需要通过多次采样结果的分布来判断其整体性能和稳定性。这就要求设计更为灵活且复合的测试方案,例如统计分析、置信区间评估以及多次执行结果的聚合比较。这些方法能够提供关于模型行为更全面深刻的洞察,避免因个别异常结果带来的误导。此外,AI系统的应用场景多样且动态,模型训练数据和环境可能随时变化,这也令测试结果具备时效性。

持续集成与持续部署(CI/CD)结合概率测试是现代AI项目的必然趋势,通过自动化评估多版本模型表现,研发团队能及时捕捉性能波动和潜在风险,从而持续优化和迭代。在此背景下,测试工具和框架同样必须革新,支持对模型结果的概率统计分析,高效处理大量测试数据并生成直观的性能对比报告。未来AGI等工具已经开始提供这些功能,帮助开发者在保持高效开发节奏的同时,兼顾AI系统的复杂性和多样性。然而,概率性的 AI 测试并非没有挑战。首先,测试设计更加复杂和资源消耗更大,需要对测试用例进行多次重复执行。其次,结果的评判标准需科学制定,避免因过度容忍波动导致质量下降。

此外,如何解释和利用这些统计结果,让非专业人员也能理解AI表现,也是推广应用的关键。总结来看,AI的概率性决定了测试不应停留在传统的确定性框架内。拥抱概率和不确定性,设立科学合理的评估指标,结合自动化的评测流水线,构建灵活适应的测试体系,是保障AI系统稳定、可靠和持续进化的基石。只有如此,才能真正发挥AI技术的潜力,在复杂多变的实际环境中实现卓越表现,满足不断增长的应用需求。 。