在大数据时代,快速有效地处理海量数据已成为推动企业创新与发展的关键。随着数据规模不断攀升,传统的查询和筛选方法逐渐显现出瓶颈,尤其是在需要从海量日志、事件或追踪信息中寻找"针"的场景下,性能的限制可能成为企业的致命问题。Axiom公司推出的Haydex项目,正是一次面对极限挑战的大胆实践,用仅仅30天时间,从最初的零突破到实现每秒处理达1786亿行数据的壮举,彻底刷新了数据处理速度的天花板。Haydex的成长历程不只是技术优化,更是一场对架构设计、实现策略和系统工程极限的深刻探索。本文将带您深入了解Haydex如何实现这一奇迹般的飞跃,以及这段传奇背后的关键技术细节和经验总结。 问题的起点始于极慢的"针扎草堆"式查询。

对于专注数据库性能的团队来说,查询效率不过关是无法容忍的危机信号。以Hyperscale Customer为代表的超级大规模用户,面对海量滚动产生的数据,原先采用的暴力扫描方式几乎无异于用茶匙在星球大小的沙滩上寻找单个沙粒。为了克服这一挑战,曾经尝试的一代Haydex技术(V0)采取了将数据切分为微小"区块",并对每个区块建立独立过滤器的思路,试图通过概率过滤器减少扫描数据的规模。虽然理论上滤器能快速判断某条记录是否"肯定不存在",从而避免不必要的扫描,但V0的设计节奏太过分散,导致查询时产生成千上万个对存储系统的单次小文件请求,每次请求的网络和存储延迟叠加,最终导致整体性能严重下降,甚至比之前的方法更慢。 这场"死亡于成千上万次GET请求"的惨痛经历,让团队彻底意识到,数据存储访问策略和I/O架构并非"细节",而是影响性能成败的主角。正是在这样的教训中,Haydex从零开始重新设计,决定彻底推翻原有碎片化过滤器策略,转而采用覆盖成千上万区块的大型字段范围过滤器。

改变的关键在于,从过去以块为单位的小过滤器,转变为以字段为单位覆盖大量区块的"大过滤器"结构。原来算法中,每个区块对应一个单独过滤器文件,如今一个字段集合为一个过滤器,大幅度降低了读取次数,由需要成千上万次请求压缩成单次甚至极少次数的访问,极大提升了I/O效率。 除了对过滤器架构的根本性调整,团队还放弃了过于复杂的"自适应执行"机制,转而选择了在查询初期就进行尽早的粗粒度区块剔除。优化目标是避免查询后期过早展开到数千节点,在确认区块不相关之前就耗费计算和网络资源。如此一来,查询策略变得更加简单直接,同时有效减少了大量不必要的数据传输和处理。Haydex V1正是基于这些原则快速成型,并且以惊人的速度进入生产阶段。

工程实施的复杂性不限于软件层面。数据库元数据查询的瓶颈首先浮现。Haydex需要快速定位哪些区块包含感兴趣数据的索引,然而Postgres中存储的元数据结构和查询方式却导致响应极为缓慢。通过架构性重构,废弃了需全表扫描的数组结构,替换为高效的映射表并增加缓存层,元数据查询延迟立即降低了九成以上。这一瓶颈的解决,为后续的快速索引构建奠定了坚实基础。 高速hash计算的CPU消耗和垃圾回收压力,也是制约性能的关键因素。

Haydex团队剖析代码,彻底重新编写了核心的哈希列处理逻辑。消除中间对象的频繁分配,利用对象池复用内存,优化了对常用ASCII字符串的处理路径。结果是CPU使用效率提升了70%以上,内存分配削减超过90%,这不仅提高了执行速度,也显著降低了系统的GC压力和稳定性风险。 单节点索引器因内存不足和GC"僵尸"状态表现出性能天花板,促使团队迅速转向全分布式架构。基于MapReduce灵感的分布式设计,将数据划分为多个小任务,派发给大量Lambda工作节点并行处理,减少单节点压力。最终在6月中旬完成部署后,索引构建性能从3分半骤降到仅需30秒,大规模后备数据周级回填在6小时内完成,达到了此前无法企及的效率。

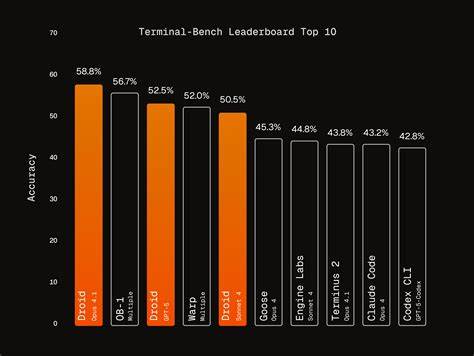

但分布式设计带来的复杂性难题也接踵而至。网络传输上下文的过早取消导致任务失败,需要谨慎修复背景任务管理逻辑;S3接口批量删除限制要求拆分并发分批执行,避免操作失败;多部分上传的间歇性错误促使参数机制更灵活调整等,都构成了一系列细致且重要的工程挑战。 存储元数据加载的不合理激进策略也成为性能瓶颈源头之一。为了加快查询初期的块剔除,设计了"懒加载"机制 - - 先只加载轻量版的块摘要,利用过滤器和零匹配缓存迅速淘汰大量无关块,再回头只加载少数通过筛选的块的完整元数据。这一思路为高效的查询过滤节省了近13倍的时间,在超大规模数据场景表现尤为显著。 7月底,Haydex在生产环境实测达到了1100亿行每秒的实际吞吐量,面对真实、杂乱无章的万亿级数据,证明了其技术栈的非凡实力。

随后零匹配缓存重新激活,协同作用将性能推升至1786亿行每秒;再加上缓存配合,峰值甚至达到了6738亿行每秒的天文数字。这些数据不是实验室中的合成基准,而是在严格的生产环境下长时间实际运行的结果,彰显了Haydex工程方案的极致可用性与工业级稳定性。 回顾整个过程,Haydex的成功无疑向业界传递了几个重要信号。首先,系统设计必须从最底层的网络物理原则出发,不能将I/O成本当作可以后期"补救"的细节。其次,对性能问题的解决依赖于细致入微的工具支持,性能分析器是发现并解决隐藏消耗的唯一神兵利器。再者,优化是一个不断涌现新瓶颈的过程,真正的高性能软件需具备持续迭代的韧性与工程文化。

最后,速度的提升需要付出成本与技术积累,而非简单的参数调优或配置调整。 未来,Haydex团队计划引入分层索引结构,打磨"热""温""冷"不同数据索引,进一步提升近实时数据的查询加速能力。自动化清理机制"清道夫"也在研发,让系统长期保持轻量与高效。针对更复杂的APL查询优化及持续消除系统瓶颈的探索,将成为长期的工程使命。 Haydex的故事是现代分布式系统与大数据处理技术的缩影,展现了工程师在极端性能需求面前的创新与坚持。对任何希望在海量数据时代保持竞争力的技术团队来说,它不仅提供了宝贵的经验教训,也展示了通过精准设计与不懈优化,实现数据处理效率跃升的可能路径。

30天时间完成这样划时代的技术突破,是对工程极限的挑战,更是对技术精神的礼赞。随着未来更多瓶颈被攻克与新能力的赋予,Haydex无疑将在数据处理领域继续书写传奇。 。