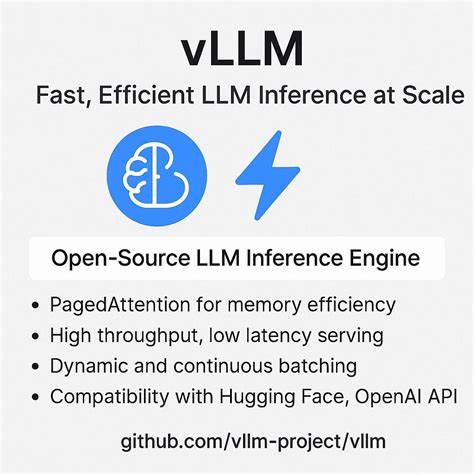

随着人工智能技术的飞速发展,大型语言模型(Large Language Models, LLM)在自然语言处理、智能问答、机器翻译等领域展现出强大的能力。然而,如何在实际应用中高效地服务这些庞大且计算密集型的模型,成为摆在行业面前的重要挑战。vLLM V1作为一个开源的推理引擎,以其卓越的架构设计和性能表现,成为解决大规模LLM推理难题的关键工具。本文将深入剖析vLLM V1推理请求的生命周期,详解其如何借助创新技术和架构实现高效且可扩展的模型推理服务。 首先,理解vLLM的请求始于用户通过API发送的推理请求。这些请求遵循OpenAI兼容格式,客户端将请求发送至vLLM的API服务器。

API服务器负责初步的HTTP通讯处理和身份验证,保障请求的合法性和安全性。接着,API服务器调用AsyncLLM模块的generate()方法处理请求文本。AsyncLLM作为异步封装层,承担文本的分词(tokenization)任务,将输入的自然语言转换为模型可理解的Token ID序列。值得注意的是,AsyncLLM和引擎核心EngineCore运行在不同的进程中,避免了Python全局解释器锁(GIL)的限制,使得CPU密集型和GPU密集型任务能够并行执行,大幅提升系统吞吐量。 在请求传递到EngineCore之后,核心调度模块Scheduler开始发挥关键作用。调度器维护两个关键队列:等待队列和运行队列。

等待队列包含新的或者暂停中的请求,运行队列则存放正在积极生成响应的请求。Scheduler根据当前Token预算和请求优先级,不断调整请求的批次执行规模。vLLM引入的连续批处理算法允许在固定的Token预算内灵活组合多个请求的Token进行统一前向传播,从而极大地提高GPU利用率同时保证请求处理的公平性和响应速度。 该调度机制的优势在于不仅可以在预填充(Prefill)阶段将所有输入提示Token合并处理,也能在解码(Decode)阶段顺序地逐Token生成输出。预填充阶段是模型计算注意力机制以建立上下文记忆的关键时期,所有输入Token的Key(K)和Value(V)张量会被缓存于GPU内存的KV缓存中以备后续调用。解码阶段,模型根据前一时刻的输出生成下一个Token,必须逐步迭代完成。

vLLM确保所有请求均完成预填充后才进入解码阶段,有效避免资源冲突。 在GPU内存管理方面,vLLM采用创新的KV缓存分页机制,将注意力机制中各Token的K/V张量划分为固定大小的KV块并分配管理。这种分页设计不仅避免了单次大块内存申请的瓶颈,也支持动态分配和释放,有效利用有限GPU显存资源。KVCacheManager模块负责整个缓存的生命周期管理,能够在调度阶段为请求动态分配和回收KV块ID,并在模型执行时快速定位对应缓存区域,为ModelRunner提供所需上下文。 在具体的模型执行环节,ModelExecutor利用ray分布式计算库启动各GPU工作进程(Worker),每个进程内部的ModelRunner负责加载模型权重并执行前向传播计算。ModelRunner对来自Scheduler批处理的请求进行整合,将所有待计算Token构建为大规模张量并逐层传递至Transformer结构的各个层。

每层计算后,Key、Value和Query(Q)张量被生成,Key和Value被缓存,Query则用于当前层注意力权重计算。GPU庞大的并行计算能力在此得到充分发挥,利用SIMD和多线程实现高效矩阵乘法和张量运算。 为进一步提升性能,vLLM使用优化的FlashAttention算法(FlashAttention-3),该算法专门针对Transformer注意力机制进行加速,减少内存访问和计算冗余。以64层深的Transformer为例,每次引擎循环都包含对所有层的前向调用,确保模型在每个推理步骤都精准高效地完成计算。推理完成后,模型输出最终层的logits张量,经过采样策略处理(如贪婪搜索或温度采样),生成下一Token。随后这些Token被存入内部输出队列,等待异步回传至AsyncLLM。

AsyncLLM接收到新生成的Token后,进行反分词(detokenization),将Token ID转换为文本格式,并将结果推送给API服务器。根据是否启用流式传输(streaming),API服务器可以逐块向客户端推送部分响应,提升用户体验,或等待所有结果生成完毕后一次性返回。通过这种设计,vLLM不仅保证了推理的实时性,也灵活兼容多样的应用场景。 整体来看,vLLM V1架构通过模块化设计清晰划分职责,利用异步进程间通讯和连续批处理算法优化资源利用,施行细粒度GPU内存管理,有效突破了传统推理服务多请求处理中的效率瓶颈。其开源属性加速社区研发,也为AI工程师提供了定制和扩展推理引擎的便利。 对于希望部署和运行大型语言模型的技术团队而言,深入理解vLLM请求生命周期有助于更好地调优配置,提升服务稳定性和性能。

尤其是在用户量激增和复杂交互层出不穷的当下,如何兼顾吞吐率、延迟和成本成为关键考量。vLLM提出的设计理念和具体技术方案,正是迎合这些需求的有效解法。 此外,vLLM的架构具有较强的可扩展性和灵活性,无论是单机多GPU还是分布式环境,都能通过调整Scheduler和ModelExecutor组件实现负载均衡和弹性伸缩。未来,随着基础硬件加速技术和Transformer模型架构的不断进步,类似vLLM这样的推理引擎将持续引领行业创新,为更多AI应用场景提供坚实的算力保障。 总结而言,vLLM V1的推理请求从客户端输入经过多层处理和调度,最终依托高性能GPU完成模型前向计算,生成结果输出给用户,构成了一个高度优化且高效的推理服务闭环。其采用异步进程架构消除GIL瓶颈,连续批处理算法提升批量利用率,KV缓存分页机制保障显存资源管理,FlashAttention加快核心计算,每一步设计均以提升吞吐和降低时延为目标。

这些综合优势使vLLM成为开源领域中高性能LLM推理服务的标杆,值得人工智能开发者和研究者深入学习和应用。