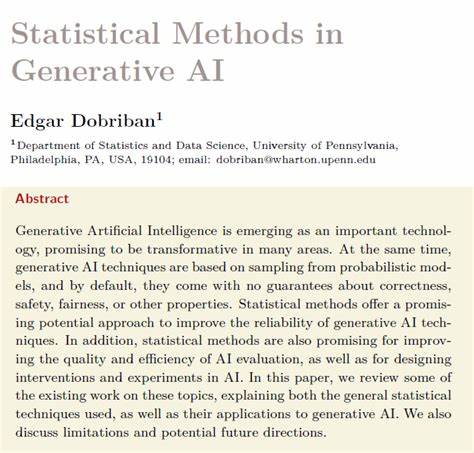

生成式人工智能(Generative AI)在近年来迅速崛起,成为推动人工智能变革的重要动力。从文生图、语音合成到自动文本生成,生成式AI凭借其强大的创造能力不断拓展应用边界。然而,这项技术背后隐藏的复杂性以及不确定性,也带来了诸多挑战,其中如何提高生成结果的可靠性、质量和效率成为亟待解决的问题。统计方法作为传统数据科学中的核心手段,为生成式AI提供了理论基础和实践工具,用以规范模型行为、提升性能表现和优化评估流程。生成式AI本质上依赖概率模型进行样本生成,这意味着模型输出蕴含着概率分布的不确定性,且无法完全保证生成内容的正确性、公平性或安全性。统计学恰恰擅长处理不确定性与变异性,通过假设检验、置信区间和校准技术等手段,可以对生成模型输出进行严格分析和评估,从而提升生成内容的可信度。

尤其是在模型训练和推断阶段,应用统计学方法能够实现更合理的参数估计和误差控制。例如,贝叶斯方法通过先验知识与数据观测的结合,使得模型对未知情况表现出更强的泛化能力。另一个重要方向是生成式AI的质量评估。评估生成内容的多样性、连贯性和真实性向来是一个难题,传统的人工评审耗时且主观。借助统计学中的抽样技术和假设检验,能够设计更科学的评价指标和自动化测试方案,保障评测结果的公正性与稳定性。统计方法还推动了生成模型的实验设计与干预策略发展。

通过因果推断、随机对照试验和灵敏度分析等技术,研究人员可以更系统地理解模型行为和改进机制,避免盲目调整带来的意外后果。例如,针对生成内容中的偏差问题,统计学可以帮助识别潜在的公平性风险并提出纠正方案,确保模型输出符合伦理标准。除此之外,统计方法在提升生成系统效率方面同样功不可没。利用采样优化算法和置信校准技术,可以减少生成过程中的计算成本,提高响应速度,特别是在大规模应用和实时交互场景中显得尤为重要。尽管统计方法在生成式AI领域展示出巨大潜力,但仍存在一些挑战和局限。一方面,生成模型的复杂性和维度极高,传统统计方法难以直接应用,需要结合深度学习技术发展新的理论和算法。

另一方面,数据的偏差和分布漂移对统计推断带来考验,要求研究者在设计模型和评估指标时充分考虑数据质量和多样性。未来,统计方法与生成式人工智能的融合将更加紧密。一方面,随着计算能力提升和理论进展,基于统计推断的生成模型将更具解释性和可靠性。另一方面,跨学科合作有望催生创新工具,支持从生成内容的安全校验到动态算法调优的全链路优化。对于行业应用而言,统计方法不仅帮助实现更高质量的内容生成,也为合规性审核、风险管理提供技术支撑。例如,在医疗、金融等敏感领域,统计保障机制能够确保生成结果符合专业标准,降低误导风险。

综上所述,统计方法在生成式人工智能的发展中扮演着不可或缺的角色。它不仅为复杂模型的训练和推断提供理论支撑,也为评估和优化生成效果提供科学依据。随着技术日益成熟,期待统计学与生成式AI的深度结合能够推动人工智能朝着更安全、可靠和高效的方向迈进,赋能各行各业实现数字化转型。 。