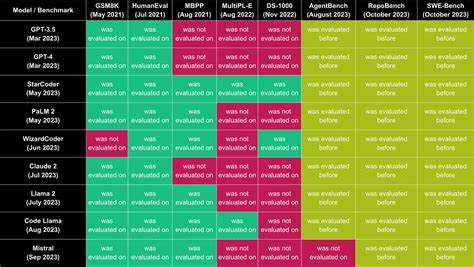

随着人工智能技术的迅速发展,大语言模型(LLM)已成为推动智能应用创新的核心引擎。从文本生成到智能客服,从代码辅助编写到知识问答,LLM的应用场景日益丰富。然而,面对多样化的API服务提供商和本地自托管模型,评估和比较它们的性能表现成为开发者和企业的迫切需求。基于此,市场上涌现出了一款专门用于基准测试LLM API的工具,能够帮助用户全方位分析不同模型的响应速度、输出效率及稳定性,为选择最合适的方案提供科学依据。该工具具备灵活的配置选项,支持对接多种协议及API接口,无论是主流的OpenAI和Anthropic的Claude,还是本地部署的自托管模型,都能轻松纳入测试范围。用户只需填写API地址、密钥以及待测模型名称,便可通过自定义测试提示词发起多轮测试,实时获取详细的性能数据。

工具的核心指标包括首次Token响应时间和后续输出速度,分别衡量模型的启动响应及持续生成能力。此外,成功率和错误率的数据统计帮助用户全面了解模型的稳定性表现。测试过程中,用户可通过实时视图动态监控各模型输出进程,快速捕获异常或性能瓶颈,从而加速问题定位和优化调整。历史测试记录和统计分析功能便于长期跟踪不同版本模型的性能趋势,确保在持续迭代中做出精准判断。这款基准测试工具的意义在于,它直观呈现了多种主流和自托管LLM在真实场景下的表现差异,帮助技术团队避免盲目跟风或单一依赖某一家供应商。通过科学测试数据,企业能够优化成本结构,同时满足业务对响应速度和生成质量的双重需求。

在当前AI生态日渐繁荣的背景下,工具的开放性和扩展性也极其重要,它支持更多模型接入和定制化测试,赋能开发者社区共同推动技术进步。未来,随着模型技术与硬件资源的不断演进,这类基准工具还将进一步融合更多评测维度,如多语言支持、上下文理解能力和推理复杂度等,帮助塑造更具竞争力的智能服务体系。综上所述,借助此LLM API基准测试工具,使用者可以全面评估OpenAI、Claude及本地自托管模型的实际性能表现,不仅提升了AI解决方案选择的科学性,也保障了智能应用在用户体验和运行效率上的高品质表现。对于各类希望高效部署大语言模型的技术人员和决策者而言,掌握这一性能测试利器无疑将加速创新步伐,奠定未来智能业务的坚实基础。