随着人工智能、大数据和科学计算的迅猛发展,矩阵乘法作为基础的数学运算,承担着越来越重的计算任务。无论是深度学习模型训练,还是模拟复杂物理系统,矩阵乘法的性能瓶颈都直接影响整体计算效率。为了打破这一限制,计算机科学家们不断探索创新算法和硬件优化手段,实现加速矩阵乘法的目标。矩阵乘法理论基础源自线性代数,通过两个矩阵的行列组合,实现向量和系数的运算叠加。传统的矩阵乘法时间复杂度为O(n³),对于大规模数据而言,计算量极其庞大。对此,早期的优化方案包括Strassen算法及其分治策略,降低了运算复杂度,但现实中的应用受限于数值稳定性和实现复杂度。

进入深度学习时代,矩阵乘法的需求呈指数增长,尤其在GPU和TPU等专用硬件普及后,如何最大化硬件资源利用率成为关键。矩阵乘法加速的方法可以从算法优化和硬件设计两个方向展开。算法层面,研究者提出多线程并行处理、块矩阵分割以及缓存优化策略,通过减少内存访问瓶颈和提高数据重用率,显著提升运算速度。硬件层面,设计专门的矩阵乘法协处理器,利用流水线和并行计算架构,将矩阵运算分摊成更小的子任务同时执行,进而降低整体延迟。近些年来,矩阵乘法的“黑客”技术兴起,即通过创造性利用计算机体系架构漏洞或优化潜力,突破传统性能极限。这些技术通常包括利用SIMD指令集对矩阵数据做高度并行化处理,深度挖掘缓存系统,提高内存带宽效率,甚至重构底层数据存储格式以适配计算流。

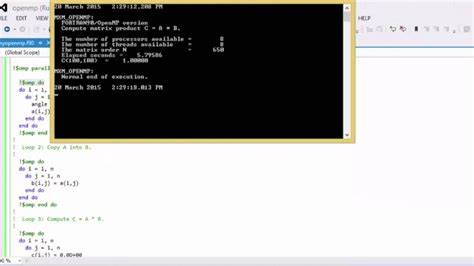

视频中所提及的矩阵黑客技术,展示了多种软硬件层面协同提升矩阵乘法速度的创新方案。例如,通过专门设计的数据排布,减少缓存未命中率,加快数据加载和写回过程;借助强大的SIMD向量指令,将多个矩阵元素打包一起并行计算;利用CPU和GPU间的异构计算资源动态调度,实现负载均衡和资源最大化利用。这些技术组合使得矩阵乘法的效率提升数倍甚至十数倍,极大推动计算密集型应用的性能边界。值得关注的是,矩阵乘法加速不仅是提升单台计算机性能,更是分布式计算和云计算领域的重要基石。通过优化矩阵运算,能够降低整体算力资源消耗,实现更高能效比,为海量数据处理和实时智能分析提供坚实支持。与此同时,相关研究还在不断演进,例如探索基于张量核的矩阵运算,加速非方阵和稀疏矩阵计算,以及结合机器学习优化算法选择和参数调整,进一步挖掘加速潜力。

总体而言,矩阵乘法加速技术代表了计算机科学领域的前沿趋势。它不仅需要深厚的理论支撑,还依赖软硬件协同创新。未来,通过矩阵黑客方法突破性能瓶颈,将为人工智能、大规模仿真、金融分析等领域带来革命性提升。对于开发者和科研人员而言,深入理解和掌握这些技术,尤为关键。这样才能在激烈的技术竞争中,抢占先机,推动计算极限的不断刷新。矩阵乘法优化不仅关乎速度,更代表了计算机架构和算法设计的融合创新。

随着更多先进技术的涌现,矩阵计算加速正迈向更广阔的应用和更强的功能,为全球信息技术发展注入不竭动力。