大型语言模型(LLM)近年来在自然语言处理领域掀起了革命,它们以惊人的性能推动了机器翻译、文本生成、问答系统等多种应用的进步。然而,这些模型规模庞大,参数数量动辄数十亿至上千亿,导致存储和计算资源消耗巨大,难以满足实际部署中对高效性的需求。尤其是在边缘设备或资源受限的场景下,如何保证模型既小巧又高效,同时不损失性能,成为了业界亟待解决的重要问题。针对这一难题,量化技术应运而生,尤其是低比特量化(如2位三元量化)因其极大减小了模型存储大小和计算需求,备受关注。但低比特量化常常伴随着训练和推断时的性能大幅下降,导致模型精度不稳定,难以广泛推广。近期由Cody Steinmetz等研究者提出的新方法“An Extra RMSNorm Is All You Need for Fine Tuning to 1.58 Bits”提供了令人振奋的解决方案,可谓当下微调与量化技术领域的重要突破。

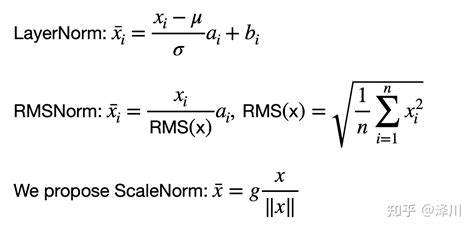

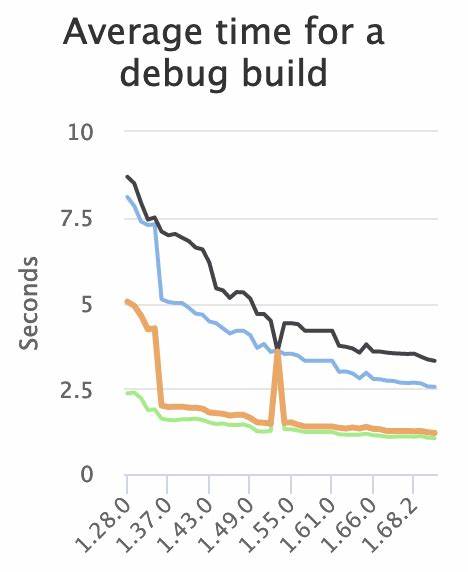

这项研究的核心创新是通过在Transformer架构中的每个线性投影之前添加一个额外的RMSNorm层,并结合逐层渐进量化策略,实现了稳定且高效的微调过程,将全精度模型安全地转化为超低位宽的三元模型,而无需额外复杂的知识蒸馏过程。RMSNorm(Root Mean Square Normalization)是一种归一化技术,相较于传统的Layer Norm,不依赖偏置,计算更加简洁且适应性强。该方法利用RMSNorm对网络内部特征进行有力的标准化处理,缓冲了三元量化过程中因幅值极端缩小带来的梯度失真和训练不稳定。此外,逐渐递进的量化策略则在微调过程中逐层引入量化扰动,使得模型能够平滑适应低精度参数的约束,避免单步剧烈变化造成的性能崩溃。实验证明,该方案能够在多个标准语言模型基准测试中匹配甚至超越现有的复杂知识蒸馏管线的表现,且无需引入额外模型复杂度,这在业界和学术界都具有深远意义。具体来说,研究团队针对现有偏置自由、RMS规范化的Transformer架构,通过在每个线性层前额外插入一层RMSNorm,显著增强了模型对量化扰动的鲁棒性。

结合直通估计器(Straight-Through Estimator)技术进行反向传播,模型能够在保留精度的同时,将浮点数权重逐步逼近三元形式,实现了1.58比特的超低精度表示。该量化精度远低于传统的8位甚至4位量化,极大地压缩了模型参数存储需求及推理计算量,促进了高效部署。这项工作开启了超低比特量化微调的新路径,不仅展示了归一化技术在量化中的关键作用,也为进一步降低大型语言模型推理成本提供了有力支持。相比以往依赖复杂知识蒸馏、多阶段训练或模型结构改造的方案,额外RMSNorm提供了一种简洁而高效的策略,无需新增模型参数,便捷易行。对于未来应用而言,这意味着在不牺牲模型性能的情况下,更容易实现大规模模型在云端、移动端乃至嵌入式设备上的实时部署。量化是大模型实际应用中的热点技术,各类先进算法层出不穷,但仍存在稳定性差、性能下降明显的问题。

此项研究证明了细致的归一化处理结合渐进量化调整,是解决低比特量化难题的有效途径。除了在自然语言处理领域,其核心思想也有望推广至图像识别、语音处理等其他深度学习任务,推动整个AI产业迈向更加绿色高效的智能计算时代。未来研究可基于此方法探索进一步压缩至单比特量化、结合剪枝技术优化模型结构等方向,期望达到更优的性能与效率平衡。同时,如何结合硬件加速器设计,支持新型归一化算法与极低位宽运算,也是值得关注的重点。总的来看,“An Extra RMSNorm Is All You Need for Fine Tuning to 1.58 Bits”不仅解决了超低比特量化训练中的核心难点,也为大型模型的轻量化部署树立了新标杆。随着人工智能应用日益深入各行各业,掌握高效且稳定的模型压缩技术,将成为推动智能化广泛落地的关键引擎之一。

该研究以其理论创新和实际效果,必将成为未来低比特量化领域的重要参考,同时激励更多学者和工程师探索更加简洁高效的模型精简之道。