在人工智能和自然语言处理领域,训练大型语言模型一直是推动技术进步的重要动力。然而,对于资源有限的研究者和开发者而言,训练微型(tiny)语言模型面临着数据稀缺和多样性不足的挑战。SimpleStories项目应运而生,为这类模型提供了一个大规模、结构化且合成的文本数据集,极大地推动了小型语言模型的发展。SimpleStories是一个包含超过200万条由最新生成模型创作的短篇故事的数据集,旨在通过高质量的合成文本训练微型且可解释的语言模型。它采用了先进的参数化故事生成方法,突破了传统数据收集的局限,确保了内容的不断创新和多样性。SimpleStories的核心优势在于其详细的故事元信息注释,涵盖了故事的主题、风格、修辞手法、文本结构及多项语言学特征。

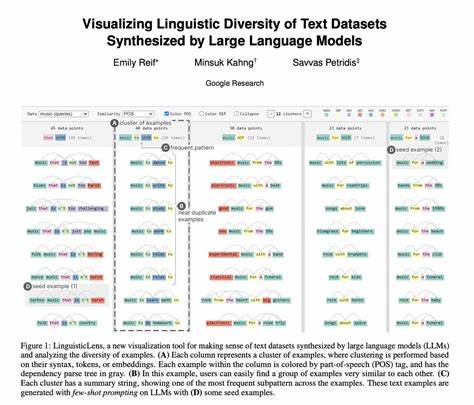

这种精细化标注使得训练过程不仅限于语言理解,还能通过多维度约束,实现更具创意和适应性的文本生成。例如,数据集中故事被标注了“主题”如友情、冒险、成长等,“风格”包括幽默、抒情、传奇等“修辞”特征,以及多个句法和语义指标,从而为训练模型提供精准的学习目标。与传统的自然采集文本数据相比,Synthetic(合成)数据的显著优势是能够通过设定明确参数来控制文本属性和多样性。SimpleStories利用2024年最新的生成模型—如GPT变体,创建了包含丰富内容和语言变化的故事,保证了训练数据的多样和高语义准确性。这种生成过程是开源的,支持研究者自行调整故事题材、文本长度及语言风格,以满足不同训练需求。此外,SimpleStories对包含的故事文本进行了严格的质量监测和多种NLP指标计算,如Flesch阅读指数、句长及词频分析,确保最终数据质量满足机器学习严苛要求。

数据采用Parquet格式进行存储和分发,兼具处理效率与存储优化,便于快速加载和批量处理,极大提升了训练流水线的效率。SimpleStories不仅支持英语,还计划扩展至日语等多种语言,这与全球化的语言模型应用趋势相契合。多语言版本的开发将助力构建泛语言的小模型,实现跨语言迁移学习和多语言生成能力。该数据集在Hugging Face平台发布,方便全球开发者快速获取和应用。多个公开发布的SimpleStories模型,涵盖1.25M至35M参数量区间,已经展示出利用该数据集训练的微型模型可以在文本生成任务中取得优异表现。这对于轻量级设备和边缘计算应用尤为重要,比如智能助手、手机端应用以及低功耗物联网设备。

相比大型预训练语言模型,微型模型具备体积小、推理快和可解释性强的优势。SimpleStories数据集的引入,有效降低了训练门槛,使得更多资质有限的开发者能够体验到自然语言生成最新技术成果,从而促进了创新生态的发展。在学术层面,SimpleStories的问世带来了新的实验范式。研究人员可以利用该数据集探索故事生成的参数化控制,理解不同语义与句法特征对生成质量的影响,并研究微型语言模型的知识蒸馏和迁移策略。此外,数据集丰富的故事内容和多样的结构为文本生成、阅读理解及文本摘要等下游任务提供了良好基础。SimpleStories的设计理念深受TinyStories项目启发,二者均强调通过合成生成控制故事复杂度和易读性,从而确保训练模型具有解释性和泛化能力。

不同的是,SimpleStories的规模更大,注解更细,功能更完备,切实满足了2024年微模型需求的爆发式增长。展望未来,SimpleStories有望持续更新版本,不断扩展语言种类及故事样式,同时结合强化学习和人类反馈进行优化,进一步提升生成文本的自然度和实用性。同时,它也为多模态融合(例如文本+图像)打下坚实基础,为开发全新交互体验奠定素材基础。总体来看,SimpleStories作为首批大规模合成短篇故事数据集之一,在微型语言模型训练领域具有里程碑意义。它不仅突破了模型训练“数据瓶颈”,还通过开放和高质量的生态建设,促进了AI民主化和可持续发展。随着更多应用落地和社区反馈不断积累,SimpleStories必将成为推动小型语言模型技术跃迁的坚实基石。

对于AI爱好者、开发者及教育者而言,深入理解和利用这一数据集,将开启加速创新与普及智能语义处理的全新篇章。