随着社交媒体的不断发展,内容审核成为了公众和平台运营者关注的焦点。在推特等主流平台因内容管理问题频频引发争议的背景下,Mastodon作为一款去中心化的社交网络,因其独特的内容审核方式而备受观察。然而,关于Mastodon内容审核体系的讨论常常存在误解甚至偏见,有声音称其将成为内容管理的混乱重灾区,而事实往往比传言更加复杂和多元。Mastodon的核心创新在于联邦制架构,这使得平台并非由单一集中的实体控制,而是一系列独立运营的服务器(被称为“实例”)组成的开放网络。每个实例都有自主的管理团队和社区标准,针对用户行为及内容进行相应的审核和管理。这种分散管理模式给予社区更大的自治权,同时也让内容管理变得更加灵活和贴近各自文化氛围,但也由此带来了挑战。

许多人担忧联邦制会导致审核标准混乱、无法统一,甚至成为不良信息的藏身之地。事实是,Mastodon用户选择加入的实例往往基于其社区规范和价值观,有的实例可能对于言论自由有更宽松的态度,而有的则会严格审查仇恨言论、骚扰以及其他不当内容。这种选择权本身就是Mastodon区别于传统社交媒体的重要优势之一,因为用户能够根据自身需求寻找最适合的社区环境。通过实例间的“联邦屏蔽”机制,社区维护者还能针对表现恶劣的实例进行全面屏蔽,防止恶意用户跨实例传播不良内容。例如,当某个实例因管理员纵容仇恨言论而声誉受损,其他实例的管理员有权选择断开与其的交流连接,从而保护本地用户的健康环境。这种社群自治和实例互助互动的模式,在实际操作中为用户营造了更为洁净和安全的网络空间,远非简单的“审核混乱”所能概括。

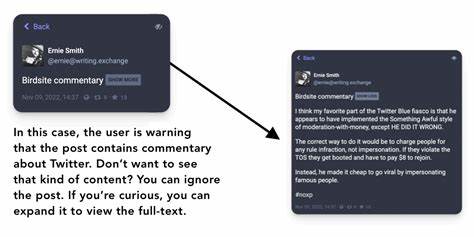

Mastodon在内容嵌入和分享功能上的便利也增强了用户体验。用户可以轻松地共享所谓的“toots”——类似于推文的内容单元,方便地复制嵌入代码,将独立的toot内容整合到外部网站上。这不仅提升了平台的开放性,也促进了内容的跨平台传播。面对掉以轻心的仇恨和攻击言论,Mastodon的多个实例社区展现出及时的反应能力。当用户遭遇恶意攻击时,通过举报功能,该信息会直接反馈至相关实例的管理员,由管理员根据实例的政策决定是否采取封禁或警告措施。此外,用户可自行屏蔽攻击者账号,阻断其对个人内容的访问,保障自身权益。

尽管如此,内容审核工作并非无懈可击。由于社区价值观和文化背景的多样性,有时用户可能遭遇因实例规则较严或较宽而带来的不同体验。例如一些用户因与实例调性不符的行为被限制,或因管理员判断的差异而产生矛盾。对此,用户选择加入与自身理念相符的实例显得尤为重要。另一方面,实例管理员在平衡言论自由与社区安全之间也面临艰难抉择,往往需要耗费大量精力进行判断和沟通,确保审核标准既不失严格又不流于极端。与大型中心化社交平台相比,Mastodon的审核机制更贴近社区自治精神,更注重用户体验和多样化需求。

在主流平台上,算法和大规模自动化审核常导致误判、多次争议,用户往往难以获得有效申诉。Mastodon则通过人性化的管理团队和多层次的社区监督,为用户提供了更为灵活和透明的内容管理环境。大量实例管理者彼此合作、共建社区标准,展现了开放源代码软件精神所带来的积极影响。这种运作模式不仅提升了平台安全性,也促使用户更加主动地参与社区规范制定和维护,从根本上塑造了一个健康、互动强劲的数字空间。多位Mastodon高管及资深用户的实地反映亦支持这一观点。他们表示,面对恶意用户,实例封锁和联邦禁入机制能够迅速有效地消除风险,绝非传统社交平台强调的“审核无力”或“内容失控”那般不堪一击。

这种社区自净特性,反映了分布式审查和人际网络共治的优势。虽然Mastodon的内容审核非完美无缺,但其在技术设计与社区运营中能够对复杂内容进行细致、及时的管理,这值得更多人了解和认可。尤其是当大型社交媒体纷纷因信息泛滥和监管滞后而饱受诟病之时,Mastodon所代表的去中心化、分布式管理方式或许为未来网络生态保卫净土提供了可贵的路径。最终,Mastodon并非内容审核的灾难,而是内容治理创新的实验场。它挑战传统巨头模式,引领用户回归社区自治和开放自由的数字社会理想。对于希望在喧嚣社交环境中寻求安全且多元交流的用户而言,了解并主动参与Mastodon的实例选择与社区建设,将是拥有健壮网络体验的关键。

未来,随着技术发展和社区不断成熟,Mastodon的内容审核体系有望更加完善,带来更为公平与有效的网络交流环境,激发社交媒体新一轮的变革。