随着人工智能技术的飞速发展,尤其是大型语言模型(LLM)的日益普及,如何提高模型调用效率、降低调用成本成为业界亟待解决的重要课题。Semcache应运而生,作为一款由Rust语言打造的语义缓存系统,以其独特的设计理念和卓越性能,正在引领缓存技术的新方向。相较于传统的基于精确匹配的缓存机制,Semcache通过计算请求之间的语义相似度,将类似问题映射到已有缓存中,从而实现对LLM请求响应的有效复用。这不仅节约了API调用次数,也极大地提升了响应速度,为开发者带来了切实的价值。Semcache的核心优势体现在它的完全内存存储架构。所有的提示语(prompts)、响应结果及向量数据库均存储于内存中,确保读写速度快且响应延迟低。

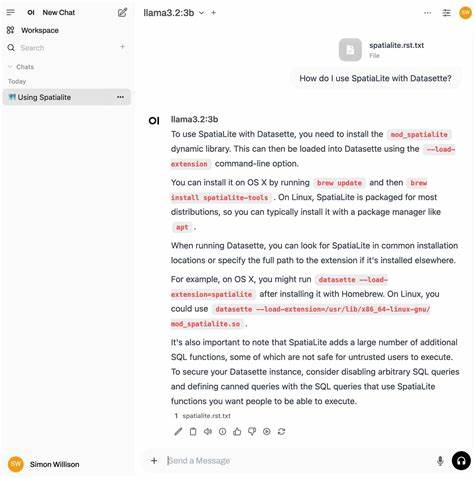

这种设计同时使得系统在处理大规模请求时依旧保持极高的吞吐量。灵活的设计使Semcache可以无缝集成各种LLM API,不论是主流的OpenAI、Anthropic,还是新兴的Gemini,都能通过统一的HTTP代理接口访问。这样的架构极大降低了开发者切换不同AI服务提供商的门槛,同时带来了统一管理和监控的便利。此外,Semcache采用了智能的最近最少使用(LRU)缓存淘汰策略,有效管理内存资源,保证缓存的实时性和有效性。系统自带的Prometheus指标输出功能令监控变得简单直观,配合内置管理后台,用户可以实时观察缓存命中率、系统负载、请求数等关键信息,助力维护和优化。使用上,Semcache支持两种主要模式:HTTP代理模式和cache-aside模式。

在HTTP代理模式下,开发者只需将AI请求的基础URL指向Semcache服务器,系统便会自动判断并返回缓存结果,或在缓存未命中的情况下转发请求至原API并缓存新结果。cache-aside模式则允许开发者手动将问题及其对应答案放入缓存中,适合特定业务场景的预加载与数据管理。举例来说,对于Python开发者,只需简单修改OpenAI SDK中的base_url参数,即可将请求路由至Semcache,轻松实现缓存加速;Node.js环境同样提供类似的配置体验,方便跨平台使用。从技术栈角度看,Semcache以Rust为核心语言,高效且安全,辅以JavaScript、Python等语言实现SDK封装,兼顾性能和易用性。项目开源且持续更新,社区活跃,积极接纳贡献,确保功能不断完善。除了技术本身,Semcache还关注企业用户需求,推出托管版本,提供定制化的文本嵌入模型、持久化存储、深度结果分析及专属技术支持。

对于需要构建长期记忆或复杂应用的企业客户,有着不小吸引力。结合当前人工智能应用的普及趋势,语义缓存的理念具备广阔的应用前景。它不仅减少重复计算,节省大量API调用费用,更缩短响应时间,提升用户体验。以Semcache为代表的方案,正逐步成为AI系统性能优化的重要利器。总的来说,Semcache通过语义相似度匹配和全内存高速缓存机制,为LLM应用带来了显著的性能提升和成本节约。其灵活适配多平台、多API、多语言开发环境的能力,进一步增强了产品竞争力。

那些追求高效、智能、可扩展解决方案的开发者和企业,值得关注和尝试这款创新工具。随着更多的功能完善和应用案例积累,Semcache有望成为未来智能缓存领域的标杆,推动AI生态的持续进步。