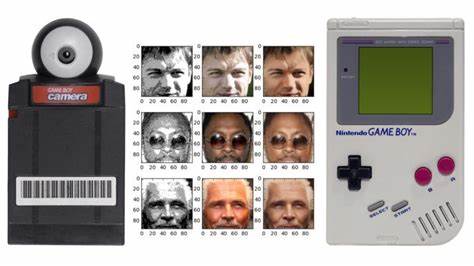

随着人工智能技术的不断进步,深度学习的应用范围也在持续拓展,覆盖了从高性能服务器到边缘设备的各类硬件平台。令人惊喜的是,神经网络推理的实现已经突破了传统硬件的限制,甚至能够运行在任天堂Game Boy这款1989年发布的经典8位掌上游戏机上。Game Boy搭载了低性能的CPU,没有浮点运算能力,硬件资源极为有限,但通过创新的算法和严格的优化,开发者成功实现在Game Boy上进行手写数字识别的神经网络推理,为复古硬件赋予了全新的生命力。神经网络在Game Boy上的运行不仅是技术爱好者的创意展示,也象征着计算机视觉和深度学习算法走向更广泛应用场景的趋势。本文将深入探讨该项目的核心技术原理、模型训练与量化策略、代码实现细节以及最终的应用体验,带读者全方位了解这一跨时代的人工智能奇迹。Game Boy本身搭载了仅有8位的CPU架构,这意味着它甚至没有专门的整数乘法指令,更别说复杂的浮点数计算。

通常神经网络的推理过程中需要大量的浮点数乘加运算以及激活函数计算,这些在Game Boy上直接执行几乎是不可能完成的任务。因此,要在该平台上实现手写数字识别,首先必须对传统神经网络实现方式进行彻底的改造。开发者采用了经典的MNIST手写数字数据库作为训练数据源,将数字样本进行二值化处理,以降低输入复杂度。不同于通常的图像识别应用,Game Boy绘图的数字是单像素笔触,为此特别利用了数学形态学中的细化算法(也称骨架化算法),保证训练与推理过程中的数字形态风格高度一致,使得模型能够准确识别稀疏笔画。训练完成的神经网络结构采用多层全连接层,并使用ReLU作为激活函数。为了适配8位CPU的计算环境,所有模型参数和中间激活值都经过严格的量化处理,从原始的32位浮点精度转变为8位整数,实现了整数运算的高效执行。

该量化方法参考了由Jacob等人提出的线性量化方案,确保了量化后模型推理的准确性与性能。量化不仅极大地减少了模型权重的存储空间(从而适配Game Boy极其有限的ROM容量),也通过避免复杂的浮点运算,优化了推理速度。推理代码由汇编语言编写,直接针对Game Boy CPU指令集进行优化,实现所有矩阵乘法和激活函数计算。由于资源限制,模型结构相对简单,但依然保持了较高的识别准确率。最终,开发者将该模型及推理程序打包为Game Boy可执行的ROM文件,用户可以在真实的Game Boy硬件或mGBA等模拟器上运行。使用者可以通过方向键移动屏幕上的“笔刷”,用A键绘制像素,用B键擦除,按Select键清屏,按Start键启动神经网络推理。

推理过程虽需约3秒,但运行完毕后会在屏幕显示识别结果,高达93.86%的准确率令人称赞。在实际使用过程中,用户体验细节也颇具巧思。例如绘制界面直观易用,数字显示清晰明了,触摸操作与游戏机操控逻辑充分结合,赋予复古设备新的交互乐趣。为了全面验证模型在真实环境中的表现,开发团队还设计了Lua自动化脚本,配合mGBA模拟器批量测试1万张MNIST数字手写图片的识别准确率,确保统计数据的全面性与可信度。这种软硬件结合的测试方式简化了评估过程,同时也展示了模拟器与脚本结合进行AI模型验证的潜力。这一项目不仅展现了神经网络的灵活可移植性,也证明了悠久历史的硬件仍能成为人工智能创新的舞台。

技术细节方面,项目采用了Python脚本训练模型,然后通过专门设计的工具将权重转换、量化并嵌入汇编代码中,利用RGBDS汇编工具链生成最终ROM。整个开发过程强调跨语言协作和工程效率,在保持代码紧凑的同时,注重推理速度和准确性的平衡。此外,项目还颇具开源精神,相关代码、训练脚本以及测试工具都已公开,方便广大开发者学习和二次开发。这不仅促进了技术交流,也为神经网络在边缘计算设备上的应用研究积累了宝贵经验。从硬件角度来看,Game Boy的16KB ROM银行体积限制极大地约束了模型大小,这促使开发者对网络结构做了极简化设计,舍弃卷积层和复杂网络结构,仅保留两层全连接网络,使得推理更高效。相较于手机或PC上的神经网络应用,这样的轻量化设计提供了良好的反思视角,帮助研究者理解神经网络压缩、量化和硬件适配的重要性。

从更宽泛的角度分析,Game Boy上的神经网络应用反映了AI模型向低资源环境的迁移趋势。未来,移动设备、物联网终端、卫生设备乃至智能可穿戴产品,都将因这种迁移技术受益。通过改进模型架构和优化算法,甚至可将深度学习推理扩展到更多老旧或低功耗设备。总之,Game Boy上的神经网络手写数字识别项目是传统娱乐硬件与现代机器学习技术创新融合的经典范例。它不仅彰显了技术极限的突破,还点燃了众多开发者对复古硬件创新应用的探索热情。在未来,我们有理由期待更多这类跨时代、跨领域的人工智能创意项目诞生,丰富我们的数字生活,激励科技革新精神。

。