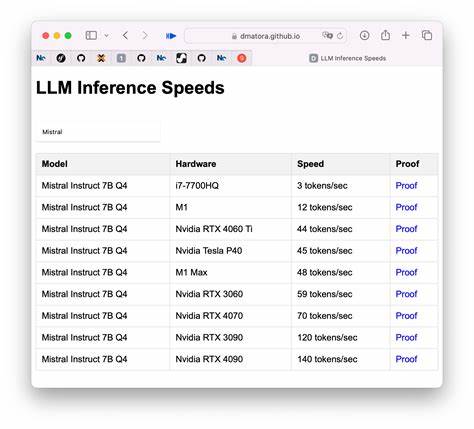

大型语言模型(LLM)近年来在自然语言处理领域取得了革命性的进展,从文本生成到语义理解,在多个应用场景中表现卓越。然而,伴随模型体量的扩大和架构的复杂化,推理时间的延长成为严重制约用户体验的瓶颈。尤其是在需要快速反馈的交互式应用中,数秒钟的延迟可能大幅降低用户满意度。如何有效提升大型语言模型的推理速度,成为广大开发者和技术团队关注的焦点。提升推理速度的思路涉及硬件的优化、模型结构设计的改良、推理算法的创新以及系统层面的高效部署。首先,硬件选择对推理速度有直接影响。

当前,大型语言模型主要依赖GPU进行推理,尤其是高性能的NVIDIA A100、H100系列显卡,可以显著缩短处理时间。若选择自托管模型,提升硬件性能是一种直接且有效的方案。同时,多卡并行计算也能实现更快的推理速率。云端服务提供商如AWS、Azure、Google Cloud等,也提供加速推理的GPU实例,结合弹性伸缩机制,帮助应对高并发请求。其次,模型压缩和轻量化是优化推理效率的重要方向。通过知识蒸馏将大型模型压缩为体积更小的学生模型,虽然牺牲部分性能,但大幅提升推理速度。

量化技术将模型中的权重和激活从32位浮点数降低至16位甚至8位整型,有效减少计算资源消耗和内存占用。同时剪枝技术剔除冗余的神经元和连接,以减轻计算负担。值得一提的是,上述技术需谨慎应用,确保生成文本的准确性和流畅度不受显著影响。第三,针对推理过程的优化也是加速的关键。传统的自回归生成方式往往逐步预测下一个词,速度较慢。改进的方法包括基于知识缓存的预测、非自回归生成技术及并行解码策略,能够在一定程度上减少推理延迟。

同时,部分框架支持动态保持模型状态,对于短文本重用上下文等场景,提高响应速度。第四,软件和系统层面的优化不可忽视。高效的推理框架如TensorRT、ONNX Runtime、DeepSpeed等,能对模型进行图优化和硬件适配,极大加速模型运行。合理规划批处理(batching)策略,动态调整请求的合并,提高硬件利用率,也能提升整体推理吞吐。同时,边缘计算与分布式推理结合,能够缩短网络传输时间,减少延时。第五,结合任务需求选用合适的模型架构也有助于速度提升。

对于只需短文本重写等简单任务,选择轻量级模型或者专门训练的小模型,能以牺牲部分复杂度换取显著推理速度。用户反馈循环中,快速响应显然优先于极致准确度。此外,创新的模型设计如稀疏激活模型、混合专家模型也在推理加速方面表现出潜力。最后,整个系统的优化必须以业务需求为导向。明确延迟的可接受范围,权衡模型容量与推理速度之间的平衡,灵活应用硬件和软件手段,才能打造令人满意的用户体验。尤其在交互体验紧密的产品中,2秒以内的响应时间成为目标,这需要从底层到应用层的多方面协同优化。

综上所述,提升大型语言模型的推理速度是一项系统性的工程,包括硬件升级、模型压缩、推理算法优化以及系统架构设计等多维度努力。只有综合利用上述技术手段,才能在保证生成质量的同时,实现令人印象深刻的响应速度,从而为用户带来更高效、更流畅的智能交互体验。随着技术的不断进步,未来推理速度将进一步提升,为更多创新应用奠定坚实基础。