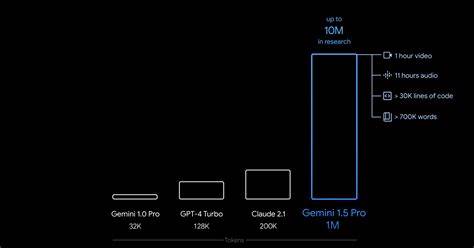

随着人工智能技术的不断进步,尤其是在大语言模型(LLM)领域,模型处理上下文数据的能力显得尤为关键。谷歌近期发布的Gemini 1.5 Pro,在上下文窗口大小上实现了重大突破,其支持令牌数从原有的100万个提升到了200万个。这一变革不仅为人工智能的应用广度和深度开辟了新天地,也预示着生成式AI技术的新阶段。令牌(Tokens)作为人工智能自然语言处理的基础单元,对于理解和生成文本起到关键作用。谷歌CEO桑达尔·皮查伊在谷歌I/O开发者大会上透露,这次将Gemini 1.5 Pro的上下文窗口容量加倍,是朝着“无限上下文”目标迈出的关键一步。上下文窗口的扩大,意味着AI模型能够在一次交流中“记住”更多的信息,处理更大规模的文本、图像乃至多媒体数据,从而提升对复杂任务或长篇交互的理解和响应能力。

令牌实际上是把文本或其他多模态数据拆分成更细粒度的单元,便于模型解析和推理。通常一个令牌相当于四个字符,内容可以包括字母、数字、空格甚至标点符号。以往大型AI模型的限制之一就是上下文窗口大小不够,限制了AI对长文本的处理能力,常常导致对话中部分信息遗忘,影响生成结果的连贯性和准确性。Gemini 1.5 Pro将上下文令牌数量提升至200万,意味着它能够处理极为庞大的信息量,比如解读整本书籍、处理复杂论文、甚至是跨领域多模态融合分析。这样,用户与AI的对话将更持久,AI也能更好地理解上下文细节,提供更准确且深入的反馈。令牌数量的增加也带来了计算资源上的巨大挑战。

处理双倍令牌意味着对算力、内存管理和模型效率提出了更高的要求。谷歌研究团队在此方面做了大量优化,包括模型架构调整、分布式计算技术应用等,才得以实现如此庞大上下文窗口的技术突破。对于开发者而言,Gemini 1.5 Pro的“私人预览”阶段意味着他们将率先体验这一新能力,将先进的自然语言处理功能整合到更多应用和服务中,推动企业智能化升级。同时,这提升了多轮对话系统的稳定性和灵活性,进一步推动智能助手、内容生成、自动摘要等场景的发展。值得注意的是,“无限上下文”仍是一个远期目标。尽管200万令牌是迄今为止非常令人瞩目的进步,但真正实现无限令牌的上下文仍需在算力和算法效率方面取得更大突破。

目前谷歌的相关研究表明,虽然可以扩展至千万级上下文窗口,但能否实现无限处理能力仍存在巨大的技术障碍。谷歌在推动AI多模态融合方面同样取得了显著成果。Gemini系列不仅可以理解文本,还能处理图片、视频和音频等多种类型的输入,令牌机制也因此扩展到视觉和听觉信息的拆分与理解。通过整合多模态数据,Gemini 1.5 Pro能够提供更丰富且准确的解释和生成,帮助用户在创作、分析及决策等多种场景下实现质的飞跃。与市场上其他领先的生成式AI产品如OpenAI的ChatGPT、微软的Copilot及Anthropic的Claude相比,Gemini 1.5 Pro的上下文窗口优势显著。更大的上下文承载能力意味着谷歌的模型在处理长文本或复杂任务时,能更好地保持信息连贯性和语义准确性,这将在商业优化、教育培训、内容创作等多个领域催生新的应用。

同时,谷歌通过开放API和私人预览模式,促进技术生态的繁荣,吸引更多开发者和企业探索基于大令牌上下文的创新解决方案。未来,随着硬件设备和云计算资源的持续进步,庞大上下文窗口将成为生成式AI的基本特征之一。应用面将遍及司法分析、医疗诊断、科学研究、金融风控等需要深度理解和长时记忆的专业领域。此外,用户体验也将更加自然贴近人类交互,AI助手能够“记住”更多历史对话内容,提供个性化且有针对性的帮助。总的来看,谷歌Gemini 1.5 Pro的200万令牌上下文窗口标志着大语言模型技术的重要跃升,是通向“无限上下文”理想的坚实步伐。技术上的突破不仅满足了当前应用对更丰富数据处理的需求,也为整个生成式人工智能行业指明了未来研发与应用的方向。

随着这一技术陆续向更多开发者和用户开放,结合谷歌在搜索、云计算及人工智能领域的综合实力,相信Gemini系列将成为引领下一个AI革新时代的关键力量。未来在技术迭代、算力提升、算法创新的共同推动下,我们有望见证更加智能、更加高效、更加人性化的AI助手走进我们的工作和生活,彻底改变人与信息互动的方式,打造一个更加智慧和便捷的数字世界。