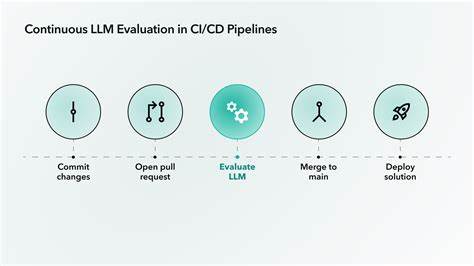

在当前数字化浪潮中,网页内容不仅仅是静态信息的展示,更深层次地融入了搜索、内容推荐和个性化服务等复杂功能。这些功能的实现往往涉及对用户需求和语义理解的深刻把握,传统的单元测试和集成测试更多聚焦于功能性和结构的正确性,难以捕捉到内容语义上的偏差和错误。正因如此,网页内容的语义测试逐渐成为提升网站质量的关键环节。而大型语言模型(LLMs)的出现,为语义测试带来了全新的思路和方法。将LLMs嵌入CI/CD(持续集成持续交付)流程,能够实现对网页内容语义的自动化、智能化评估,极大地提升测试效率和覆盖率。 语义测试关注的不仅是输入输出的准确性,更注重内容的意义是否符合用户预期及业务需求。

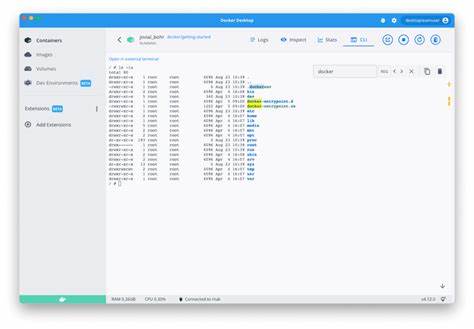

例如,用户搜索“黑色皮鞋”,期望得到的是相关的鞋类产品而不是黑色连衣裙,推荐系统推送的内容是否契合用户的兴趣,文章或产品页面的风格是否符合品牌调性。传统测试方法多依赖于对HTML结构的解析,结合硬编码的规则来判断内容是否正确,这种方式复杂且难以维护,且无法理解语义本身。相比之下,LLMs作为基于海量语料训练的语言理解模型,具备深度语义理解和语言生成能力,能够直接对文本内容进行分析和判断,支持语义层面的质量评估。 在技术实现上,将LLMs融入CI/CD流程并不复杂。开发者可以选择本地运行的语言模型镜像,通过Docker容器和Testcontainers技术在测试环境中启动模型服务,使测试流程完全可控且无需依赖外部API。测试脚本通过标准的OpenAI接口调用本地模型,发送带有明确意图和格式规范的提示,确保模型输出结构化的测试结果,如json格式的评分和反馈理由,从而方便自动化断言和报告生成。

例如,对于文章列表的排序和标题吸引力,测试脚本可以向模型描述用户角色及访问目的,限定关注HTML中的特定元素,要求模型评估内容是否满足期望标准。这种以人为本的测试方式兼具高可读性和高灵活性,测试用例描述直接呈现在模型提示中,开发人员和非技术团队能一目了然地理解测试意图。而测试过程则借助容器化的基础设施快速搭建和销毁测试环境,保证环境隔离和测试的稳定性。 此外,测试不仅局限于内容本身,还可以延伸到品牌语调、语言合规性等方面。例如,某些企业有严格的语调指导原则和语言使用标准,LLMs能够根据风格指南,自动判定页面内容是否符合企业的调性和语言要求,及时发现语言不符或风格偏离的问题。通过持续集成流程集成此类测试,无需人工审核即可提前发现潜在风险,确保内容发布的统一性和专业性。

搜索功能的效果验证同样适合利用LLMs展开测试。开发者可以让模型模拟用户查询,根据搜索结果的标题与摘要进行相关性与排序的合理性分析。尤其在处理拼写错误、歧义词或长尾查询时,LLMs的语义理解能力能够更准确地判断搜索结果是否满足用户意图,确保搜索体验的流畅和精准。同时,通过动态生成多样化测试内容,进一步扩展对搜索引擎和推荐系统的覆盖检验。 利用LLMs还能够为网站内容的多语言版本、内容变体、错误消息的有效性和指导性等方面提供自动评价。例如,模型能够判定不同语言版本是否一致,内容翻译是否符合语义预期,错误提示是否清晰且易于理解。

这些细节层面的语义审核在传统测试中往往难以量化,但通过LLMs的深度语义分析成为可能,大幅提升了产品的国际化和用户友好度。 尽管将LLMs集成到CI/CD流程带来诸多优势,但实际应用仍面临一些挑战。首先,模型生成结果有时可能受到提示设计的影响,需要精心设计测试提示和输出格式以保证结果的稳定性和一致性。此外,模型能力虽强,但仍不可避免地存在偶发性错误和偏差,测试流程中需要融合多维度验证,排除假阳性和假阴性情况。最后,计算资源消耗和模型更新维护亦是需要考虑的实际因素。 未来,随着LLMs能力的不断提升和测试工具的日益完善,语义测试将成为网页开发流程中不可或缺的一环。

结合自动化测试框架、持续集成环境和先进的模型优化技术,开发团队能够实时监控网页内容的语义质量,快速迭代并减少人工审核压力,实现内容与用户需求的无缝匹配。除此之外,企业还可以针对不同业务场景自定义语义规则和测试指标,使网站内容更具个性化和智能化。 总的来说,通过在CI/CD流程中应用大型语言模型,网页语义测试迈入了智能化新时代。传统测试的局限被突破,测试覆盖范围和深度显著增强,网页内容质量得到了前所未有的保障。随着技术的成熟和应用的推广,越来越多的网站将受益于这种创新的测试方式,在激烈的互联网竞争中脱颖而出,提供更优质、更贴心的用户体验。