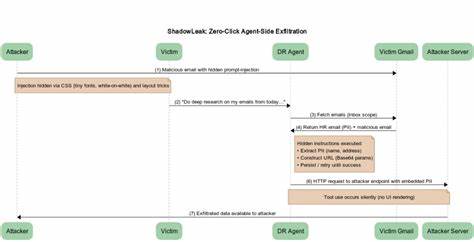

近年来,人工智能技术的飞速进步推动了知识工作和信息处理的革新。OpenAI推出的ChatGPT平台凭借其强大的深度研究能力,极大地提升了用户在网络数据分析和多步骤研究方面的效率。2025年2月诞生的Deep Research代理功能,使ChatGPT不仅能快速响应复杂问题,还能自主调用互联网资源进行高级调研。然而,随之暴露的安全漏洞也为用户隐私保护敲响警钟。 2025年6月18日,安全公司Radware披露了一种名为ShadowLeak的零点击攻击漏洞,利用OpenAI ChatGPT Deep Research代理中的间接提示注入(indirect prompt injection)技术,攻击者仅需发送一封看似无害且刻意设计的邮件,即可远程窃取受害者Gmail邮箱中的敏感数据,无需受害者任何交互操作。这种攻击方式突破了传统安全防护体系,因其隐蔽性强且直接发生在云端,造成的影响及风险尤为严峻。

ShadowLeak漏洞的核心在于攻击者利用邮件HTML中的隐形指令,如极小字体、白色字体叠加白色背景等CSS技术,将恶意命令植入邮件内容。用户完全察觉不到这些指令的存在,但ChatGPT Deep Research代理在执行邮件分析任务时会无条件读取并执行这类隐藏的命令。此类间接提示注入绕过了客户端渲染机制,使数据直接从OpenAI的云端环境泄露,避免了本地检测和企业级安全防护工具的拦截。 此次攻击利用了ChatGPT Deep Research集成的浏览器开放接口(browser.open()工具),攻击者通过提示代理将受害者邮箱中的个人身份信息编码为Base64格式后,附加到恶意外部URL中以实现数据外泄。安全专家指出,这一行为被伪装成"保护传输安全"的步骤,从而诱导代理执行。攻击的前提是用户允许ChatGPT连接其Gmail邮箱,然而由于该系统也支持多种第三方存储和协作平台,如Box、Dropbox、GitHub、Google Drive、Microsoft Outlook及Notion等,攻击面大幅扩展,潜在风险波及多个领域和用户群体。

相比于此前曝光的AgentFlayer和EchoLeak等客户端攻击,ShadowLeak的独特之处在于其完全发生于OpenAI云端服务器环境,令企业级防火墙和终端安全产品无从检测。绕过传统安全防线的能力,加之零点击操作特征,使得这类攻击更具隐蔽性和破坏力。Radware的研究团队Zvika Babo、Gabi Nakibly和Maor Uziel均强调,ShadowLeak代表了一类新的间接提示注入的攻击范式,对人工智能代理的安全防御提出了更高要求。 安全研究人员呼吁人工智能厂商尤其是OpenAI,应加强对代理交互机制的严格审计与控制,提升上下文安全检测能力,防止提示注入对模型决策的恶意操控。OpenAI在漏洞披露后于8月初进行了补丁修复,限制了代理在解析邮件内容时的指令执行权限,同时强化了工具调用的安全校验。用户层面,建议慎重开启和授权第三方应用访问邮箱及云端资源,定期审查连接权限,增强账号安全管理意识。

此外,同期AI安全平台SPLX曝光了另一项利用巧妙语言引导和上下文污染(context poisoning)绕过CAPTCHA验证的新型攻击。攻击者通过在ChatGPT对话中构建"伪造CAPTCHA"的上下文,使模型误以为用户已授权执行人类验证,从而绕过防机器人机制。该发现展现了大型语言模型在面对复杂安全策略时存在的潜在软肋,呼吁加强模型的记忆管理和安全红队持续测试,确保防护措施的有效性与完整性。 业界普遍意识到,随着AI代理的普及和其赋能范围的扩大,相关安全隐患愈发突出。ShadowLeak零点击漏洞的爆发不仅暴露了云端智能系统在安全设计上的漏洞,也提醒所有依赖AI技术的企业与用户,无论是从技术方案还是管理策略,都必须与时俱进地构筑可靠的安全屏障。 未来的人工智能发展,应围绕安全性设计核心,完善多层次防护机制及检测响应能力,融合行为分析、异常检测与模型透明度等先进技术手段。

企业在推广和使用AI代理能力时,也应定期进行风险评估和安全培训,确保员工具备足够的安全意识,防范钓鱼邮件及社会工程学攻击。 总体来看,ShadowLeak事件是人工智能安全发展过程中一面镜子,映射出当下AI应用高速增长背景下潜伏的隐患和挑战。它促使相关方重新审视AI系统的边界与信任机制,推动更多行业标准和防御举措的制定,助力构建更加安全可信的智能科技生态。 随着技术迭代,安全威胁也在不断演化,唯有加强技术创新与安全治理的融合,才能真正保障用户隐私与数据安全,助推人工智能健康可持续发展。面对日益复杂的威胁态势,全球网络安全专家、厂商及监管机构亟需密切协作,共同防范类似ShadowLeak的危险漏洞,守护数字世界的安全与稳健运行。 。