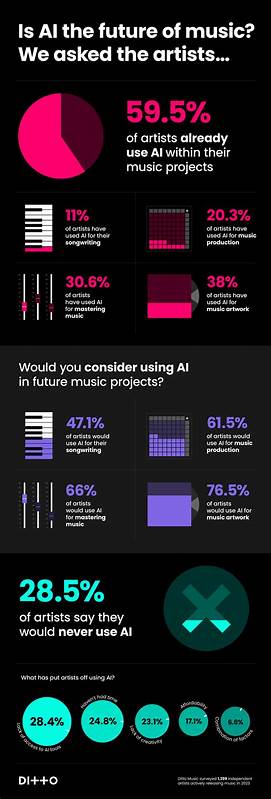

近年来,随着人工智能技术的迅猛发展,大型语言模型(LLM)如ChatGPT、Gemini、Claude等逐渐渗透到人们生活和工作的方方面面。它们能够理解和生成自然语言文本,为内容创作、信息检索、客户服务等领域带来革命性变革。然而,伴随而来的一个重要问题是"幻觉" - 即模型生成的内容虽然听起来极具说服力,但实际上却是完全虚构或错误的信息。这种现象不仅降低了模型的可靠性,还可能在高风险领域引发严重后果,亟需有效的方法来加以识别和控制。 在此背景下,CompareGPT应运而生。由开发者Tina推出的CompareGPT.io平台,致力于通过多模型对比的策略,帮助用户识别和减少LLM的幻觉现象。

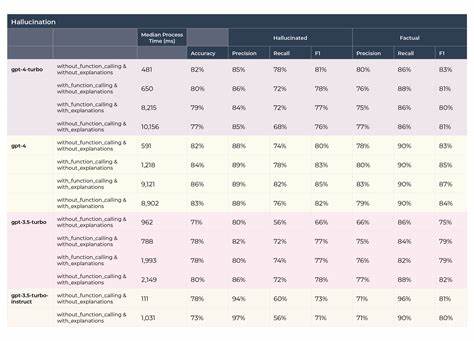

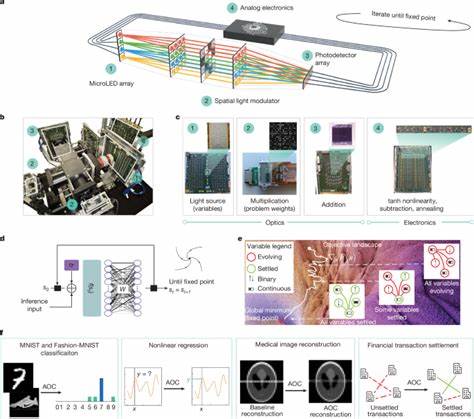

其核心理念在于不再单纯依赖单一模型的输出,而是同时调用多个主流大型语言模型的回答,进行横向对比和验证。通过这种方式,系统能够更直观呈现各模型之间的差异,帮助用户判断信息的真实性和准确性,从而显著提升AI输出内容的可信度。 CompareGPT支持ChatGPT、Gemini、Claude、Grok等多种主流模型,并通过统一API密钥管理简化使用流程,免去用户繁琐的配置操作。用户只需在平台上输入查询,便能同步获取多个模型的答案,进行对比分析。平台不仅展示了不同模型答案的相似性和差异,还为用户提供了筛选和排序功能,使得整体使用体验更加高效便捷。 多模型对比的优势在于分散了单一模型可能出现的错误或幻觉风险。

由于各模型底层训练数据和架构存在差异,它们产出的信息在细节和表述上往往不尽相同。通过观察多个模型之间的一致性,用户能够更有效地甄别哪些内容可能是事实支持的,哪些则是幻觉。尤其在涉及法律咨询、金融决策、科研验证等需要高度准确性的领域,这种策略显得尤为关键。 现实应用中,许多专业人士面对AI幻觉问题时常常感到无所适从。传统依赖单一模型的方式难以保证信息的准确性,且模型自信的表达方式容易误导用户。CompareGPT的多模型对比方法,赋予用户全新的信息判别能力,使得他们能够主动识别潜在的错误及虚假信息。

举例来说,在法律咨询场景中,多模型差异提醒用户谨慎处理相关建议,避免因幻觉信息导致的法律风险。在金融预测领域,多模型封装的综合反馈则能够帮助投资者更全面地评估市场信息,降低误判可能。 此外,CompareGPT为广大开发者和企业提供了API接入方案,使得这一多模型对比机制能够整合进现有业务流程和应用系统。通过API,用户不仅可以将多模型对比功能融入自定义平台,还能实现自动化检测幻觉输出,形成闭环的风险管控体系。这在提升产品竞争力的同时,增强了企业对AI生成内容的管理效能。 目前,CompareGPT正在积极拓展更多大型语言模型的接入,以丰富查询维度,进一步提升信息比对的全面性和精确度。

平台凭借半价早期等待名单优惠及免费终身计划赠送吸引了大量用户关注,展现出极大的市场潜力和用户需求。社区反馈也为项目优化和功能迭代提供了重要参考,使其不断完善以应对日益复杂的AI幻觉挑战。 面对未来,多模型对比或将成为治理AI幻觉的主流策略之一。随着AI技术的不断演进和应用场景的拓展,确保信息的准确性和可信度显得越发重要。CompareGPT开创性的思路和实践,为行业提供了宝贵的解决方案和参考方向。无论是普通用户、专业人士,还是企业级客户,都能借助这一工具更好地驾驭大型语言模型,推动AI技术健康、可信的发展。

综上所述,CompareGPT通过创新的多模型对比机制,有效缓解了大型语言模型幻觉带来的痛点,提升了AI输出的透明度和可靠性。其易用性、扩展性及业务融合能力,使其成为现代AI应用不可或缺的辅助工具。未来,随着更多样化模型的集成和技术优化,CompareGPT有望在治理AI幻觉领域发挥更大影响,助力全社会共同迈入更加可信的智能时代。 。