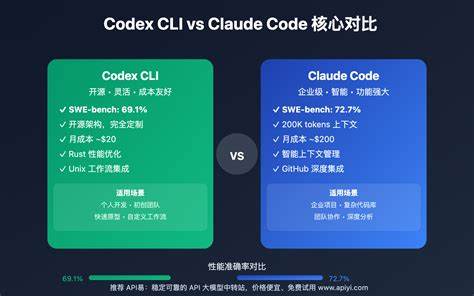

在当下软件开发领域,AI 编程助手越来越多地参与到日常调试和代码审查中。不同模型的表现往往不仅取决于语言理解能力,还体现在对工程上下文、代码风格及最小改动原则的把握上。一次看似简单的 Rails 消息顺序错乱问题,恰好提供了一个很好的对比样本:Claude Code 与 Codex 在同一提示下给出的解决方案各有侧重,也折射出两种不同的工程思路。 问题的表象很容易重现:在控制台里看到 Chat.last.messages 的输出并不是时间线上的对话顺序,而是被"打散"了。用户抱怨 AI 在生成回复时忽略了新近的用户输入,事实上症状是当系统把消息列表打包发送给 LLM 时,记录并非按照时间顺序排列。该类问题在使用 ActiveRecord 组合对象并依赖其默认行为时并不少见。

ActiveRecord 并不会在没有显式要求的情况下保证关联的返回顺序;在没有 order 子句时,数据库可能返回任意顺序,特别是在并发或缓存影响下。 Claude Code 的解决方案直接而有效:在 Chat 模型的 has_many :messages 关联上加入明确的 ordering,例如 has_many :messages, -> { order(:created_at) }, dependent: :destroy。这样的改动能确保当 Rails 加载 messages 关联时,返回的就是时间上升序的记录,避免在构建 LLM 输入时因为行顺序不定导致上下文混乱。这个修复路径快速直观,易于验证,适合在工程紧急修复场景下迅速消除故障表现。 Codex 的分析则更具洞察力和保守的工程考量。它没有立即建议新增代码,而是识别到了根本原因:框架或类库的 acts_as_chat 已经在内部定义了带有 order(created_at: :asc) 的 messages 关联,以便按时间顺序重建对话。

但应用代码随后重新定义了 has_many :messages,而在这个重新定义中缺失了 ordering,从而覆盖了原本带有排序的关联。也就是说,真正的问题并不是没有排序,而是有排序被不小心移除或覆盖。基于这一点,Codex 建议的优先选项是删除手动覆盖,恢复原有关联定义,或者在覆盖中重新加入 ordering,从而回到更少代码、更靠近库设计意图的状态。 这两种思路分别代表了不同的工程哲学。Claude Code 的方法强调直接修复症状,通过显式添加约束来保证正确性;Codex 的方法强调理解上下文并尽量减少不必要的重复代码,以维护库与应用之间的契约。对于经验丰富的工程师而言,少即是多往往是一条重要原则:保留库原本的行为能够减少重复、降低异化风险。

另一方面,在某些情况下显式添加 ordering 是更安全的做法,尤其是当依赖的库行为不够明确或可能被多个地方以不同方式使用时。 进一步分析中可见几个需要注意的技术细节。首先,使用 created_at 作为排序依据是常见的实践,但并非在所有场景下都完全可靠。创建时间的精度、时钟漂移问题以及在高并发写入下的相同时间戳都可能导致同一时间点的多条记录排序不稳定。为此,推荐在排序时同时指定次级字段,例如 order(:created_at, :id),以利用自增 id 消除同时间戳带来的歧义。其次,默认排序和显式排序的取舍需要结合上下文权衡。

default_scope 在某些项目中被用来保证全局顺序,但它也会在不经意间影响到多处查询,带来维护成本和隐蔽 bug。更可取的方式是对外暴露明确的 scope(例如 scope :chronological, -> { order(created_at: :asc, id: :asc) }),并在需要的地方显式调用,或者在关联里写成 -> { order(created_at: :asc, id: :asc) },既清晰又局部化。 在使用 AI 编程助手时,还应当考虑到模型行为的另一个维度:行为激进性与遵循权限。在示例中,Claude Code 不仅给出修复建议,还直接生成了补丁并应用,这对自动化修复场景有很高的吸引力,但也带来了风险。未经充分测试的代码变更可能影响到其他逻辑或隐藏副作用。Codex 在发现覆盖导致问题时提出了删除冗余覆盖的建议,这种"删除而不是添加"的倾向往往更安全,因为它尊重已有库设计。

然而实际工程中,需要配合代码审查、自动化测试与回滚策略,才能把 AI 的建议转化为可靠变更。 从更广的视角看,这次对比还反映了如何衡量 AI 编程助手的"好"。好助手不仅要给出能工作的代码片段,更要展示出对系统语义、依赖关系和代码简洁性的理解。衡量标准可以包含诊断深度、建议的风险性、实施成本、对原有设计的尊重程度,以及能否提出可验证的测试或回归检查。Codex 在这次测试中在诊断深度和设计一致性上占优;Claude Code 在快速修复与可验证性上表现良好。 基于以上分析,可以给开发者和团队一些实用建议来预防和定位类似问题。

首先,在任何涉及对话重建或事件回放的场景中,始终确保数据加载顺序是明确的并且被测试覆盖。对此可以增加一组集成测试,模拟消息创建的不同时间戳和乱序返回,断言最终用于 LLM 的输入是按预期排序的。其次,避免在代码中随意重写来自第三方库或内置模块的关联定义,除非有充分理由,并在重写时尽量保留并复用原有的 scope 或 ordering。第三,如果决定通过代码修复问题,优先考虑最小可行改动并配套新增测试,确保修复不会在其他用例中产生回归。 在与 AI 协作时,采用一套审慎的流程也很重要。把 AI 的输出作为初步诊断或代码草案而不是最终结论。

对关键变更实行人工审查、代码审计和回归测试。为常见的修复模式建立 checklist,例如确认排序策略、检查是否覆盖了框架默认行为、在数据库层面评估是否需要额外索引支持排序性能。对于自动应用补丁的场景,推荐先在临时分支执行,并通过 CI 全量测试后再合并到主分支。 最后,讨论模型的演进与工程实践的适配。AI 助手会不断改进,未来的版本可能在代码语义理解、跨文件上下文推理以及工程约定识别方面更强。但无论模型能力如何提升,人类工程师的系统思维仍不可替代。

AI 最擅长的是在大量模式中快速检索相似案例并建议可行路径,而人类需要在权衡长期维护成本、团队约定和架构一致性时作出最终决策。把 AI 当成能够加速诊断和提供多种修复选项的伙伴,而不是自动化的替代者,是更稳妥的合作模式。 这次 Claude Code 与 Codex 的小型测试揭示了两者各自的优势:Claude Code 在快速定位并给出直接可执行修复方面表现出色,而 Codex 在识别系统性根因和提倡最小变更原则上更具深度。对开发者而言,关键在于把这类建议纳入标准化流程,通过测试、审查和科学化的回滚机制,将 AI 的力量安全地转化为生产力提升。随着工具的迭代,结合人类工程判断的混合工作流将更加重要,能够在保障稳定性的同时,提升问题定位与修复效率。 。