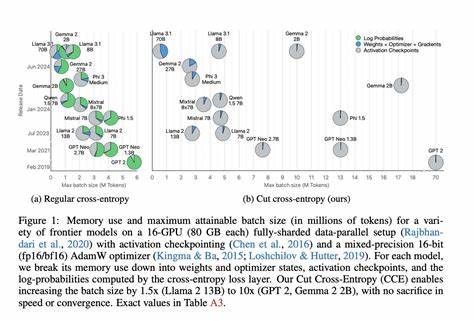

近年来,随着人工智能技术的飞速发展,大型语言模型(LLM)在自然语言处理、代码生成、复杂推理等多个领域展现出巨大潜力。Meta旗下的Llama系列模型,尤其是最新的Llama 4 Maverick 400B,凭借其庞大的参数规模和强大的功能,成为了业界关注的焦点。然而,在实际应用中,如何提升大型模型的推理速度,减少等待延迟,一直是限制AI普及和实用化的瓶颈。近日,AI硬件公司Cerebras发布了令人瞩目的成绩:他们成功实现了Llama 4 Maverick 400B模型在推理任务中的速度突破2500令牌每秒(TPS),不仅远超NVIDIA Blackwell GPU的1000令牌每秒表现,更刷新了业界纪录,成为当前最快的推理解决方案。此次突破不仅体现了硬件架构的创新优势,也预示着AI推理应用进入了一个新的高速发展阶段。 Cerebras的技术优势主要得益于其独特的AI加速器设计和高效的推理架构。

相较于传统基于GPU的推理硬件,Cerebras采用了定制的芯片组和规模化计算资源整合,能够最大化利用计算单元的并行性,从根本上减少推理延迟。Artificial Analysis作为独立第三方测试机构,针对多家主流推理厂商进行了公平评测。结果显示,在相同的Llama 4 Maverick 400B模型推理任务中,Cerebras以2522令牌每秒的速度遥遥领先,超过NVIDIA Blackwell的1038令牌每秒,领先优势超过一倍以上。同时,市场上的其他竞争者也未能接近此速度,如SambaNova、Amazon、Groq、Google和Microsoft Azure的表现均显著落后。 在推理领域,速度与延迟是衡量用户体验的关键指标。许多先进AI应用,如多步骤推理链、复杂语义理解和大规模信息检索,都对推理响应时间有极高的要求。

传统GPU虽然在某些场景具有较强性能,但在实际低延迟推理中往往受限于批处理大小和利用率,导致推理速度不足且效率低下,用户体验受影响。相比之下,Cerebras的解决方案无需依赖特殊的内核优化,也不需牺牲计算资源利用率,就能实现数倍于竞争对手的推理吞吐量,这意味着企业和开发者能够更快速地响应用户请求,更流畅地运行复杂AI应用。 Cerebras首席执行官Andrew Feldman指出,目前企业级AI的核心需求是降低推理延迟,提升应用实用价值。尤其是在智能代理、代码自动生成和多轮推理等场景中,性能瓶颈尤为显著。此前,许多应用在GPU上推理速度仅有每秒100令牌左右,导致用户等待时间长,影响生产效率和客户满意度。Cerebras此番突破,极大缓解了这一问题,为AI技术的商业化普及扫清了障碍,也为开发更智能的AI系统提供了坚实基础。

另一个值得关注的方面是Cerebras的产品与服务的可用性。此次测试中,NVIDIA的Blackwell硬件虽然性能不俗,却依赖于定制的算法和内核优化,普通用户难以直接获得类似性能,且市场上的服务提供商普遍未能达到官方公布的峰值速度。而Cerebras的硬件与API服务已面向公众开放,企业和开发者可通过Meta的API便捷接入,轻松享受领先的推理性能,这对于推动AI模型的广泛应用至关重要。 AI技术的进步不仅体现在模型的规模和复杂度上,更在于诞生出能够高效运行这些模型的硬件与软件生态。Cerebras突破性的推理速度,展示了大规模定制芯片设计如何在AI计算领域发挥决定性作用。随着AI应用日益丰富,人们对实时响应和高吞吐量的需求也不断提高,Cerebras的创新为未来AI产业链的发展指明了方向。

对于开发者和企业客户而言,Llama 4 Maverick 400B作为目前最强大的语言模型,其强大的生成与理解能力伴随着巨大的计算需求。Cerebras以其超过2500令牌每秒的推理速度,为用户敞开了通向高效智能应用的道路。无论是智能助理、知识检索还是自动化内容生成,均能体验到前所未有的效率提升。 未来,人工智能将更加深入地融入人类工作与生活的方方面面,推理速度和响应能力是核心竞争力的重要组成部分。Cerebras此次突破不仅是技术层面的胜利,更代表了AI硬件创新引领时代的趋势。企业和开发者选择具备前瞻性和性能保障的推理平台,将大幅提升自身在激烈市场环境中的竞争力。

总的来说,Cerebras在Llama 4 Maverick 400B上的卓越性能表现,不仅刷新了行业纪录,也重新定义了大型语言模型推理的可能性。随着该技术的普及,更多复杂智能应用将得以实现,促进AI与各行业的深度融合,推动数字经济步入高速发展阶段。未来,随着硬件和算法的不断优化,人工智能的推理速度和效率将持续攀升,为人类创造出更加智能、高效的未来世界。