近年来深度学习与神经科学的交汇成为科研热点,从Transformer架构的崛起到生物启发式网络的复兴,研究者在寻找能够兼顾性能、可解释性与生物可塑性的模型。Dragon Hatchling,简称BDH,是一项引起广泛关注的新型架构,被提出为可能填补Transformer与大脑模型之间的"缺失环节"。本文将从背景、核心设计、实验表现、可解释性、生物学相关性、应用前景与潜在局限等角度,对BDH进行深入解读,帮助读者理解其贡献与启示。\n\n背景回顾与动机\nTransformer自2017年问世以来以其自注意力机制在序列建模上取得了突破性进展,推动了自然语言处理、计算机视觉等领域的飞速发展。然而,Transformer的成功并未直接回答大脑如何以高效、可泛化的方式处理时间序列信息的问题。生物神经网络展示了高度的可塑性、局部交互与规模无关性等特征,这些性质被认为是实现通用推理与长期记忆的关键。

研究者因此开始探寻能兼顾工程性能和生物合理性的混合架构,旨在将神经科学原理融入可扩展的深度学习模型。BDH正是在这一背景下应运而生,提出让局部交互的神经粒子、Hebbian突触可塑性与基于注意的全局机制协同工作的方案。\n\nBDH的核心设计理念\nBDH从三个核心假设出发:局部粒子交互的可扩展性、基于突触可塑性的工作记忆实现、以及可解释性作为架构的内在属性。模型由n个局部交互的"神经粒子"组成,这些粒子通过带有可塑性的权重连接。可塑性采用Hebbian学习规则,使得在推理过程中出现的概念可以通过突触加固被短期保留。与传统Transformer依赖静态激活与显式注意矩阵不同,BDH将许多记忆功能交给可塑突触,从而让状态更新更接近生物大脑的运行方式。

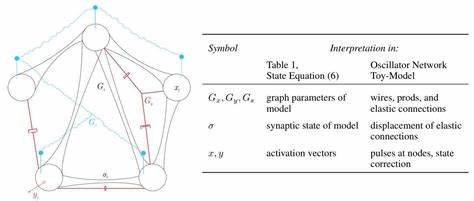

此外,BDH保留注意力导向的信息路由,使其能够在全局上下文中实现高效信息整合。\n\n状态空间与注意机制的融合\nBDH被描述为一种基于状态空间的序列学习架构,同时具备Transformer式的注意力性质。在实现上,模型既可以在图结构上被解释为高模块化、重尾度分布的神经互联网络,也可被转换为GPU友好的张量计算形式,便于工程化训练。其状态更新分为两类:粒子内部的局部动力学与突触权重的Hebbian更新。局部动力学负责对输入进行线性或非线性响应,而突触可塑性则负责记录近期激活关联,从而实现类似工作记忆的功能。注意机制通过在粒子间进行混合与加权实现全局信息传递,保证在长距离依赖建模上不落后于传统Transformer。

\n\n可解释性与稀疏正向激活\nBDH在架构层面强调可解释性,设计之初即约束激活向量为稀疏且非负,从而更容易将个体激活与语义概念挂钩。作者报告了"单语义性"(monosemanticity)现象,即某些激活或单个突触强烈对应特定概念或词项。当模型在语言输入中反复出现某一概念时,个别突触会系统性地加强其连接权重,这种行为可直接被追踪与可视化。因此BDH不仅在参数级别提供解释性,更在状态级别上使得模型的内部语义表征易于理解。这一点对于希望在工业与医学等高风险场景中部署可审计AI系统的研究者与工程师具有重要意义。\n\n生物学可塑性与尖峰神经元模拟\nBDH声称其工作记忆完全依赖于突触可塑性,并且使用尖峰神经元模型对神经活动进行建模。

尖峰神经元与Hebbian学习的结合,使得BDH在理论上更接近生物神经系统:神经元通过离散发放事件传递信息,突触在局部活动相关性下动态调整。这一机制带来了两个关键后果:其一,信息在时间上的保持不再需要大量冗余的显式隐藏状态,而是通过突触权重的短期调整实现;其二,模型呈现出更强的事件驱动特性,适合稀疏、间歇的输入模式。研究报告中还指出,BDH的神经互联网络呈现出高模块性与重尾度分布,这与许多生物大脑网络的结构性特征一致,为其生物合理性提供了进一步支撑。\n\n实验结果与性能对比\n在工程性能方面,BDH被描述为在相同参数量级(从千万到十亿级参数)和相似训练数据下,与GPT2相当。作者提供了语言建模与翻译任务的对比实验,表明BDH遵循与Transformer类似的规模律(scaling laws),即模型容量与数据规模扩大时性能持续提升。更重要的是,BDH在保持性能的同时提供了更高的可解释性与更接近生物的工作记忆实现路径。

尽管目前主流结果应由更广泛的复现实验验证,初步数据为BDH作为一种可行替代或补充架构提供了有力证据。\n\n可扩展性与GPU友好实现\n从工程角度,BDH的一个关键优势是其同时兼具图模型的解释力与张量化的计算效率。作者提出了将BDH映射为GPU友好的计算形式的方法,使得局部交互和可塑性更新可以在现代深度学习框架中高效并行运行。这解决了许多生物启发模型在实际训练中遇到的计算瓶颈问题,使得BDH在研究与工业环境中更具可操作性。\n\n意义与跨学科影响\nBDH的提出在多个层面上具有重要意义。对于机器学习领域,它提供了一种在不牺牲性能的前提下引入生物可塑性和可解释性的路径,有望推动可审计AI、节能事件驱动计算和新型记忆机制的工程化。

对于神经科学而言,BDH构建了一个可供验证与模拟的理论框架,提出了突触可塑性在语言处理与短期记忆中可能承担的具体角色,从而为实验神经科学提供可测试的假设。更广泛地,BDH作为连接理论与工程的桥梁,鼓励两大领域之间的进一步交流与合作。\n\n潜在应用场景\n结合其设计特性,BDH在若干应用场景中具有天然优势。低功耗边缘推理与事件驱动通信系统可以受益于其尖峰神经元与稀疏激活特性。需要高透明度与可审计性的行业,如医疗诊断、法律文本分析与金融决策,能够通过BDH提供更可追溯的语义映射与状态解释。教育与认知科学研究也可用BDH模拟短期记忆与概念巩固,从而提供更具体的实验设计与数据解释方案。

\n\n局限性与待验证问题\n尽管BDH提供了许多吸引人的主张,但仍有若干关键问题需要进一步验证。首先,论文中的性能对比目前主要集中于与GPT2在相同参数量级的比较,尚需更广泛基准测试覆盖更大模型、更多数据集以及下游任务的鲁棒性评估。其次,生物可塑性和尖峰神经元的抽象实现与真实神经系统之间仍存在差距,尤其在生理时间尺度、代谢成本与噪声容忍性方面需要更多实证研究。第三,可解释性的定量评估尚不完备,如何将单语义性从个别观测推广为可验证的模型特性是关键挑战之一。最后,从伦理与安全角度,任何新型架构在可解释性之外仍需考虑滥用风险、模型偏见与社会影响。\n\n未来研究方向\n为进一步推进BDH及其衍生研究,几个方向值得关注。

一是扩大复现实验规模,包含更大参数量级与多语种、多模态数据集的训练与评测,以验证其规模律与泛化能力。二是精细化可解释性指标的构建,建立系统化方法来量化单语义性、状态可追溯性与概念映射的稳定性。三是与神经科学实验紧密结合,通过神经影像学、单细胞记录等手段验证BDH提出的突触可塑性在语言加工中的可测量痕迹。四是在硬件层面推进事件驱动计算的落地,实现更加节能且生物拟态的推理器件。\n\n结语:桥梁而非替代\nDragon Hatchling并非为单纯替代Transformer而生,而更像一座桥梁,将工程可扩展性能与神经科学的可塑性、结构性洞见连接起来。其提出的将工作记忆机制从显式的激活态迁移到突触可塑性的想法,挑战了现有序列建模的传统范式,为理解大脑如何处理语言与推理提供了新的计算视角。

尽管尚需大量实验与跨学科验证,BDH代表了一个重要的探索方向:在追求更强性能的同时,也要追求更好的可解释性与生物合理性。对研究者、工程师与决策者而言,BDH提供了值得投入关注的灵感与方法论,为未来更具透明度与生物启发的人工智能奠定基础。 。