随着大语言模型(Large Language Models,简称LLM)在自然语言处理领域取得的巨大突破,人工智能系统的应用场景愈发丰富,从智能写作、机器翻译到复杂的知识抽取和对话系统,均依赖于这些庞大的预训练模型。尽管如此,传统大语言模型在面对复杂推理和多步思考问题时,常受到推理能力有限的制约,难以应对逻辑严密、需层层演绎的任务。为突破这一瓶颈,一种创新性的“推理增强”技术应运而生,促进大语言模型整体智能朝向更精细、更人性化的方向发展。推理能力是人类智力核心之一,也是衡量人工智能系统理解问题深度的关键指标。现有大语言模型尽管在文本生成和模式识别表现优异,却往往存在多步骤推理链条处理不稳定、上下文关联难以持续等问题。这就需要有针对性地增强模型的推理能力,帮助其厘清推理逻辑、抓住关键线索,实现推断准确性和灵活性的质的飞跃。

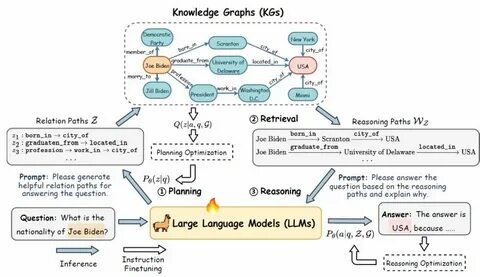

许多研究者尝试通过外部工具集成、链式思维提示(COT, Chain-of-Thought)等方法来强化推理表现,虽取得一定成效,但仍面临推理过程缺乏透明、难以解释以及泛化性不足等困境。一项最新发布的推理增强技术,致力于通过深度机制改造及训练范式优化,赋予大语言模型内嵌的“推理引擎”,使其能够在生成文本的同时,实现层层递进的信息整合与逻辑演绎。这一技术的核心在于构建和训练专门针对推理步骤的子模块,能够模拟人类思考时多维度回溯与验证过程。传统大语言模型的训练目标多集中于最大化语言流畅度与数据拟合度,而创新的推理增强方法则引入了更符合认知逻辑的训练目标,如推理正确率、推理路径连贯度等多维指标,促使模型在语义理解之外,进一步把握潜藏的逻辑关系与情境因果。这一方法通常结合大规模推理任务数据与人工设计高质量推理范例,通过强化学习和自监督学习技术,提升模型从简单事实陈述向复杂命题演绎的能力。值得注意的是,推理增强技术不仅提升了模型的准确度,也极大改善了推理结果的可解释性。

通过对推理步骤的细化与分解,系统可以输出清晰的推理路径,便于用户理解模型决策依据,增强人机协作的透明度和信任感。此外,推理增强技术还为多模态大语言模型的发展铺平了道路。在引入视觉、图像和结构化数据的联合处理时,通过高度抽象的推理机制,模型能够跨模态整合不同信息源,形成统一且逻辑自洽的推断结论。此举极大拓展了型智能系统的应用深度,如自动代码生成、高级医疗诊断帮助、复杂网络安全威胁分析等领域。在网络安全领域,强化推理能力的大语言模型更能精准分析海量威胁信息,识别隐藏的攻击模式和异常行为,支持智能化的防御体系。例如,结合深度学习与传统启发式检测的混合模型,在恶意软件分析与漏洞发现中展现出更高的检测率和响应灵敏度。

未来,推理增强技术有望与神经符号AI(neuro-symbolic AI)等前沿理念结合,进一步提升人工智能的自主推断和符号操作能力,实现从单纯数据驱动向知识驱动的跨越。这将带来更高层次的智能表现,赋予AI系统更强的常识推理、抽象思维能力,甚至触及哲学层面的智能模型构建。然而,推理增强技术的落地仍面临诸多挑战,包括训练数据标注复杂度大、计算资源消耗高、真实场景中多义性和不确定性的处理难题。研究者和工程师需持续探索更高效的算法优化策略,结合领域知识和先进硬件,推动技术可持续发展。综上所述,推理增强技术不仅是提升大语言模型智能程度的关键突破点,更是推动人工智能迈向真正“理解”与“思考”阶段的重要基石。随着技术不断成熟,未来基于此技术打造的智能系统将更加贴近人类思维模式,广泛服务于语言理解、安全防御、自动化决策等众多核心领域,引领智能新时代的到来。

。