在云原生与持续交付成为主流的今天,运维与开发团队正面临一个重要抉择:是继续在运行系统上打补丁修复问题,还是采用替换策略,用全新的、经过测试的镜像直接替换老旧实例。用一句简短的话来描述这个思路就是"替换,不修补"。不可变基础设施(Immutable Infrastructure)并非概念上的流行语,而是能显著降低部署风险、提高可观测性与可回滚能力的实践模式。理解为什么要替换而不是修补,以及如何在企业级环境中逐步采纳这种模式,对提升交付质量和运维效率至关重要。不可变基础设施的核心理念是:一旦镜像或实例被创建并部署,其运行时环境不再被手动更改。所有变更都通过重新构建镜像或配置文件,并以一套自动化流程替换旧的实例来完成。

这样的替换式部署方式与传统的增量修补形成鲜明对比,传统模式通常是在现有服务器上应用安全补丁、修改配置或直接通过 SSH 修复问题,而这些操作会导致配置漂移、难以复现的差异以及替换成本高昂的调试工作。选择替换的直接好处首先体现在可预测性上。可预测性来源于从代码到镜像再到运行实例的可控链条。CI/CD 管道负责构建、测试、签名和发布镜像,生产环境中运行的正是经过相同流水线验证过的产物。只要管道经过良好设计,运行时的不确定性就会大幅下降。其次,替换策略使得回滚变得简单。

与复杂的补丁回滚相比,替换只需重新部署先前已知良好的镜像版本即可恢复服务状态。许多平台可以将回滚流程自动化,把过去耗时的紧急修复转变为可编排的标准操作。再者,不可变基础设施推动一系列良好实践的落地。配置外部化、日志集中化、监控与告警标准化以及状态与无状态服务的分离,都是替换策略的自然要求。因为无法在运行实例上临时修补问题,团队被迫建立完善的可观测性体系和更健壮的配置管理流程,从而形成正向的工程文化。尽管优势显著,但拥抱不可变基础设施并非没有代价。

构建完整镜像比单次补丁部署在时间上更昂贵,尤其在镜像构建涉及许多外部依赖时,构建失败会直接阻断部署流程。为此,实践中常采用层化镜像构建、缓存机制以及提前构建基础镜像(golden image)来降低延迟和外部风险。存储开销也是一个现实问题。保留多版本镜像与AMI会占用镜像仓库的存储空间,虽然云存储成本持续下降,但合适的保留策略与自动清理机制仍然必要。更重要的是,企业往往面临遗留系统和复杂依赖,这些系统无法一夜之间变为不可变。大型企业需要采用混合策略,优先将无状态的应用层抽离并采用替换式部署,同时对数据库和其他有状态组件保持谨慎的策略和迁移计划。

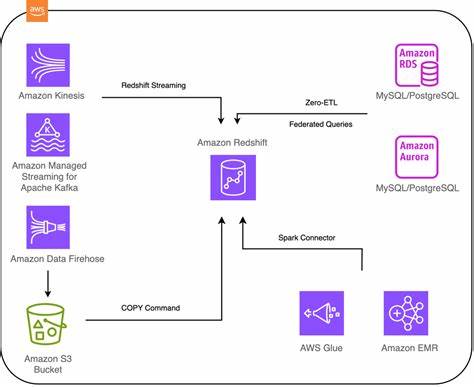

实践落地的一个常见路径是从容器化与 Kubernetes 开始。容器镜像天然契合不可变理念:镜像一经构建便不可更改,部署只需替换容器镜像标签即可。借助 Kubernetes 的滚动更新、蓝绿部署和金丝雀发布策略,可以实现平滑替换与最小化风险的流量切换。配合 GitOps 工具如 ArgoCD、Flux 等,团队只需在 Git 中变更镜像标签或配置,自动化系统便会完成部署与回滚,确保部署与审计链条完整。在虚拟机和裸金属环境中,不可变基础设施常通过镜像构建工具与自动扩缩策略实现。使用 Packer 构建 AMI,再通过 Terraform 管理 Launch Template 与 Auto Scaling Group,可以在更新时触发实例刷新,逐步替换旧实例。

这种方式兼顾了云平台的原生能力与不可变理念,使得传统工作负载也能得益于替换式部署。安全与合规是不可变基础设施的重要驱动力。通过在镜像构建阶段集成依赖扫描、漏洞扫描与合规检查,可以在早期阻止存在已知风险的构建进入运行环境。运行时的攻击面因镜像不可更改而得到限制,临时修补导致的隐藏变化也被避免。同时,镜像签名与镜像仓库访问控制构成了额外的信任链。观测与日志系统在替换策略中地位显著提升。

既然运维人员不能再通过 SSH 登录临时诊断,日志聚合、追踪和指标系统必须成为问题排查的主渠道。为此,必须在镜像和启动脚本中强制集成日志驱动器、应用性能监控(APM)埋点以及分布式追踪设置,确保在每次替换后仍能获得连续的可观测性数据。迁移到替换式模型需要的不仅是技术改造,也包含文化与流程变革。持续集成与持续交付管道成为团队信任的核心。构建失败或镜像发布不合格应被视为成功阻断的一部分,而不是值得绕过的阻碍。变更审计、版本管理与回滚剧本需要被系统地设计与演练。

故障注入与演练可以验证替换机制是否真的能在紧急情况下保证可靠恢复。对于企业迁移,建议采取分阶段策略。先从 stateless 的前端或 API 层开始,快速试错并建立模板化的镜像构建流程与回滚流程。随后扩展到中间件与缓存层,最终针对数据库与持久化服务制定迁移窗口与同步策略。实际案例表明,渐进式迁移比一次性大规模改造更能控制风险,也更易于在组织内形成推广样板。镜像管理策略是不可变基础设施的核心组成。

合理的镜像标签策略、镜像仓库清理规则、以及镜像回滚的保存期必须被定义。镜像标签推荐采用语义化版本与构建流水线元数据绑定,例如同时记录构建时间戳、提交哈希与构建环境信息,便于事后追溯。对于镜像依赖的外部仓库,应考虑建立私有镜像代理或缓存,并将关键依赖纳入内部制品库,以避免第三方源中断导致的构建失败。流水线的稳定性和速度直接影响替换策略的体验。为降低镜像构建时间,采用分层镜像、缓存基础镜像以及并行化测试流程是常见做法。持续构建基础镜像镜像库并定期更新依赖,可以把变更点限制在应用层,进一步缩短单次部署所需的时间。

在实施蓝绿或金丝雀部署时,流量管理与健康检查策略要设计得足够细致。替换实例时需要明确健康评估指标,例如启动自检、依赖服务可用性以及慢查询阈值等。金丝雀发布可以在小范围流量上验证新镜像的稳定性,再逐步扩大流量比例,发现问题时可自动回滚到旧版本。对于那些必须保持持久化配置或本地状态的组件,应采用外部化存储的策略。将状态存储在数据库、对象存储或专门的状态服务中,可以确保无状态实例的替换不会造成数据丢失。某些遗留系统需要维持固定主机名或 IP 地址的可寻址性,这时可通过负载均衡器、服务发现或虚拟 IP 机制在替换过程中保持对外接口稳定。

成本考量对企业决策影响显著。替换策略可能在短期内增加构建与镜像存储成本,但从长期看,可显著降低运维时间成本、故障处理成本以及由配置漂移导致的隐性风险。采用按需构建、镜像压缩与生命周期策略,可以进一步控制费用。人力与流程调整同样不可忽视。工程团队需要在 CI/CD、运维自动化、可观测性和安全扫描等方面投入培训与工具链改造。管理层应重视替换策略带来的文化变化,例如减少对 SSH 的依赖、强化自动化流程以及将"不可变性"作为衡量交付成熟度的指标之一。

社区与开源生态提供了丰富的工具来支持替换式部署。容器运行时、镜像仓库、GitOps 平台、基础镜像构建工具和漏洞扫描器等组成了实现路径的技术栈。合理地组合这些工具并对接现有的企业流程,可以在较短时间内交付一个可重复、可审计的替换流程。替换而非修补并不意味绝对拒绝快速修复渠道。在紧急场景下,临时性修复可能仍然存在,但关键在于把这些紧急修复纳入正式流程中:将临时变更写回版本控制,纳入镜像构建,并重新部署以保持一致性。这样既保留了应急能力,又消除了长期的配置漂移问题。

衡量替换策略成功与否的关键指标包括部署失败率、回滚次数、生产环境故障恢复时间以及由运行时手动干预导致的问题数量。通过这些指标,团队可以量化不可变实践带来的收益,并据此不断优化流水线与镜像管理策略。替换,不修补,代表着一种更可控、更可追溯的基础设施管理哲学。它将变化提前到构建阶段,减少运行时不确定性,推动团队构建更强的自动化与可观测能力。虽然短期投入不可避免,但长期收益在可靠性、可维护性与安全性上都十分明显。对于正在探索转型路径的组织,建议从可容器化的无状态服务入手,建立稳定的 CI/CD 流水线、镜像签名与扫描流程,逐步将更多层级纳入替换管理范畴。

通过分阶段推进、完善监控与演练机制,可以把不可变基础设施从理念转化为企业的长期竞争力。 。