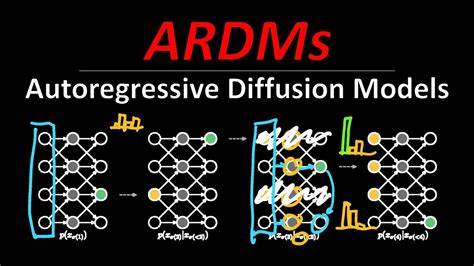

随着技术的不断进步,视频通话已经成为现代人日常交流的重要方式。然而,传统的视频通信模式在交互性、灵活性以及个性化方面仍存在诸多限制。近日,Character.AI研发团队推出的TalkingMachines框架,以面向未来的自回归扩散模型技术,开创了一个全新的实时音频驱动FaceTime式视频交互体验,不仅实现了高质量的实时虚拟头像动画,更支持无限切换“说话”和“聆听”模式,极大丰富了在线沟通的场景和方式。 TalkingMachines依托一款拥有18亿参数的大规模视频基础模型,具备强大的图像到视频生成能力,这一模型的核心优势在于其卓越的泛化能力,能够适应各种风格迥异的输入图片,由静态图像实时生成流畅而逼真的动态视频,人们可以通过摄像头或上传任意风格的头像,实现与虚拟形象的即时互动。与传统基于规则设定或简单动画驱动的系统相比,TalkingMachines利用音频信号作为驱动输入,不仅捕捉语音内容,还细腻反映语音的节奏、情感以及语调变化,精准映射到虚拟角色的口型、面部表情和动作之中,从而实现极具真实感的互动体验。 技术层面上,TalkingMachines采用了创新性的“非对称分布匹配蒸馏”(Asymmetric Distribution Matching Distillation)方法,结合双向教师网络,成功将庞大的基础模型压缩成为因果稀疏注意力架构,这一变革极大提升了模型推理效率,使大规模视频生成变得实时可行。

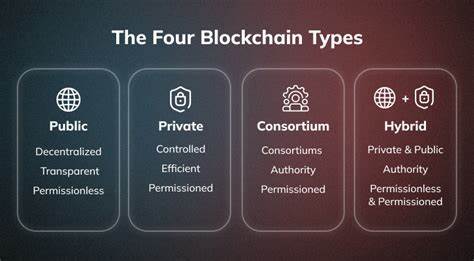

除此之外,团队还针对算力分配进行了系统级别的优化,采用分离并行的CUDA流运行得分网络与变分自编码(VAE)模型,在保持高质量视觉输出的同时,实现了高吞吐量,确保了18亿参数模型的实时运行。这不仅使TalkingMachines在桌面端上表现出色,也将移动端的用户体验提升到了新高度,兼顾了性能与便携性的完美平衡。 TalkingMachines不仅在技术实现上取得突破,更重视生态系统的整合。其架构设计支持与主流的音频大型语言模型无缝衔接,结合先进的WebRTC流媒体服务(如LiveKit),打通了音视频传输的实时通道,为视频通话、虚拟角色扮演、远程采访、在线教育、电子商务等多样场景提供了强有力的技术支撑。用户能够在各种平台上体验无缝衔接的FaceTime式交互,无论是基于自然风景的虚拟狐角色,还是电竞游戏中的个性化数字分身,亦或是具备高度拟真表现力的萌宠和二次元形象,TalkingMachines都能轻松驾驭。 面向未来,TalkingMachines所展现的创新路径标志着虚拟互动技术的全新高度。

传统视频通信往往受限于摄像头设备与环境因素,而基于音频驱动的虚拟动画不仅突破物理限制,也挖掘了更加丰富的用户表达空间,满足用户对个性化、多样化形象的需求。此外,实时的“说话”与“聆听”切换能力使得长时间对话变得流畅自然,支持无限人机轮次交互,助力构建更加沉浸和富有情感的沟通体验。 TalkingMachines不仅适用于社交娱乐领域,其潜力广泛延伸至教育行业、健康医疗、虚拟电商等多个方向。在线教学中,动态虚拟教师可实时回应学生提问,通过灵动的表情和肢体语言增强教学效果。医疗远程咨询亦可借助虚拟形象减少患者焦虑,提高互动亲和力。电商直播与虚拟试妆则因虚拟主播的拟真表演和情感共鸣获得更高转化率。

由于TalkingMachines框架支持多种图像风格输入,品牌与用户均能定制专属数字形象,促进个性化品牌传播和用户参与度提升。 可以预见,随着人工智能和计算算力的持续发展,基于自回归扩散模型的视频生成技术将更加普及和优化。TalkingMachines的示范意义,正是表明大规模模型在实时交互中的实际应用具备强大可行性和商业前景。除此之外,其开源代码库和生态系统支持也将推动社区和研究者不断探索更多创新用例,为未来虚拟现实、增强现实与混合现实领域打下坚实基础。 总结来看,TalkingMachines不仅是技术层面的突破,更是一场面向未来交流方式的革命。它将静态图片转化为富有生命力的虚拟形象,实现了高质量实时音频驱动的FaceTime风格视频通话体验。

无论是用户个人日常社交,还是企业级别的虚拟交互场景,TalkingMachines都提供了极具潜力的解决方案。随着该技术的不断成熟和完善,我们有理由期待一个更加开放、真实且富有创造力的数字互动新时代的到来。