随着人工智能领域的飞速发展,深度学习已经成为推动技术革新的核心力量。传统的神经网络设计普遍依赖激活函数来引入非线性,这一机制不仅保证了模型的表达能力,也使得训练过程趋于稳定。然而,这种设计存在一定的局限性,例如激活函数的选择对模型性能影响显著,增加了架构的复杂度和计算负担。近年来,研究人员尝试突破这一瓶颈,探索能够在无须显式激活函数的条件下实现非线性的神经网络体系。本文将深入解析一种创新的神经网络架构,该架构利用一项基于物理和几何原理的新型神经算子——ⵟ-积(Yat-product),实现非线性学习和归一化的本质融合,带来强大的表达能力和优越的训练稳定性。 传统神经网络运算过程中,点积作为计算单元的核心,既用于衡量向量间的方向相关性,也承担着输入信号加权求和的功能。

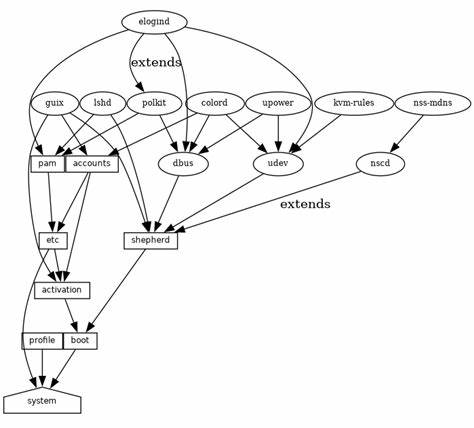

然而,点积混淆了向量的幅度和方向信息,使得模型在处理复杂几何关系时表现受限,为了弥补这一不足,网络结构通常需要引入激活函数和归一化层,从而间接实现非线性和规范化。ⵟ-积的诞生正是为了解决这一困境,它从物理学中引申出类似反平方定律的机制,将矢量对齐和空间接近度融合到一个统一且自我调节的计算操作内。 该神经算子将输入向量的乘积除以它们之间的欧氏距离的平方,实现了一种非线性映射,同时产生了一种“空间力”的效果,类似于物体间随距离变化的相互作用力。通过这种方式,模型不仅能够捕捉复杂的几何结构关系,还自动具备归一化功能,无需依赖激活层进行额外处理,为网络带来极简却强大的计算流程。 基于ⵟ-积构建的神经物质网络(Neural-Matter Networks, NMNs)展现出广泛的应用前景。这类网络架构涵盖了卷积和注意力机制的扩展版本,证明了其在图像分类和语言模型等多种基准任务上的竞争力和甚至更优性能。

NMNs所实现的表示不仅更具解释性,同时在几何上也更忠实于原始数据的结构,这一特性使得模型在实际应用中更易理解和调试。 从理论角度分析,ⵟ-积符合正半定马尔可夫核(Mercer kernel)的定义,具备通用逼近能力和稳定的梯度传播特性。通俗地说,这意味着该算子能够在不同的数据分布和任务环境下有效地建模复杂的函数映射,同时避免梯度消失或爆炸的问题,保证训练的可靠性和高效性。 此外,NMNs的设计理念植根于几何和物理原理,强调计算操作的直观解释性和自然约束,这与传统深度学习框架中过度依赖黑盒激活函数的做法截然不同。通过结合逆平方律等物理定律,模型计算过程中的各项功能如非线性映射和归一化得以固化于基础算子中,成就了“计算即物理”的新范式,增强了人工智能系统的可解释性和鲁棒性。 该架构还带来了诸多潜在优势。

首先,去除显式激活函数和归一化层简化了网络结构,使得模型参数更少,计算资源利用效率更高。其次,统一的神经算子降低了超参数调节的复杂性,提高了模型架构的设计可重复性和泛化能力。再次,几何友好的数据表示有助于提升模型在复杂任务中的适应性,尤其是在需要空间感知和结构推理的场景中表现更为出色。 在应用层面,NMNs已在图像识别任务中表现出色,能够捕捉到图像中的空间关系和结构特征,实现精确的分类和定位。同时,在语言建模领域,基于该架构的注意力机制版本有效提升了对长距离依赖和上下文联系的建模能力,推动了自然语言处理技术的前沿发展。 除了性能优越,NMNs架构天然具备更强的可解释性。

通过基于物理法则的计算机制,研究人员和工程师可以更直观地理解每一步计算的意义和作用,这对深度学习系统的安全性、可靠性及其在关键领域如医疗、金融等的应用均有积极影响。 值得一提的是,该创新技术的开源代码库已公开,方便研究者和开发者深入探索和实践,推动相关技术生态的繁荣和发展。社区内的活跃交流和持续优化,将有望催生更多基于神经物质网络的新算法和应用场景。 总体而言,神经物质网络引入的ⵟ-积算子作为核心创新,使得神经网络在无需依赖传统激活函数的前提下,实现了非线性和归一化的内在结合。这一突破不仅优化了模型结构,提高了计算效率,更通过物理和几何的视角增强了网络的可解释性和表达能力。未来,随着相关理论的深化和实践的推广,基于这样的几何感知和物理启发的新型神经网络,有望成为推动人工智能技术迈向更高层次的关键基石。

。