随着人工智能技术的飞速发展,特别是大型语言模型(LLMs)在自然语言处理和代码生成领域的突破,引发了业界对其在软件开发中应用的广泛关注。LLMs凭借其强大的语言理解和生成能力,逐渐成为代码辅助工具中的重要角色。然而,关于它们在代码审查环节中的适用范围,特别是在审查代码合并请求(PR)与全面代码库分析之间的有效性,业界存在诸多讨论和思考。理解为何LLMs更适合PR审查而非全面代码库审查,有助于合理利用这项技术,提升代码质量和开发效率。 代码合并请求通常是软件开发流程中的关键节点,是开发者针对某个特定功能或修复提交的一组代码变更。PR的代码量相对有限,且集中关注在某个具体问题或功能实现上。

这种限定的代码范围为LLMs提供了理想的理解环境。LLMs擅长处理有上下文联系的文本内容,当面对一组有限变更时,模型能够更准确地理解代码逻辑、识别潜在的错误以及提出优化建议。除了语法层面,LLMs还能够辅助理解业务逻辑是否符合设计要求,或者某些代码变更是否可能引入安全风险。 相较之下,全面的代码库审查面临更多挑战。大型软件项目通常拥有成千上万行代码,涵盖多个模块、不同编程语言和复杂的依赖关系。即便是最先进的LLMs,也难以在有限的计算资源和上下文窗口内对完整代码库进行深度理解。

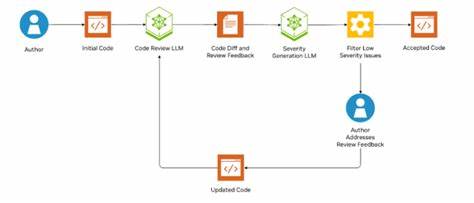

其结果通常是信息过载,导致模型难以准确推断整个系统的工作机制和各部分之间的联动效应。此外,全面代码库分析需要考虑历史提交、测试覆盖率、性能指标等多维度数据,这些信息并非单纯代码文本所能表达,限制了LLMs的审查深度。 此外,PR审查场景非常符合LLMs的交互特性。在实际开发中,审查通常包含描述性文本、提交消息和代码注释,提供了丰富的上下文信息,这些文本帮助LLMs更好地理解开发者意图和变更背景。同时,PR通常关注具体改动点,审查目标明确,这减少了模型的推理负担,提升了审查效率。基于这些优势,许多开发团队开始将LLM集成进PR自动审查流程,实现初步自动化检查,快速过滤低风险或常见错误,释放人力资源专注于更复杂的问题。

而全面代码库审查如果完全依赖LLMs,则可能导致性能瓶颈和准确度下降。由于代码库庞大,LLMs需要拆分和逐步分析,这不仅增加了计算开销,也容易遗漏跨文件或跨模块的隐性问题。同时,全面代码审查往往要求结合静态分析工具、动态调试和人工经验判断,仅凭LLMs的纯文本理解尚不能完全替代复杂的软件工程实践。综上所述,LLMs在全面代码库审查中应扮演辅助而非主导角色,协助提供代码质量洞察和技术建议,而非承担全部责任。 从团队协作和流程优化角度看,在PR级别运用LLMs提供代码审查,有助于加快合并速度,提高反馈及时性,促进持续集成和部署实践。开发者能够实时获得自动化的审查意见,减少低级错误和重复劳动。

这种应用边界清晰、反馈明确的场景,促使LLMs价值最大化,实现开发效率和代码质量的双赢。而当涉及全代码库的安全审计、性能优化或架构评审时,人类专家仍不可或缺,借助静态分析、安全工具和测试体系综合判断,确保系统整体健康与稳定。 展望未来,随着LLMs模型规模和训练数据量的持续增长,其处理大规模代码库的能力有望提升。融合多模态输入、版本历史和项目文档,LLMs将可提供更加全面和智能的代码审查支持。同时,结合专门的静态代码分析器与动态监测工具,形成多层次的代码质量保障体系。人工智能与软件工程的深度融合,有助于构建更加高效可靠的开发生态,推动软件行业向自动化、智能化迈进。

尽管LLMs在代码审查领域展现巨大潜力,但认识其适用边界尤为重要。PR审查是当前最契合LLMs优势的应用场景,因其范围适中、上下文清晰且任务明确,利于模型精准辅助判断。全面代码库分析受限于代码规模、复杂度及多维信息需求,仍是人工经验和专业工具的主战场。合理发挥LLMs在不同层级代码审查中的作用,结合人机协同,将开创更加高效且高质量的软件开发新时代。 。