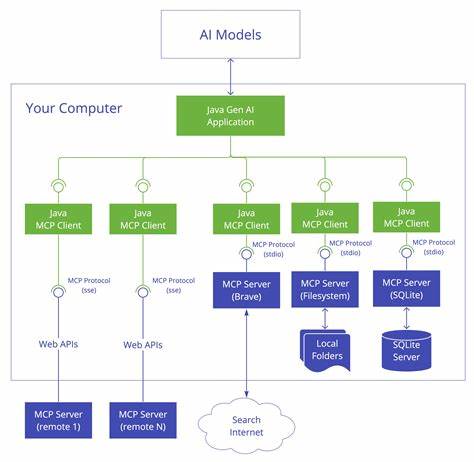

在人工智能技术日益成熟的今天,如何高效调用功能强大的模型成为了开发者关注的重点。作为OpenAI最新推理模型访问的桥梁,O3-MCP(Model Context Protocol)服务器以其卓越的性能与易用性,迅速赢得了广泛关注。通过统一且标准化的通信协议,O3-MCP实现了对o3系列模型——包括o3、o3-mini以及o3-pro的无缝接入,极大地简化了开发过程,助力构建各种智能应用。 O3-MCP的设计初衷是解决开发者在调用复杂推理模型时遇到的接口差异和集成难题。它不仅支持简单的单轮提示(prompt-based)交互,也能处理多轮上下文保持的对话模式,适应各种实际场景需求。得益于其标准化协议,O3-MCP能够兼容市面上众多MCP客户端,如Claude Desktop、Claude Code等,令模型调用变得简单高效。

安装和配置方面,O3-MCP灵活支持多种使用方法。用户无需繁琐安装即可通过npx命令快速启动服务器。对那些有长期使用需求或需要本地开发调试的用户,O3-MCP也提供了全局安装和本地源码部署方案。重要的是,配置API密钥的方法多样且安全,既可通过环境变量直接注入,也能借助.env文件统一管理,满足开发与生产环境的不同需求。 从模型性能来看,O3-MCP支持的三款模型各具特色,用户可以根据任务复杂度与资源限制灵活选择。o3模型适合完成复杂推理与代码生成任务,具备强大的分析和创作能力。

相比之下,o3-mini则以高性价比著称,适用于对速度和成本有较高敏感度的日常应用。而o3-pro作为最先进版本,拥有更深度的理解与推理能力,适合在高端场景下发挥极致优势。 在实际应用层面,O3-MCP展现出极大潜力。开发者可以将其用于代码解释、算法分析、架构设计评审、调试助手等多种场景。特别是在多轮对话中,它能够准确保存上下文,模拟真实的交互体验,这对学习复杂概念、进行创意头脑风暴以及深入技术探讨尤为重要。O3-MCP还能助力实现诸如实时协作编辑器架构讨论、递归算法调试辅助、面向REST API设计咨询等多样化需求,极大提升团队效率与沟通质量。

性能优化方面,O3-MCP通过高效的API调用管理和全面的错误处理机制,保证了服务的稳定与响应速度。其详细的日志记录和调试支持方便开发者在出现异常时快速定位问题,这对于构建稳定的生产环境尤为关键。建议开发者根据实际任务合理设定max_tokens参数,以控制输出长度,避免资源浪费和成本过高。 安全层面,O3-MCP强调了API密钥管理的重要性。推荐最佳实践包括不将密钥信息直接提交代码仓库,优先采用环境变量管理,并结合访问权限控制与频率限制策略,保障应用安全稳定运行。定期轮换API密钥也是安全运营的重要环节,防止密钥泄露带来的潜在风险。

此外,社区氛围与开源生态为O3-MCP持续发展提供了坚实基础。项目托管于GitHub,接受开发者贡献,代码透明且活跃,文档详尽,学习曲线平缓,有助于快速上手。OpenAI和Anthropic的共同支持,使得O3-MCP在技术规范和模型集成方面保持前沿,推动MCP协议及相关工具的不断完善。 面对未来,随着计算能力和模型复杂度的提升,像O3-MCP这样基于标准协议的模型访问方案将成为行业标配。它不仅降低了人工智能技术的门槛,也拓展了应用疆界。无论是初创团队的快速验证,还是大型企业的业务落地,O3-MCP均能发挥显著作用。

综上所述,O3-MCP代表着连接先进语言模型和多样化客户端场景的关键枢纽。它简化了模型调用流程,优化了交互体验,提升了开发效率。通过深入理解其架构设计、使用方法和最佳实践,AI从业者和开发者能够更好地发挥OpenAI o3系列模型的优势,推动智能应用场景迈向新高度。未来,期待更多创新基于O3-MCP展开,促进行业生态的繁荣,共同探索智能时代的无限可能。