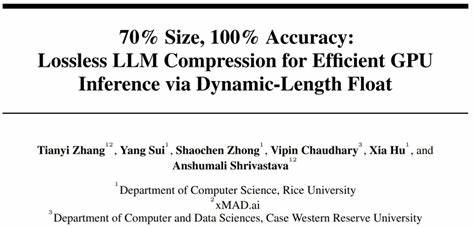

近年来,随着大型语言模型(LLM)在自然语言处理领域的广泛应用,模型规模不断扩大,参数数量激增,给计算资源和存储带来了前所未有的挑战。超大型模型如Llama-3.1-405B,其模型大小高达数百GB,迫使研究者和工程师面对GPU内存瓶颈以及推理效率低下的难题。针对这一现实需求,全新提出的动态长度浮点(Dynamic-Length Float)技术为LLM无损压缩提供了革命性的解决方案,实现了模型体积减少近30%,同时保证推理输出完全一致,无任何精度损失。 动态长度浮点技术的核心理念源于对现有权重数据格式的深入分析。当前,BFloat16作为主流的权重存储格式,在保障精度的前提下,数据冗余度极高,即权重的熵值较低,存在明显的储存效率不足现象。通过对权重频率进行统计和编码,动态长度浮点利用熵编码思想,依据不同权重的出现频率,赋予其对应的动态编码长度,从而实现接近信息理论极限的压缩率。

这种方法避免了传统压缩中因量化或剪枝带来的信息丢失,确保了模型的推理输出能够与原始模型保持绝对一致。 在技术实现层面,动态长度浮点设计了专门的GPU内核以支持高效的在线解码,解决了动态编码解压缩通常带来的计算延迟问题。特别设计的两阶段GPU内核保证了多线程读取和写入操作的协调,利用轻量级辅助变量控制线程同步,从而实现高速解码。在此过程中,大量内存密集型的查找表被拆解成适配GPU共享内存的小型查找表,极大提升了访问效率。此外,将解压操作和Transformer模块级别解码相结合,有效降低推理时延,保证端到端的高速执行。 该方法经过多款最新大型语言模型的实验验证,包括Llama-3.1、Qwen-2.5和Gemma-3,均得到了超过30%的模型尺寸缩减效果,同时推理结果保持严格的位级一致性。

更值得关注的是,与传统的模型部分卸载到CPU以满足显存限制的方式相比,动态长度浮点在生成Token的吞吐量上取得了高达1.9至38.8倍的提升。该性能优势使得在给定固定显存预算的情况下,模型能够支持长达5.3到13.17倍更长的上下文长度,极大扩展了模型应用的灵活性和场景适应性。 对于资源受限的硬件环境,动态长度浮点技术的应用尤为重要。以Llama-3.1-405B超大模型为例,毋需分布在大量服务器或云端设备,单节点8块80GB GPU即可实现整体无损推理,这种突破为大型模型在实际产品落地中节约了大量成本,降低了部署门槛。无论是企业级应用、学术研究,还是边缘计算和移动设备部署,都能从该技术获益巨大。 从产业角度看,动态长度浮点技术的面世标志着人工智能模型压缩领域进入了新的阶段。

过去的压缩技术多侧重于精度与体积的权衡,常常以牺牲一定推理准确度为代价换取更小的模型。而如今,动态长度浮点打破这一壁垒,实现了真正意义上的无损压缩,既保持了原始模型的强大能力,又极大提升了推理效率和资源利用率。 随着人工智能应用的深入发展,诸如多模态模型、超长文本生成和实时交互等需求不断增加,计算和存储压力将持续攀升。动态长度浮点为迎接这一挑战提供了关键技术保障。其所展现的强大灵活性和高效能推理能力,将促进更多创新模型和应用的诞生,为未来人工智能生态系统的发展注入新动力。 此外,开源代码和模型的发布,也将推动社区广泛采用和改进该技术,催生更多基于动态长度浮点的优化方案。

研究人员可以基于此框架探索更深入的权重编码策略、多模态数据压缩等方向,加速AI模型的轻量化进程。 综合来看,动态长度浮点技术是一项引领大型语言模型压缩与推理新时代的重要突破。它不仅解决了庞大模型在资源有限环境下的部署瓶颈,也为实现更广泛、更高效的人工智能服务奠定了坚实基础。未来,随着技术的进一步成熟和多方推动,基于动态长度浮点的LLM无损压缩方案必将成为业界标配,助力构建更智能、更普惠的计算世界。